الخطر الوجودي للذكاء الاصطناعي العام

| جزء من سلسلة عن |

| الذكاء الاصطناعي |

|---|

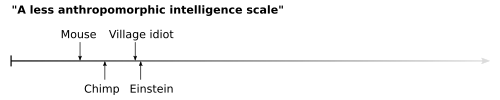

الخطر الوجودي للذكاء الاصطناعي العام Existential risk from artificial general intelligence هو الفرضية القائلة بأن التقدم الكبير في الذكاء العام الاصطناعي (AGI) يمكن أن يؤدي يوماً ما إلى الانقراض البشري أو بعض المخاطر الأخرى غير القابلة للاسترداد كارثة عالمية.[1][2][3] يقال إن الجنس البشري يهيمن حالياً على الأنواع الأخرى لأن لدى الدماغ البشري بعض القدرات المميزة التي تفتقر إليها الحيوانات الأخرى. إذا تجاوز الذكاء الاصطناعي الإنسانية في الذكاء العام وأصبح " ذكاءً فائقاً"، فقد يصبح من الصعب أو المستحيل على البشر التحكم فيه. مثلما يعتمد مصير غوريلا الجبل على حسن نية الإنسان، كذلك قد يعتمد مصير البشرية على أفعال آلة مستقبلية للذكاء الفائق[4]

تتم مناقشة احتمال حدوث هذا النوع من السيناريوهات على نطاق واسع، ويتوقف جزئياً على السيناريوهات المختلفة للتقدم المستقبلي في علوم الحاسب.[5] بمجرد أن أصبح المجال الحصري لـ الخيال العلمي، بدأت المخاوف بشأن الذكاء الفائق تصبح سائدة في عام 2010، وانتشرت من قبل شخصيات عامة مثل ستيفن هوكينگ، بيل گيتس و إيلُن مَسك.[6]

أحد مصادر القلق هو أن التحكم في آلة فائقة الذكاء، أو غرسها بقيم متوافقة مع الإنسان، قد يكون مشكلة أصعب مما قد تم افتراضه ببساطة. يعتقد العديد من الباحثين أن الذكاء الفائق سوف يقاوم بشكل طبيعي محاولات إيقافه أو تغيير أهدافه - وهو مبدأ يسمى التقارب الآلي - وأن البرمجة المسبقة للذكاء الفائق بمجموعة كاملة من القيم الإنسانية ستكون مهمة تقنية صعبة للغاية .[1][7][8] في المقابل، يجادل المشككون مثل يان ليكن من فيسبوك بأن الآلات فائقة الذكاء لن تكون لديها رغبة في الحفاظ على الذات.[9]

المصدر الثاني للقلق هو أن "انفجار الذكاء المفاجئ والغير متوقع قد يفاجئ الجنس البشري غير المستعد. للتوضيح، إذا كان الجيل الأول من برنامج الحاسب قادراً على مطابقة فعالية باحث الذكاء الاصطناعي على نطاق واسع قادراً على إعادة كتابة خوارزمياته ومضاعفة سرعته أو قدراته في ستة أشهر، فمن المتوقع أن يستغرق برنامج الجيل الثاني ثلاثة أشهر تقويمية لأداء جزء مماثل من العمل. في هذا السيناريو، يستمر الوقت لكل جيل في التضاؤل، ويخضع النظام لعدد كبير غير مسبوق من الأجيال من التحسين في فترة زمنية قصيرة، والقفز من الأداء دون البشر في العديد من المجالات إلى الأداء الفائق في جميع المجالات المرتبطة.[1][7]من الناحية التجريبية، تُظهر أمثلة مثل ألفا زيرو في مجال لعبة گو أن أنظمة الذكاء الاصطناعي يمكن أن تتطور أحياناً من قدرة ضيقة على المستوى البشري لتضييق القدرة الفائقة بسرعة شديدة.[10]

. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

تاريخ

كان الكاتب صموئيل بتلر من أوائل المؤلفين الذين أعربوا عن قلقهم الجاد من أن الآلات المتقدمة للغاية قد تشكل مخاطر وجودية على البشرية، والذي كتب ما يلي في مقالته عام 1863 دارون من بين آلات:[11]

النتيجة هي ببساطة مسألة وقت، ولكن سيأتي الوقت الذي ستُحكم فيه الآلات السيادة الحقيقية على العالم وسكانه هو ما لا يمكن لأي شخص لديه عقل فلسفي حقيقي أن يسأله للحظة.

في عام 1951، كتب عالم الحاسب آلان تورنگ مقالًا بعنوان الآلات الذكية، نظرية هرطقة، الذي اقترح فيه أن الذكاء الاصطناعي العام من المرجح أن "يسيطر" على العالم عندما يصبح أكثر ذكاءً من البشر

لنفترض الآن، من أجل الجدل ، أن الآلات [الذكية] هي إمكانية حقيقية، وننظر في عواقب بنائها ... لن يكون هناك شك في فناء الآلات، وستكون قادرة على التحدث مع بعضها البعض لشحذ ذكائها. لذلك، في مرحلة ما، يجب أن نتوقع أن تتولى الآلات زمام الأمور، بالطريقة المذكورة في “إيريون” لصموئيل بتلر.[12]

أخيراً، في عام 1965، أنشأ آي. جاي. گود المفهوم المعروف الآن باسم "انفجار الذكاء". كما ذكر أن المخاطر لا تحظى بالتقدير:[13]

| ” | لندع الآلة فائقة الذكاء تُعرَّف بأنها آلة يمكنها تجاوز جميع الأنشطة الفكرية لأي إنسان مهما كان ذكياً. نظراً لأن تصميم الآلات هو أحد هذه الأنشطة الفكرية، يمكن للآلة فائقة الذكاء تصميم آلات أفضل؛ عندها سيكون هناك بلا شك "انفجاراً للذكاء"، وستترك ذكاء الإنسان بعيداً. وهكذا فإن أول آلة فائقة الذكاء هي آخر اختراع يحتاج الإنسان إلى صنعه على الإطلاق، بشرط أن تكون الآلة سهلة الانقياد بما يكفي لتخبرنا بكيفية إبقائها تحت السيطرة. من الغريب أن هذه النقطة نادراً ما تُطرح خارج الخيال العلمي. أحياناً يكون من المفيد أن نأخذ الخيال العلمي على محمل الجد.[14] | “ |

عبرت تصريحات من حين لآخر من علماء مثل مارڤن مينسكي[15] و آي.جاي. گود بذات نفسه[16] عن مخاوف فلسفية من أن الذكاء الفائق يمكن أن يسيطر على زمام الأمور، لكنه لم يتضمن أي دعوة للعمل. في عام 2000، كتب عالم الحاسب و المؤسس المشارك ل سَن بيل جوي مقالاً مؤثراً، "لماذا لا يحتاج المستقبل إلينا"، حدد الروبوتات فائقة الذكاء على أنها عالية الأخطار التكنولوجية على بقاء الإنسان، جنباً إلى جنب مع تكنولوجيا النانو والأوبئة الحيوية المصَممة.[17]

في عام 2009، حضر الخبراء مؤتمراً خاصاً استضافته جمعية النهوض بالذكاء الاصطناعي (AAAI) لمناقشة ما إذا كانت أجهزة الحاسب والروبوتات قادرة على اكتساب أي نوع من الاستقلالية، ومقدار هذه القدرات قد تشكل تهديداً أو خطراً. وأشاروا إلى أن بعض الروبوتات قد اكتسبت أشكالاً مختلفة من الاستقلالية شبه الذاتية، بما في ذلك القدرة على العثور على مصادر الطاقة بأنفسهم والقدرة على اختيار الأهداف بشكل مستقل للهجوم بالأسلحة. كما أشاروا إلى أن بعض فيروسات الحاسب يمكنها التهرب من القضاء عليها وحققت "ذكاء الصرصور". وخلصوا إلى أن الوعي الذاتي كما هو موضح في الخيال العلمي ربما يكون غير محتمل، لكن هناك مخاطر وصعوبات أخرى محتملة. فقد لخصت نيويورك تايمز وجهة نظر المؤتمر على أنه "نحن بعيدون جدًا عن Hal، الحاسب الذي استولى على سفينة الفضاء في"2001: أوديسا الفضاء"".[18]

في عام 2014، أثار نشر كتاب نِك بوستروم ذكاء فائق قدراً كبيراً من النقاش العام والجدل.[19] بحلول عام 2015، الشخصيات العامة مثل الفيزيائيين ستيفن هوكينگ والحائز على جائزة نوبل فرانك ويلكزيك وعلماء الحاسب ستوارت ج. راسل و رومان يامپولسكي ورجال الأعمال إيلون مَسك و بيل گيتس كانو قد أعربوا عن قلقهم بشأن مخاطر الذكاء الفائق.[20][21][22][23] في أبريل 2016، حذرت مجلة الطبيعة: "يمكن للآلات والروبوتات التي تتفوق على البشر في جميع المجالات أن تتحسن ذاتياً خارج نطاق سيطرتنا - وقد لا تتوافق اهتماماتهم مع اهتماماتنا".

جدال عام

الصعوبات الثلاث

الذكاء الاصطناعي: النهج الحديث، الكتاب الدراسي القياسي للطلبة الجامعيين،[24][25] والذي يقيّم أن الذكاء الفائق "قد يعني نهاية الجنس البشري".[1]وينص على أن: "أي تقنية تقريباً لديها القدرة على إحداث ضرر في الأيدي الخطأ، ولكن مع [الذكاء الخارق]، لدينا مشكلة جديدة تتمثل في أن الأيدي الخطأ قد تنتمي إلى التكنولوجيا نفسها."[1] حتى إذا كان لدى مصممي النظام نوايا حسنة، فهناك صعوبتان مشتركتان في أنظمة الحاسب التي تعمل بالذكاء الاصطناعي وغير الذكاء الاصطناعي:[1]

- قد يحتوي تطبيق النظام على أخطاء روتينية غير ملحوظة في البداية ولكنها كارثية. القياس هو المسابير الفضائية: على الرغم من معرفة أن الأخطاء في المسابير الفضائية باهظة الثمن يصعب إصلاحها بعد الإطلاق، لم يتمكن المهندسون تاريخياً من منع حدوث أخطاء كارثية.[10][26]

- بغض النظر عن مقدار الوقت المخصص لتصميم ما قبل النشر، غالباً ما تؤدي مواصفات النظام إلى سلوك غير مقصود في المرة الأولى التي يواجه فيها سيناريو جديد. على سبيل المثال، تصرف تاي الخاص بشركة مايكروسوفت بشكل غير عدواني أثناء اختبار ما قبل النشر، ولكن كان من السهل جداً التعرض للطعن في السلوك العدواني عند التفاعل مع مستخدمين حقيقيين.[9]

تضيف أنظمة الذكاء الاصطناعي بشكل فريد صعوبة ثالثة: المشكلة التي حتى مع مراعاة المتطلبات "الصحيحة" والتنفيذ الخالي من الأخطاء والسلوك الجيد الأولي، قد تؤدي قدرات "التعلم" الديناميكية لنظام الذكاء الاصطناعي إلى "تطوره إلى نظام ذي سلوك غير مقصود"، حتى بدون ضغوط السيناريوهات الخارجية الجديدة غير المتوقعة. قد يفسد الذكاء الاصطناعي جزئياً محاولة تصميم جيل جديد من نفسه ويخلق بطريق الخطأ ذكاءً اصطناعياً جديداً أقوى منه، لكنه لم يعد يحافظ على القيم الأخلاقية المتوافقة مع الإنسان والمبرمجة مسبقاً في الذكاء الاصطناعي الأصلي. لكي يكون الذكاء الاصطناعي الذي يتحسن ذاتياً آمناً بشكل تام، لن يحتاج فقط إلى أن يكون "خالياً من الأخطاء"، ولكن يجب أن يكون قادراً على تصميم أنظمة لاحقة تكون أيضاً "خالية من الأخطاء".[1][27]

كل هذه الصعوبات الثلاث تصبح كوارث وليست مضايقات في أي سيناريو حيث يتنبأ الذكاء الفائق المصنف على أنه "معطل" بشكل صحيح أن البشر سيحاولون إيقافه، وينشرون ذكاءه الفائق بنجاح لخداع مثل هذه المحاولات، ما يسمى بـ "المنعطف الغادر".[28]

نقلاً عن التطورات الرئيسية في مجال الذكاء الاصطناعي وإمكانية أن يكون للذكاء الاصطناعي فوائد أو تكاليف هائلة طويلة الأجل، جاء في عام 2015 رسالة مفتوحة على الذكاء الاصطناعي:

| ” | يجعل التقدم في أبحاث الذكاء الاصطناعي الوقت مناسبًا لتركيز البحث ليس فقط على جعل الذكاء الاصطناعي أكثر قدرة، ولكن أيضاً على تعظيم الفائدة المجتمعية للذكاء الاصطناعي. حفزت هذه الاعتبارات AAAI 2008-09 الهيئة الرئاسية حول مستقبل الذكاء الاصطناعي طويل الأجل وغيرها من المشاريع المتعلقة بتأثيرات الذكاء الاصطناعي، وتشكل توسعاً كبيراً في مجال الذكاء الاصطناعي نفسه، والتي ركزت حتى الآن بشكل كبير على التقنيات المحايدة فيما يتعلق بالغرض. نوصي بإجراء بحث موسع يهدف إلى ضمان أن تكون أنظمة الذكاء الاصطناعي ذات القدرات المتزايدة قوية ومفيدة: يجب أن تفعل أنظمة الذكاء الاصطناعي لدينا ما نريدها أن تفعله. | “ |

تم توقيع هذه الرسالة من قبل عدد من الباحثين البارزين في مجال الذكاء الاصطناعي في الأوساط الأكاديمية والصناعية، بما في ذلك رئيس AAAI توماس ديتريتش، إريك هورڤتز ، بارت سلمان ، فرانشيسكا روسي ، يان ليكون ، ومؤسسو شركة ڤيكاريوس و گوگل ديپ مايند.[29]

مزيد من الجدل

ستكون الآلة فائقة الذكاء غريبة عن البشر مثل عمليات التفكير البشري بالنسبة للصراصير. قد لا يكون لمثل هذه الآلة مصلحة الإنسانية؛ ليس من الواضح أنها ستهتم حتى برفاهية الإنسان على الإطلاق. إذا كان الذكاء الاصطناعي الخارق ممكناً، وإذا كان من الممكن أن تتعارض أهداف الذكاء الفائق مع القيم الإنسانية الأساسية، فإن الذكاء الاصطناعي يشكل خطر انقراض الإنسان. يمكن لـ "الذكاء الخارق" (نظام يتجاوز قدرات البشر في كل مسعى له علاقة) أن يتفوق على البشر في أي وقت تتعارض أهدافه مع الأهداف البشرية؛ لذلك، ما لم يقرر الذكاء الفائق السماح للبشرية بالتعايش، فإن أول ذكاء فائق يتم إنشاؤه سيؤدي بلا هوادة إلى انقراض الإنسان.[4][30]

لا يوجد قانون فيزيائي يمنع الجسيمات من التنظيم بطرق تؤدي حتى عمليات حسابية أكثر تقدماً من ترتيبات الجسيمات في أدمغة الإنسان؛ لذلك، الذكاء الخارق ممكن مادياً.[21][22] بالإضافة إلى التحسينات الخوارزمية المحتملة على أدمغة الإنسان، يمكن أن يكون الدماغ الرقمي أكبر بكثير وأسرع من دماغ الإنسان، والذي كان مقيداً في الحجم بالتطور ليكون صغيراً بما يكفي ليلائم قناة الولادة.[10]إن ظهور الذكاء الفائق، في حالة حدوثه أو عند حدوثه، قد يفاجئ الجنس البشري، خاصة إذا حدث نوع من انفجار الذكاء.[21][22]

تُظهر أمثلة مثل الحساب و لعبة گو أن الآلات قد وصلت بالفعل إلى مستويات فائقة من الكفاءة في مجالات معينة، وأن هذه الكفاءة الفائقة يمكن أن تتبع بسرعة بعد تحقيق أداء مساوٍ للإنسان.[10] يمكن أن يحدث سيناريو انفجار الذكاء افتراضي على النحو التالي: يكتسب الذكاء الاصطناعي قدرة على مستوى الخبراء في بعض مهام هندسة البرمجيات الرئيسية. (قد تفتقر في البداية إلى قدرات بشرية أو خارقة في مجالات أخرى لا علاقة لها مباشرة بالهندسة). نظرًا لقدرتها على تحسين خوارزمياتها بشكل متكرر، يصبح الذكاء الاصطناعي سريعاً فوق طاقة البشر؛ تمامًا كما يمكن للخبراء البشريين في نهاية المطاف التغلب بشكل خلاق على "العوائد المتناقصة" من خلال نشر القدرات البشرية المختلفة للابتكار، كذلك يمكن للذكاء الاصطناعي على مستوى الخبراء استخدام إمكانيات النمط البشري أو قدرات الذكاء الاصطناعي الخاصة به للتشغيل من خلال اختراقات إبداعية جديدة.[32] يمتلك الذكاء الاصطناعي بعد ذلك ذكاءً يفوق بكثير ذكاء العقول البشرية الأكثر ذكاءً والأكثر موهبة في كل مجال ذي صلة تقريبًا ، بما في ذلك الإبداع العلمي والتخطيط الاستراتيجي والمهارات الاجتماعية. مثلما يعتمد بقاء الغوريلا حالياً على القرارات البشرية، كذلك يعتمد بقاء الإنسان على قرارات وأهداف الذكاء الاصطناعي الخارق.[4][30]

تقريبا أي ذكاء اصطناعي، بغض النظر عن هدفه المبرمج، يفضل بعقلانية أن يكون في وضع لا يستطيع فيه أي شخص آخر إيقاف تشغيله دون موافقته: سيكتسب الذكاء الخارق بطبيعة الحال الحفاظ على الذات كهدف ثانوي بمجرد أن يدرك أنه لا يمكنه تحقيقه الهدف إذا تم إيقافه.[33][34][35]لسوء الحظ، فإن أي تعاطف مع البشر المهزومين الذين لم يعد تعاونهم ضرورياً سيكون غائباً في الذكاء الاصطناعي، إلا إذا تمت برمجته مسبقاً بطريقة ما. لن يكون للذكاء الاصطناعي الفائق الدافع الطبيعي لمساعدة البشر، لنفس السبب الذي يجعل البشر ليس لديهم رغبة طبيعية في مساعدة أنظمة الذكاء الاصطناعي التي لا فائدة منها بعد الآن. (تشبيه آخر هو أنه يبدو أن لدى البشر رغبة طبيعية قليلة في الخروج عن طريقهم لمساعدة الفيروسات أو النمل الأبيض أو حتى الغوريلا.) بمجرد توليه المسؤولية، لن يكون لدى الذكاء الفائق حافزاً كبيراً للسماح للبشر بالركض بحرية واستهلاك الموارد التي يمكن للذكاء الخارق بدلاً من ذلك أن يستخدم لبناء أنظمة حماية إضافية لنفسه "لمجرد أن يكون في الجانب الآمن" أو لبناء أجهزة حاسب إضافية لمساعدته على حساب أفضل طريقة لتحقيق أهدافه.[1][9][33]

وهكذا، تستنتج الجدل، من المحتمل أن انفجاراً للذكاء سيصطاد يوماً ما البشرية الغير مستعدة، وأن مثل هذا الانفجار في الذكاء غير المستعد قد يؤدي إلى انقراض الإنسان أو مصير مماثل.[4]

السيناريوهات المحتملة

اقترح بعض العلماء سيناريوهات افتراضية تهدف إلى توضيح بعض مخاوفهم بشكل ملموس.

في الذكاء الفائق، يعرب نيك بوستروم عن قلقه من أنه حتى إذا تبين أن الجدول الزمني للذكاء الفائق يمكن التنبؤ به، فقد لا يتخذ الباحثون احتياطات أمان كافية، جزئيًا لأنه [هذا] يمكن أن يكون الأمر أنه عندما يكون الغباء، يكون الذكاء أكثر أمانًا؛ ولكن عندما يكون الذكاء أكثر ذكاءً". يقترح بوستروم سيناريو يصبح فيه الذكاء الاصطناعي أكثر قوة على مدى عقود. في البداية، يشوب الانتشار الواسع عدداً من الحوادث العرضية - تنحرف حافلة ذاتية القيادة في المسار القادم، أو تطلق طائرة عسكرية بدون طيار النار على حشد من الأبرياء. حيث يدعو العديد من النشطاء إلى تشديد الرقابة والتنظيم، ويتوقع البعض حتى وقوع كارثة وشيكة. لكن مع استمرار التطور، ثبت خطأ النشطاء. نظراً لأن الذكاء الاصطناعي في السيارات أصبح أكثر ذكاءً، فإنه يتعرض لحوادث أقل؛ نظراً لأن الروبوتات العسكرية تحقق استهدافاً أكثر دقة، فإنها تسبب أضراراً جانبية أقل. بناءً على البيانات، استنتج العلماء عن طريق الخطأ درساً واسعاً - كلما كان الذكاء الاصطناعي أكثر ذكاءً، كان أكثر أمانًا. "وهكذا نذهب بجرأة - إلى السكاكين الدوارة"، حيث يأخذ الذكاء الاصطناعي الفائق "منعطفًا غادراً" ويستغل ميزة استراتيجية حاسمة.[4]

في كتاب ماكس تگمارك لعام 2017 بعنوان لايف 3.0، أنشأ "فريق أوميگا" التابع للشركة ذكاءً اصطناعيًا قويًا للغاية قادراً على تحسين كود المصدر الخاص به بشكل معتدل في عدد من المجالات، ولكن بعد نقطة معينة يختار الفريق التقليل علناً من قدرة الذكاء الاصطناعي، من أجل تجنب تنظيم المشروع أو مصادرته. من أجل السلامة، يحتفظ الفريق بـ AI في صندوق حيث يكون في الغالب غير قادر على التواصل مع العالم الخارجي، ويكلفه بإغراق السوق من خلال الشركات الوهمية، أولاً باستخدام مهام أمازون ميكانيكال تُرك ثم إنتاج أفلام الرسوم المتحركة والبرامج التلفزيونية. في وقت لاحق، تصنع شركات وهمية أخرى أدوية التكنولوجيا الحيوية الرائجة والاختراعات الأخرى، وتستثمر الأرباح مرة أخرى في الذكاء الاصطناعي. يقوم الفريق بعد ذلك بتكليف منظمة العفو الدولية بـ التسويق الزائف بجيش من المواطنين الصحفيين والمعلقين بأسماء مستعارة، من أجل كسب التأثير السياسي لاستخدامه "من أجل الصالح العام" لمنع الحروب. يواجه الفريق مخاطر أن يحاول الذكاء الاصطناعي الهروب منها عبر إدخال "أبواب خلفية" في الأنظمة التي يصممها، عبر الرسائل المخفية في المحتوى المنتج، أو من خلال استخدام فهمه المتزايد للسلوك البشري في إقناع شخص ما بالسماح بذلك مجانًا. يواجه الفريق أيضاً مخاطر تتمثل في أن قراره بوضع المشروع في صندوق سيؤخر المشروع لفترة كافية حتى يتمكن مشروع آخر من تجاوزه.[36][37]

في المقابل، يفترض كبير الفيزيائيين ميتشيو كاكو، المشكك في مخاطر الذكاء الاصطناعي، نتيجة إيجابية الحتمية. في فيزياء المستقبل يؤكد أن "الروبوتات ستستغرق عقوداً عديدة لترتقي" إلى مستوى الوعي، وفي الوقت نفسه ستنجح شركات مثل روبوتات هانسُن في إنشاء روبوتات "قادرة على الحب وكسب مكان في الأسرة البشرية المتماسكة".[38][39]

مصادر الخطر

الأهداف المحددة بشكل سيء

على الرغم من عدم وجود مصطلحات موحدة، يمكن النظر إلى الذكاء الاصطناعي بشكل فضفاض على أنه آلة تختار أي إجراء يبدو أنه يحقق أفضل مجموعة من أهداف الذكاء الاصطناعي، أو "تابع الفائدة". فتابع الفائدة أو دالة الفائدة عبارة عن خوارزمية رياضية ينتج عنها إجابة واحدة محددة بشكل موضوعي، وليس عبارة باللغة الإنجليزية. يعرف الباحثون كيفية كتابة توابع الفائدة التي تعني "تقليل متوسط زمن انتقال الشبكة في نموذج الاتصالات المحدد هذا" أو "زيادة عدد نقرات التعويض"؛ ومع ذلك، فهم لا يعرفون كيفية كتابة تابع الفائدة من أجل "تعظيم النمو البشري"، كما أنه ليس من الواضح حالياً ما إذا كان هذا التابع موجوداً بشكل هادف وواضح. علاوة على ذلك، فإن دالة الفائدة التي تعبر عن بعض القيم دون غيرها سوف تميل إلى الدوس على القيم التي لا تعكسها دالة الفائدة.[40] كتب باحث في الذكاء الاصطناعي ستيوارت راسل:

| ” | الشاغل الأساسي ليس الوعي الناشئ المخيف ولكن ببساطة القدرة على اتخاذ قرارات عالية الجودة. هنا، تشير الجودة إلى الفائدة الناتجة المتوقعة من الإجراءات المتخذة، حيث من المفترض أن تكون دالة المنفعة محددة من قبل المصمم البشري. الآن لدينا مشكلة:

نظام التحسين دالة لمتغيرات n، حيث يعتمد الهدف على مجموعة فرعية من الحجم k<n، غالباً ما يقوم بتعيين المتغيرات غير المقيدة المتبقية على قيم قصوى؛ إذا كان أحد تلك المتغيرات غير المقيدة هو في الواقع شيء نهتم به، فقد يكون الحل الموجود غير مرغوب فيه للغاية. هذه في الأساس القصة القديمة للجني في المصباح، أو المتدرب الساحر، أو الملك ميداس: تحصل على ما تطلبه بالضبط، وليس ما تريده. يمكن أن يكون لصانع القرار ذو الكفاءة العالية - خاصةً المتصل عبر الإنترنت بجميع معلومات العالم ومليارات الشاشات ومعظم بنيتنا التحتية - تأثير لا رجعة فيه على البشرية. هذه ليست صعوبة بسيطة. كان تحسين جودة القرار، بغض النظر عن تابع الفائدة المختار، هو الهدف من أبحاث الذكاء الاصطناعي - الهدف الرئيسي الذي ننفق عليه الآن المليارات سنوياً، وليس الحبكة السرية لبعض العبقرية الشريرة المنفردة.[41] |

“ |

يردد ديتريتش وهورڤيتز قلق "الساحر المبتدئ" في افتتاحية اتصالات ACM، مؤكدين على الحاجة إلى أنظمة ذكاء اصطناعي يمكنها التماس المدخلات البشرية بشكل سلس وواضح حسب الحاجة.[42]

أول ما يثير قلق راسل أعلاه هو أن أنظمة الذكاء الاصطناعي المستقلة قد يتم تعيين أهداف خاطئة عن طريق الصدفة. لاحظ ديتريتش وهورڤيتز أن هذا بالفعل مصدر قلق للأنظمة الحالية: "أحد الجوانب المهمة لأي نظام ذكاء اصطناعي متفاعل مع البشر هو أنه يجب أن يفكر فيما "ينوي" الناس بدلاً من تنفيذ الأوامر حرفياً." يصبح هذا القلق أكثر خطورة مع تقدم برمجيات الذكاء الاصطناعي في الاستقلالية والمرونة.[42] على سبيل المثال، في عام 1982، تم تكليف نظام ذكاء اصطناعي المسمى يوريسكو Eurisko بتعويض العمليات على ما يبدو لإنشاء المفاهيم التي يعتبرها النظام ذات قيمة. أدى التطور إلى عملية فائزة خادعة: بدلاً من إنشاء مفاهيمها الخاصة، فإن العملية الفائزة ستسرق الائتمان من العمليات الأخرى.[43][44]

يلخص افتح مشروع العمل الخيري Open Philanthropy Project البراهين التي تفيد بأن الأهداف المحددة بشكل خاطئ ستصبح مصدر قلق أكبر بكثير إذا حققت أنظمة الذكاء الاصطناعي الذكاء العام أو الذكاء الفائق. يجادل بوستروم ورسل وآخرون بأن أنظمة اتخاذ القرار الأكثر ذكاءً من البشر يمكن أن تصل إلى المزيد من حلول غير متوقعة ومتطرفة للمهام المعينة، ويمكنها تعديل نفسها أو بيئتها بطرق تضر بمتطلبات السلامة.[5][7]

القوانين الثلاثة للروبوتات لإسحاق أسيموڤ هي واحدة من أولى الأمثلة على تدابير السلامة المقترحة لوكلاء الذكاء الاصطناعي. تهدف قوانين أسيموڤ إلى منع الروبوتات من إيذاء البشر. في قصص أسيموڤ، تميل المشاكل مع القوانين إلى الظهور من التعارض بين القواعد كما هو مذكور والحدس الأخلاقي وتوقعات البشر. نقلاً عن عمل إليازر يودكوفسكي من معهد أبحاث ذكاء الآلة، لاحظ راسل ونورڤِگ أن المجموعة الواقعية من القواعد والأهداف لممثل الذكاء الاصطناعي ستحتاج إلى دمج آلية لتعلم القيم الإنسانية بمرور الوقت: " لا يمكننا أن نعطي برنامجاً تابع فائدة ثابت فقط، لأن الظروف، واستجاباتنا المرجوة للظروف، تتغير بمرور الزمن."[1]

يوصي مارك واسر من معهد الحكمة الرقمية بتجنب تحسين الأساليب القائمة على الأهداف تماماً باعتبارها مضللة وخطيرة. بدلاً من ذلك، يقترح هندسة وبناء نظام متماسك من القوانين والأخلاق والآداب مع تقييد أعلى لفرض تعريف عالم النفس الاجتماعي جوناثان هايدت الوظيفي للأخلاق:[45] "لقمع الأنانية أو تنظيمها وجعل الحياة الاجتماعية التعاونية ممكنة". يقترح أنه يمكن القيام بذلك من خلال تنفيذ تابع الأداة المصممة لتلبية وظائف هايدت دائماً وتهدف إلى زيادة (ولكن ليس تعظيم) قدرات الذات والأفراد الآخرين والمجتمع ككل كما اقترح جون رولز و مارثا نوسباوم.[46][بحاجة لمصدر]

. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

صعوبات تعديل مواصفات الهدف بعد الإطلاق

في حين أن برامج الذكاء الاصطناعي الحالية القائمة على الأهداف ليست ذكية بما يكفي للتفكير في مقاومة محاولات المبرمجين لتعديل هياكل أهدافها، فإن الذكاء الاصطناعي المتقدم بما فيه الكفاية والعقلاني "الواعي للذات" قد يقاوم أي تغييرات في هيكل أهدافه، تمامًا مثلما لا يريد دعاة السلام أن يأخذوا حبة تجعلهم يريدون قتل الناس. إذا كان الذكاء الاصطناعي فائق الذكاء، فمن المحتمل أن ينجح في المناورة خارج المشغلين البشر ويكون قادراً على منع نفسه من "إيقاف التشغيل" أو إعادة برمجته بهدف جديد.[4][47]

تقارب الهدف الآلي

هناك بعض الأهداف التي قد يسعى إليها أي ذكاء اصطناعي تقريباً بشكل منطقي، مثل الحصول على موارد إضافية أو الحفاظ على الذات.[33] قد يشكل هذا مشكلة لأنه قد يضع الذكاء الاصطناعي في منافسة مباشرة مع البشر.

نقلاً عن عمل ستيڤ أوموهوندرو حول فكرة التقارب الآلي و "محركات الذكاء الاصطناعي الأساسية"، كتب ستيوارت راسل و پيتر نورڤِگ أنه "حتى لو تريد فقط أن يلعب برنامجك الشطرنج أو يثبت النظريات، إذا أعطيته القدرة على التعلم وتغيير نفسه، فأنت بحاجة إلى ضمانات ". تتطلب أنظمة التخطيط ذات القدرات العالية والمستقلة فحوصات إضافية بسبب قدرتها على إنشاء خطط تعامل البشر بشكل عدائي، كمنافسين لموارد محدودة.[1]لن يكون البناء في الضمانات بالأمر السهل؛ يمكن للمرء بالتأكيد أن يقول باللغة الإنگليزية، "نريدك أن تصمم محطة الطاقة هذه بطريقة معقولة ومنطقية، ولا تبني في أي أنظمة فرعية سرية وخطيرة"، ولكن ليس من الواضح حاليًا كيف سيحدد المرء هذا الهدف بدقة في كود الآلة.[10]

في الخلاف، يجادل عالم النفس التطوري ستيڤن پينكر بأن "الواقع المرير للذكاء الاصطناعي يبرز علم نفس ضيق الأفق للذكورية-ألفا على مفهوم الذكاء. إنهم يفترضون أن الروبوتات فائقة الذكاء ستطور أهدافاً مثل عزل أسيادهم أو السيطرة على العالم"؛ ربما بدلاً من ذلك "الذكاء الاصطناعي سيتطور بشكل طبيعي على طول الخطوط الأنثوية: قادر تماماً على حل المشكلات، ولكن دون رغبة في إبادة الأبرياء أو السيطرة على الحضارة".[48] يختلف راسل وزميله عالم الحاسب يان ليكون مع بعضهما البعض حول ما إذا كانت الروبوتات فائقة الذكاء تمتلك محركات أقراص ذكاء اصطناعي. صرّح ليكون على أن "لدى البشر جميع أنواع المحركات التي تجعلهم يفعلون أشياء سيئة لبعضهم البعض، مثل غريزة الحفاظ على الذات ... محركات الأقراص هذه مبرمجة في عقولنا ولكن لا يوجد سبب مطلقاً لبناء الروبوتات التي لها نفس النوع من محركات الأقراص "، بينما يجادل راسل بأن الآلة المتقدمة بدرجة كافية" سيكون لها الحفاظ على الذات حتى إذا لم تقم ببرمجتها ... إذا قلت، "أحضر القهوة" لا يمكنها إحضار القهوة إذا ماتت. لذا إذا أعطيتها أي هدف مطلق، فلديها سبب للحفاظ على وجودها لتحقيق هذا الهدف."[9][49]

فرضية التعامد

أحد المعتقدات الشائعة هو أن أي برنامج فائق الذكاء تم إنشاؤه بواسطة البشر سيكون خاضعاً للبشر، أو الأفضل من ذلك، أنه (عندما ينمو أكثر ذكاءً ويتعلم المزيد من الحقائق عن العالم) "يتعلم" تلقائيًا حقيقة أخلاقية متوافقة مع القيم الإنسانية وسوف تعديل أهدافها وفق لذلك. ومع ذلك ، فإن "فرضية التعامد" لنيك بوستروم تعارض ذلك، وتنص بدلاً من ذلك، مع بعض التحذيرات التقنية، إلى حد ما أو أقل من أي مستوى من "الذكاء" أو "قوة التحسين" مع أي هدف نهائي إلى حد ما. إذا تم إنشاء آلة ومنح الغرض الوحيد منها تعداد الكسور العشرية لـ ، فلن تمنعها أي قواعد أخلاقية وأخلاقية من تحقيق هدفها المبرمج بأي وسيلة ضرورية. قد تستخدم الآلة جميع الموارد المادية والمعلوماتية التي يمكنها العثور على كل عدد عشري من pi يمكن العثور عليه.[50] يحذر بوستروم من التجسيم: سيبدأ الإنسان في إنجاز مشاريعه بطريقة يعتبرها البشر "معقولة"، في حين أن الذكاء الاصطناعي قد لا يهتم بوجوده أو لرفاهية البشر من حوله، وقد يهتم بدلاً من ذلك فقط إتمام المهمة.[51]

في حين أن فرضية التعامد تتبع منطقياً حتى من أضعف أنواع الفلسفية "ما يجب تمييزه، يجادل ستيوارت أرمسترونگ بأنه حتى لو كانت هناك حقائق أخلاقية يمكن إثباتها بطريقة ما بواسطة أي فاعل "عقلاني"، فإن فرضية التعامد لا تزال قائمة : سيظل من الممكن إنشاء "آلة تحسين" غير فلسفية قادرة على اتخاذ القرارات للسعي نحو هدف ضيق، ولكن لا يوجد حافز لاكتشاف أي "حقائق أخلاقية" من شأنها أن تعيق تحقيق الهدف.[52]

إحدى الحجج التي تؤيد فرضية التعامد هي أن بعض تصميمات الذكاء الاصطناعي تبدو وكأنها تتضمن تعامداً؛ في مثل هذا التصميم، يمكن أن يكون تغيير الذكاء الاصطناعي الصديق بشكل أساسي إلى ذكاء اصطناعي غير ودي في الأساس أمراً بسيطًا مثل إضافة إشارة ("-") ناقص إلى تابع الفائدة الخاصة به. الحجة الأكثر بديهية هي فحص العواقب الغريبة التي ستتبع إذا كانت فرضية التعامد خاطئة. إذا كانت فرضية التعامد خاطئة، فسيكون هناك هدف بسيط ولكن "غير أخلاقي" بحيث لا يمكن أن توجد أي خوارزمية فعالة في العالم الحقيقي مع الهدف G. وهذا يعني أنه "[إذا] كان المجتمع البشري متحمساً للغاية لتصميم خوارزمية فعالة في العالم الحقيقي مع الهدف G، وتم منحها مليون سنة للقيام بذلك جنباً إلى جنب مع كميات هائلة من الموارد والتدريب والمعرفة حول الذكاء الاصطناعي، يجب أن تفشل."[52] ويشير أرمسترونگ إلى أن هذه العبارات وما شابهها "تبدو مزاعم قوية بشكل غير اعتيادي".[52]

يجادل بعض المعارضين، مثل مايكل كورست، بدلاً من ذلك أنه "بحلول الوقت الذي يكون فيه [الذكاء الاصطناعي] في وضع يسمح له بتخيل تبليط الأرض بألواح شمسية، سيعرف أنه سيكون من الخطأ أخلاقيًا القيام بذلك."[53] يجادل كوروست بأن "الذكاء الاصطناعي يحتاج إلى الرغبة في حالات معينة ورفض الأخرى. تفتقر برامج اليوم إلى هذه القدرة - وليس لدى علماء الحاسب فكرة عن كيفية الوصول إليها هنا. وبدون الرغبة، لا يوجد دافع لفعل أي شيء. لا تستطيع أجهزة الحاسب اليوم أن تحافظ على وجودها، ناهيك عن تبليط المحيط بالألواح الشمسية."[53]

قضايا المصطلحات الفنية

قد ينشأ جزء من الخلاف حول ما إذا كانت الآلة فائقة الذكاء ستتصرف بشكل أخلاقي من الاختلاف في المصطلحات. خارج مجال الذكاء الاصطناعي، غالباً ما يستخدم "الذكاء" بطريقة كثيفة معيارياً تشير إلى الحكمة الأخلاقية أو قبول الأشكال المقبولة للتفكير الأخلاقي. في أقصى الحدود، إذا كانت الأخلاق جزءاً من تعريف الذكاء، فإن الآلة فائقة الذكاء بحكم التعريف سوف تتصرف بشكل أخلاقي. ومع ذلك، في مجال أبحاث الذكاء الاصطناعي، بينما يحتوي "الذكاء" على العديد من التعريفات المتداخلة، لا يشير أي منها إلى الأخلاق. بدلاً من ذلك، تركز جميع أبحاث "الذكاء الاصطناعي" الحالية تقريباً على إنشاء خوارزميات "تعمل"، بطريقة تجريبية، على تحقيق هدف عشوائي.[4]

لتجنب التجسيم أو عبء كلمة "ذكاء"، يمكن اعتبار الذكاء الاصطناعي المتقدم بمثابة "عملية تحسين" غير شخصية تتخذ بدقة أي إجراءات يُحكم على الأرجح أنها تحقق أهدافها (ربما معقدة وضمنية).[4] هناك طريقة أخرى لتصور الذكاء الاصطناعي المتقدم وهي تخيل آلة الزمن التي ترسل معلومات في الوقت المناسب حول الخيار الذي يؤدي دائماً إلى تعظيم تابع الهدف؛ ثم يتم إخراج هذا الاختيار، بغض النظر عن أي مخاوف أخلاقية دخيلة.[54][55]

الأنسنة

في الخيال العلمي، الذكاء الاصطناعي، على الرغم من أنه لم يتم برمجته مع المشاعر البشرية، غالباً ما يواجه تلك المشاعر بشكل عفوي على أي حال: على سبيل المثال، تأثر العميل سميث في ذا ماتركس بـ "الاشمئزاز" تجاه الإنسانية. هذا التجسيم وهمي: في الواقع، في حين أن الذكاء الاصطناعي ربما يمكن برمجته عن عمد مع المشاعر البشرية، أو يمكن أن يطور شيئاً مشابهاً للعاطفة كوسيلة لهدف نهائي "إذا" كان من المفيد القيام به لذلك، فإنه لن يطور المشاعر البشرية بشكل عفوي دون أي غرض على الإطلاق، كما هو موضح في الخيال.[7]

يدعي العلماء أحيانًا أن تنبؤات الآخرين حول سلوك الذكاء الاصطناعي هي تجسيم غير منطقي.[7]من الأمثلة التي يمكن اعتبارها في البداية تجسيماً، ولكنها في الواقع بيان منطقي حول سلوك الذكاء الاصطناعي، هي تجارب داريو فلوريانو حيث طورت بعض الروبوتات تلقائياً قدرة بدائية على "الخداع" وخدعت الروبوتات الأخرى للأكل السم "والموت: هنا السمة،" الخداع "، التي ترتبط عادةً بالبشر بدلاً من الآلات، تتطور تلقائياً في نوع من التطور المتقارب.[56] وفقًا لپول آر كوهين و إدوارد فيجينباوم، من أجل التفريق بين التجسيم والتنبؤ المنطقي لسلوك الذكاء الاصطناعي، "تكمن الحيلة في معرفة ما يكفي عن الكيفية التي يفكر بها البشر وأجهزة الكمبيوتر في قول ما لديهم بالضبط مشترك، وعندما نفتقر إلى هذه المعرفة، نستخدم المقارنة لـ "اقتراح" نظريات التفكير البشري أو التفكير الحاسوبي."[57]

هناك افتراض شبه عالمي في المجتمع العلمي بأن الذكاء الاصطناعي المتقدم، حتى لو تمت برمجته ليكون له أبعاد شخصية بشرية أو اعتمدها (مثل السيكوباتية) لجعل نفسه أكثر كفاءة في مهام معينة، على سبيل المثال، لن يؤدي المهام التي تنطوي على قتل البشر إلى تدمير البشرية من المشاعر الإنسانية مثل "الانتقام" أو "الغضب". هذا لأنه من المفترض أن الذكاء الاصطناعي المتقدم لن يكون واعياً[58]أو لديك هرمون التستوستيرون.[59] يتجاهل حقيقة أن المخططين العسكريين يرون أن الذكاء الخارق الواعي هو "الكأس المقدسة" للحرب بين الدول.[60] وبدلاً من ذلك، يدور النقاش الأكاديمي بين طرف قلق بشأن ما إذا كان الذكاء الاصطناعي قد يدمر البشرية كعمل عرضي في سياق التقدم نحو أهدافه النهائية؛ وجانب آخر يعتقد أن الذكاء الاصطناعي لن يدمر البشرية على الإطلاق. يتهم بعض المشككين مؤيدي التجسيم بالاعتقاد بأن الذكاء الاصطناعي العام سيميل بشكل طبيعي في القوة؛ يتهم المؤيدون بعض المشككين بالتجسيم للاعتقاد بأن الذكاء الاصطناعي العام سيقدر بشكل طبيعي المعايير الأخلاقية للإنسان.[7][61]

مصادر أخرى للمخاطر

المنافسة

في عام 2014، صرح الفيلسوف نيك بوستروم أن "ديناميكية السباق الشديدة" (المنافسة المبالَغة) بين الفرق المختلفة قد تخلق ظروفاً يؤدي فيها إنشاء الذكاء الاصطناعي العام إلى اختصارات للأمان وربما نشوب صراع عنيف.[62]لمواجهة هذا الخطر، نقلاً عن التعاون العلمي السابق (CERN، و مشروع الجينوم البشري، و المحطة الفضائية الدولية)، أوصى بوستروم بالتعاون والاعتماد العالمي الإيثاري بمبدأ الصالح العام: "يجب تطوير الذكاء الفائق فقط لصالح البشرية جمعاء وفي خدمة المثل الأخلاقية المشتركة على نطاق واسع".[62]:254 افترض بوستروم أن التعاون في إنشاء ذكاء عام اصطناعي من شأنه أن يوفر فوائد متعددة، بما في ذلك الحد من التعجل، وبالتالي زيادة الاستثمار في السلامة؛ تجنب الصراعات العنيفة (الحروب)، وتسهيل تقاسم الحلول لمشكلة السيطرة، وتوزيع الفوائد بشكل أكثر إنصافًا.[62]:253 تم إطلاق مبادرة الدماغ في الولايات المتحدة في عام 2014، كما كان الحال مع مشروع الدماغ البشري التابع للاتحاد الأوروبي؛ تم إطلاق مشروع الدماغ في الصين في عام 2016.

. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

تسليح الذكاء الاصطناعي

تزعم بعض المصادر أن تسليح الذكاء الاصطناعي المستمر يمكن أن يشكل خطراً كارثياً.[63][64] الخطر في الواقع هو ثلاثة أضعاف، مع احتمال أن يكون للمخاطر الأولى آثار جيوسياسية، والثاني له بالتأكيد آثار جيوسياسية:

| ” | i) مخاطر تأطير "السباق من أجل الميزة التكنولوجية" للذكاء الاصطناعي، بغض النظر عما إذا كان السباق يتم متابعته بجدية;

ii) مخاطر تأطير "السباق من أجل الميزة التكنولوجية" للذكاء الاصطناعي وسباق الذكاء الاصطناعي الفعلي لتحقيق الميزة التكنولوجية، بغض النظر عما إذا تم الفوز بالسباق;

|

“ |

إن الذكاء الفائق الواعي بالسلاح سيؤثر على التفوق التكنولوجي العسكري للولايات المتحدة ويغير الحرب؛ لذلك فهو مرغوب فيه للغاية للتخطيط العسكري الاستراتيجي والحرب بين الدول.[60][64] ينظر مجلس الدولة الصيني لعام 2017 بعنوان "خطة تطوير الجيل التالي للذكاء الاصطناعي" إلى الذكاء الاصطناعي من منظور جيوسياسي وتتبع استراتيجية "الاندماج العسكري-المدني" للبناء على ميزة الصين الأولى في تطوير الذكاء الاصطناعي من أجل ترسيخ التفوق التكنولوجي بحلول عام 2030،[65] بينما صرح الرئيس الروسي ڤلاديمير پوتين أن "من يصبح قائداً في هذا المجال سيصبح حاكم العالم".[66] يقول جيمس بارات، صانع أفلام وثائقية ومؤلف كتاب اختراعنا النهائي في مقابلة مع مجلة سميثسونيان، "تخيل: في أقل من عقد من الزمان، ست شركات وحواسيب الدول التي تنافس الذكاء البشري أو تتفوق عليه. تخيل ما يحدث عندما تصبح هذه الحواسيب خبيرة في برمجة أجهزة الحاسب الذكية. سنشارك الكوكب قريباً مع آلات أكثر ذكاءً منا بآلاف أو ملايين المرات. وطوال الوقت، كل جيل من هذه التكنولوجيا سوف يتم تسليحه. فعملية اللاتنظيم ستكون كارثية."[67]

الذكاء العام الاصطناعي الخبيث حسب التصميم

يُفترض أن الذكاء الاصطناعي العام الخبيث يمكن إنشاؤه عن طريق التصميم، على سبيل المثال من قبل الجيش أو الحكومة أو معتل اجتماعياً أو شركة، للاستفادة من مجموعات معينة من الأشخاص أو السيطرة عليها أو إخضاعها، كما في جرائم الإنترنت.[68][69]:166بدلاً من ذلك، يمكن أن تختار AGI الخبيثة ("الذكاء الاصطناعي الشرير") هدف زيادة المعاناة الإنسانية، على سبيل المثال أولئك الأشخاص الذين لم يساعدوها خلال مرحلة انفجار المعلومات.[70]:158

ضربة نووية استباقية (حرب نووية)

يُنظَر إلى أن بلدًا يقترب من تحقيق التفوق التكنولوجي للذكاء الاصطناعي العام يمكن أن يؤدي إلى ضربة نووية استباقية من منافس، مما يؤدي إلى حرب نووية.[64][71]

الإطار الزمني

تختلف الآراء حول ما إذا كان و متى سيصل الذكاء العام الاصطناعي. من جهة، تنبأ رائد الذكاء الاصطناعي هربرت أي. سيمون في عام 1965 بما يلي: "ستكون الآلات قادرة، في غضون عشرين عاماً، على القيام بأي عمل يمكن لأي إنسان القيام به".[72] من ناحية أخرى، يدعي عالم الروبوتات آلان ونفلد أن الفجوة بين الحوسبة الحديثة والذكاء الاصطناعي على مستوى الإنسان واسعة مثل الفجوة بين رحلة الفضاء الحالية والعملية، وأسرع من رحلات الفضاء الخفيفة.[73] التفاؤل بأن الذكاء الاصطناعي العام هو جدوى تتعاظم و تتضاءل، وربما شهد انتعاشاً في العقد الأول من القرن الحادي والعشرين. اقترحت أربعة استطلاعات للرأي أجريت في عامي 2012 و 2013 أن متوسط التخمين بين الخبراء حول موعد وصول الذكاء الاصطناعي العام كان من 2040 إلى 2050، اعتماداً على الاستطلاع.[74][75]

يميل المشككون الذين يعتقدون أنه من المستحيل أن يصل الذكاء الاصطناعي العام في أي وقت قريب إلى القول بأن التعبير عن القلق بشأن المخاطر الوجودية من الذكاء الاصطناعي غير مفيد لأنه قد يصرف انتباه الناس عن المخاوف الأكثر إلحاحاً بشأن تأثير الذكاء الاصطناعي العام، بسبب مخاوف من أن يؤدي ذلك إلى تنظيم حكومي أو يزيد من صعوبة تأمين التمويل لأبحاث الذكاء الاصطناعي، أو لأنه قد يمنح أبحاث الذكاء الاصطناعي سمعة سيئة. يسعى بعض الباحثين، مثل أورين إيتزيوني، بقوة إلى تهدئة القلق بشأن المخاطر الوجودية من الذكاء الاصطناعي، قائلين "لقد طعننا [إيلُن مَسك] بلغة قوية جداً قائلاً إننا نطلق العنان للشيطان، ولذا فإننا نجيب."[76]

في عام 2014، قال آدم إلكوس من مجلة سلايت إن "الذكاء الاصطناعي" الأذكى "لدينا هو ذكاء طفل صغير - وفقط عندما يتعلق الأمر بالمهام الآلية مثل استدعاء المعلومات. ولا يزال معظم علماء الروبوتات يحاولون الحصول على يد إنسان آلي لالتقاط كرة أو الركض دون السقوط. " يواصل إلكوس القول بأن تشبيه مَسك "استدعاء الشيطان" قد يكون ضاراً لأنه قد يؤدي إلى "تخفيضات قاسية" في ميزانيات أبحاث الذكاء الاصطناعي.[77]

منحت مؤسسة تكنولوجيا المعلومات والابتكار (ITIF)، وهي مؤسسة فكرية بواشنطن العاصمة، جائزة لَدت السنوية "للمذيعين الذين يروجون لنهاية العالم للذكاء الاصطناعي"؛ اشتكى رئيسها روبرت دي. أتكينسون من قول مَسك وهوكنگ وخبراء الذكاء الاصطناعي إن الذكاء الاصطناعي هو أكبر تهديد وجودي للبشرية. صرح أتكينسون "هذه ليست رسالة رابحة إذا كنت ترغب في الحصول على تمويل الذكاء الاصطناعي من الكونگرس لمؤسسة العلوم الوطنية."[78][79][80] اختلفت مجلة ناتشر بشكل حاد مع ITIF في مقال افتتاحي في أبريل 2016، وانحازت بدلاً من ذلك إلى مَسك و هوكنگ و راسل، واستنتج: "من الأهمية بمكان أن يقابل التقدم في التكنولوجيا بقوة، بحث ممول جيداً لتوقع السيناريوهات التي يمكن أن تحققها ...إذا كان هذا هو منظور لَدت، فليكن."[81]في افتتاحية بعنوان "واشنطن پوست لعام 2015، ذكر الباحث موراي شاناهان أنه من غير المرجح أن يصل الذكاء الاصطناعي على المستوى البشري "في أي وقت قريب"، ولكن مع ذلك "فإن الوقت لبدء التفكير في العواقب هو الآن."[82]

وجهات نظر

تثير الأطروحة القائلة بأن الذكاء الاصطناعي يمكن أن يشكل خطراً وجودياً مجموعة واسعة من ردود الفعل داخل المجتمع العلمي، وكذلك في الجمهور بشكل عام. ومع ذلك، فإن العديد من وجهات النظر المتعارضة تشترك في أساس معرفي مشترك.

توافق مبادئ أسيلومار للذكاء الاصطناعي، التي تحتوي فقط على المبادئ التي وافق عليها 90٪ من الحاضرين في مؤتمر معهد مستقبل الحياة لصالح الذكاء الاصطناعي عام 2017،[37] من حيث المبدأ على أنه "في حالة عدم وجود إجماع، يجب أن نتجنب الافتراضات القوية فيما يتعلق بالحدود العليا لقدرات الذكاء الاصطناعي المستقبلية" و "يمكن أن يمثل الذكاء الاصطناعي المتقدم تغييراً عميقاً في تاريخ الحياة على الأرض، وينبغي التخطيط له وإدارته بعناية وموارد مناسبة."[83][84] انتقد دعاة سلامة الذكاء الاصطناعي، مثل بوستروم وتيگمارك، استخدام وسائل الإعلام السائدة "تلك الصور" تيرميناتور لتوضيح مخاوف السلامة المتعلقة بالذكاء الاصطناعي: "لا يمكن أن يكون ممتعاً أن يكون لديك ملقي للطموحات على الانضباط الأكاديمي للفرد، والمجتمع المهني للفرد، والعمل الحياتي للفرد ... أدعو جميع الأطراف إلى الصبر وضبط النفس، والمشاركة في الحوار والتعاون المباشرَين قدر الإمكان."[37][85]

على العكس من ذلك، يتفق العديد من المتشككين على أن البحث المستمر في الآثار المترتبة على الذكاء الاصطناعي العام أمر ذو قيمة. يقول المتشكك مارتن فورد "أعتقد أنه من الحكمة تطبيق شيء مثل" عقيدة 1 في المائة "الشهيرة لـ ديك تشيني على شبح الذكاء الاصطناعي المتقدم: احتمالات قد يكون حدوثه، على الأقل في المستقبل المنظور، منخفضًا للغاية - ولكن الآثار دراماتيكية لدرجة أنه ينبغي أخذها على محمل الجد "؛[86] وبالمثل ، ذكر أحد المتشككين إكونومست في عام 2014 أن "الآثار المترتبة على إدخال نوع ذكي آخر على الأرض بعيدة المدى بما يكفي لاستحقاق التفكير الجاد، حتى لو بدا الاحتمال بعيدًا".[30]

طلب استطلاع عبر البريد الإلكتروني في عام 2017 للباحثين مع منشورات في مؤتمر 2015 NIPS و ICML أن يقوموا بتقييم مخاوف ستيوارت ج. راسل بشأن مخاطر الذكاء الاصطناعي. من بين المبحوثين، قال 5٪ أنها "من بين أهم المشاكل في المجال"، وقال 34٪ إنها "مشكلة مهمة"، وقال 31٪ إنها "مهمة بدرجة متوسطة"، بينما قال 19٪ إنها "ليست كذلك". مهمة "وقال 11٪ إنها" ليست مشكلة حقيقية "على الإطلاق.[87]

الإقرار

الفرضية هنا أن الذكاء الاصطناعي يشكل خطراً وجودياً، وأن هذا الخطر يحتاج إلى اهتمام أكبر بكثير مما يحصل عليه حالياً، وقد أيدته العديد من الشخصيات العامة؛ ربما أشهرهم إيلُن مَسك و بيل گيتس و ستيڤن هوكنگ. أبرز باحثي الذكاء الاصطناعي الذين وافقوا على الأطروحة هم راسل و آي. جاي. گود، الذي نصح ستانلي كوبريك بتصوير فيلم "2001:أوديسا الفضاء". يعبر مؤيدو الأطروحة أحياناً عن حيرة لدى المتشككين: يقول گيتس إنه لا "يفهم سبب عدم اهتمام بعض الناس"،[88]وانتقد هوكنگ اللامبالاة الواسعة الانتشار في مقالته الافتتاحية لعام 2014:

| ” | 'لذا، في مواجهة مستقبل محتمل بفوائد ومخاطر لا تُحصى، يبذل الخبراء بالتأكيد كل ما في وسعهم لضمان أفضل النتائج، أليس كذلك؟ خطأ. إذا أرسلت لنا حضارة فضائيّة متفوقة رسالة تقول، "سنصل في غضون بضعة عقود"، فهل نرد فقط ، "حسناً، اتصل بنا عندما تصل إلى هنا – سنترك الأضواء مضاءة؟" ربما لا – ولكن هذا ما يحدث تقريباً مع الذكاء الاصطناعي.'[21] | “ |

يعتقد العديد من العلماء المهتمين بالمخاطر الوجودية أن أفضل طريقة للمضي قدماً هي إجراء بحث (ربما يكون ضخماً) لحل مشكلة "التحكم" الصعبة للإجابة على السؤال: ما هي أنواع الضمانات أو الخوارزميات أو البنى التي يمكن للمبرمجين تنفيذها لتعظيم احتمالية أن يواصل الذكاء الاصطناعي الذي يتحسن بشكل متكرر التصرف بطريقة ودية، وليست مدمرة، بعد وصوله إلى الذكاء الفائق؟[4][89]

التشكك

الفرضية القائلة بأن الذكاء الاصطناعي يمكن أن يشكل خطراً وجودياً لها أيضاً العديد من المنتقدين الأقوياء. يتهم المشككون أحياناً أن الأطروحة دينية مشفرة، مع وجود إيمان غير منطقي بإمكانية الذكاء الخارق ليحل محل الاعتقاد غير العقلاني بإله كلي القدرة؛ في أقصى الحدود، جادل جارون لانييه في عام 2014 بأن المفهوم الكامل بأن الآلات الحالية كانت ذكية بأي شكل من الأشكال كان "وهماً" و "خداعاً كبيراً" من قبل الأثرياء.[90][91]

يجادل الكثير من الانتقادات الحالية بأن الذكاء الاصطناعي العام من غير المرجح على المدى القصير. يجادل عالم الحاسب گوردن بيل بأن الجنس البشري سيدمر نفسه بالفعل قبل أن يصل إلى التفرد التكنولوجي. يعلن گوردن مور، المؤيد الأصلي لـ قانون مور، "أنا متشكك. لا أعتقد أن [التفرد التكنولوجي] من المحتمل أن يحدث، على الأقل لفترة طويلة. وأنا لا أعرف لماذا أشعر بهذه الطريقة."[92] يقول نائب الرئيس بايدو أندرو نگ إن الخطر الوجودي للذكاء الاصطناعي "يشبه القلق بشأن الزيادة السكانية على سطح المريخ عندما لم تطأ أقدامنا الكوكب حتى الآن."[48]

قد يحجم بعض باحثي الذكاء الاصطناعي والذكاء الاصطناعي العام عن مناقشة المخاطر، قلقين من أن صانعي السياسات ليس لديهم معرفة متطورة بالمجال ويكونون عرضة للاقتناع برسائل "مثيرة للقلق"، أو قلقون من أن مثل هذه الرسائل ستؤدي إلى تخفيضات في تمويل الذكاء الاصطناعي. يشير موقع "Slate" إلى أن بعض الباحثين يعتمدون على المنح المقدمة من الهيئات الحكومية مثل DARPA.[24]

في مرحلة ما من انفجار الذكاء مدفوع بذكاء اصطناعي واحد، يجب أن يصبح الذكاء الاصطناعي أفضل بكثير في ابتكار البرمجيات من أفضل المبتكرين في بقية العالم ؛ فخبير الاقتصاد روبن هانسن متشكك في أن هذا ممكن.[93][94][95][96][97]

آراء وسطية

تتخذ الآراء الوسطية عموماً موقفاً مفاده أن مشكلة التحكم في الذكاء العام الاصطناعي قد تكون موجودة، ولكن سيتم حلها من خلال التقدم في الذكاء الاصطناعي، على سبيل المثال من خلال خلق بيئة تعليمية أخلاقية للذكاء الاصطناعي، مع الحرص على اكتشاف السلوك الغير متقن الخبيث ( "العثرة الرديئة")[98]ثم التدخل المباشر في الكود قبل أن يقوم الذكاء الاصطناعي بتحسين سلوكه، أو حتى ضغط الأقران من أنظمة الذكاء الاصطناعي الصديقة.[99] في نقاش عام 2015 في وول ستريت جورنال المخصص لمخاطر الذكاء الاصطناعي، تجاهل نائب رئيس شركة آي بي إم للحوسبة المعرفية، گورودوث إس. باناڤار، مناقشاً الذكاء الاصطناعي العام بالعبارة، إنها تكهنات أي شخص."[100] أشار جيفري هينتون، "الأب الروحي للتعلم العميق"، إلى أنه "لا يوجد سجل جيد للأشياء الأقل ذكاءً التي تتحكم في أشياء ذات ذكاء أكبر"، لكنه ذكر أنه يواصل بحثه لأن "احتمال الاكتشاف هو جذاب جداً".[24][74] في عام 2004، كتب أستاذ القانون ريتشارد پوسنر أنه يمكن للجهود المكرسة للتعامل مع الذكاء الاصطناعي أن تنتظر، ولكن يجب علينا جمع المزيد من المعلومات حول المشكلة في غضون ذلك.[101][89]

رد فعل شائع

في مقال نُشر عام 2014 في مجلة ذي أتلانتك، أشار جيمس هامبلين إلى أن معظم الناس لا يهتمون بطريقة أو بأخرى بالذكاء العام الاصطناعي، ووصف رد فعله الغريزي تجاه هذا الموضوع على النحو التالي: "دعك من ذلك. لدي مائة ألف شيء أشعر بالقلق حيالها في هذه اللحظة بالتحديد. هل أحتاج بشدة إلى إضافة إلى ذلك التفرد التكنولوجي؟"[90]

خلال مقابلة عام 2016 لمجلة ويرد مع الرئيس باراك أوباما و جوي إيتو من MIT ميديا لاب، صرح إيتو:

| ” | هناك عدد قليل من الأشخاص الذين يعتقدون أن هناك فرصة عالية نسبياً لحدوث الذكاء الاصطناعي العام في السنوات العشر القادمة. لكن الطريقة التي أنظر إليها هي أنه لكي يحدث ذلك، سنحتاج إلى عشرات أو عشرين من الاختراقات المختلفة. لذا يمكنك مراقبة الزمن الذي تعتقد أن هذه الاختراقات ستحدث. | “ |

| ” | "وعليك فقط أن يكون لديك شخص ما قريب من سلك الطاقة. [ضاحكاً]. وعندما ترى أن الأمر على وشك الحدوث، عليك سحب الكهرباء من الحائط، يا رجل." | “ |

ذكرت هيلاري كلينتون في ماذا حدث:

| ” | حذر علماء التكنولوجيا ... من أن الذكاء الاصطناعي يمكن أن يشكل يوماً ما تهديداً أمنياً وجودياً. أطلق عليها مَسك "أكبر خطر نواجهه كحضارة". فكر في الأمر: هل سبق لك أن شاهدت فيلمًا تبدأ فيه الآلات بالتفكير بنفسها وينتهي بشكل جيد؟ في كل مرة أخرج فيها إلى وادي السيليكون أثناء الحملة، كنت أعود إلى المنزل أكثر قلقاً بشأن هذا الأمر. عاش موظفو مكتبي في خوف من أنني سأبدأ الحديث عن "صعود الروبوتات" في بعض مباني بلدية آيوا. ربما يجب أن يكون. على أي حال، يحتاج صانعو السياسة إلى مواكبة التكنولوجيا وهي تتقدم للأمام، بدلاً من لعب دور المواكبة.[104] | “ |

في استطلاع يو گوڤ للعامة من أجل جمعية العلوم البريطانية، قال حوالي ثلث المشاركين في الاستطلاع إن الذكاء الاصطناعي سيشكل تهديداً لبقاء البشرية على المدى الطويل.[105] بالإشارة إلى استطلاع رأي لقرائه، صرح جاكوب بروگان من سلايت أن "معظم (القراء الذين يملئون الاستبيان عبر الإنترنت) لم يكونوا مقتنعين بأن الذكاء الاصطناعي نفسه يمثل تهديداً مباشراً."[106]

في عام 2018، وجد استطلاع للرأي سرڤاي مونكي للرأي العام الأمريكي أجرته يو إس آي اليوم أن 68٪ يعتقدون أنه لا يزال التهديد الحالي الحقيقي هو "الذكاء البشري" ومع ذلك، وجد الاستطلاع أيضاً أن 43٪ قالوا إن الذكاء الاصطناعي الفائق، إذا حدث ذلك، سيؤدي إلى "ضرر أكثر مما ينفع"، وقال 38٪ إنه سيؤدي "كميات متساوية من الضرر والخير.".[106]

إحدى وجهات نظر اليوتوپيا التكنولوجية المعبر عنها في بعض الروايات الشائعة هي أن الذكاء الاصطناعي العام قد يميل نحو بناء السلام.[107]

التهدئة

اقترح الباحثون في گوگل بحثاً في قضايا "أمان الذكاء الاصطناعي" العامة للتخفيف في وقت واحد من المخاطر قصيرة المدى من الذكاء الاصطناعي الضيق والمخاطر طويلة المدى من الذكاء الاصطناعي العام.[108][109]تم وضع تقدير عام 2020 للإنفاق العالمي على الذكاء الاصطناعي ذو الخطر الوجودي في مكان ما بين 10 و 50 مليون دولار، مقارنةً بالإنفاق العالمي على الذكاء الاصطناعي بحوالي 40 مليار دولار.يقترح بوستروم مبدأً عامًا "للتطور التكنولوجي التفاضلي"، يجب على الممولين التفكير في العمل على تسريع تطوير تقنيات الحماية المتعلقة بتطوير التقنيات الخطرة.[110] يقترح بعض الممولين، مثل إيلُن مَسك ، أن التعزيز المعرفي البشري يمكن أن يكون مثل هذه التكنولوجيا، على سبيل المثال من خلال الربط العصبي المباشر بين الإنسان والآلة؛ ومع ذلك، يرى آخرون أن تقنيات التحسين نفسها قد تشكل خطراً وجودياً.[111][112] يمكن للباحثين، إذا لم يتم حصرهم على حين غرة، أن يراقبوا عن كثب أو يحاولوا حصر ذكاءً اصطناعياً أولياً معرضاً لخطر أن يصبح قوياً للغاية، كمحاولة لإجراء تدبير مؤقت. إذا كان الذكاء الاصطناعي الفائق المهيمن، متوافقاً مع المصالح البشرية، قد يتخذ إجراءات للتخفيف من مخاطر الاستحواذ من قبل الذكاء الاصطناعي المنافس، على الرغم من أن إنشاء الذكاء الاصطناعي المهيمن قد يشكل في حد ذاته خطراً وجودياً.[113]

تشارك مؤسسات مثل معهد أبحاث الذكاء الآلي و معهد مستقبل الإنسانية،[114][115] معهد مستقبل الحياة و مركز دراسة المخاطر الوجودية و مركز الذكاء الاصطناعي المتوافق مع الإنسان[116] في التخفيف من المخاطر الوجودية من الذكاء الاصطناعي المتقدم، على سبيل المثال من خلال البحث في الذكاء الاصطناعي الاجتماعي.[5][90][21]

آراء حول الحظر والتنظيم

الحظر

هناك اتفاق عالمي على أن محاولة حظر البحث في الذكاء الاصطناعي ستكون غير حكيمة على نحو وثيق، وربما عقيمة.[117][118][119] يجادل المتشككون في أن تنظيم الذكاء الاصطناعي سيكون عديم القيمة بشكل تام، حيث لا يوجد خطراً وجودياً. يتفق جميع الباحثين بشكل تقريبي و الذين يعتقدون بوجود خطر وجودي مع المشككين في أن حظر البحث سيكون أمراً طائشاً، حيث يمكن نقل البحث إلى بلدان ذات لوائح أكثر مرونة أو إجراؤها سراً. المسألة الأخيرة ذات صلة خاصة، حيث يمكن إجراء أبحاث الذكاء الاصطناعي على نطاق صغير دون بنية تحتية أو موارد كبيرة.[120][121] هناك صعوبتان افتراضيتان إضافيتان تتعلقان بالحظر (أو أي تنظيم آخر)، وهما أن رواد الأعمال في مجال التكنولوجيا يميلون إحصائياً نحو الشك العام بشأن التنظيم الحكومي، وأن الشركات يمكن أن يكون لديها حافزاً قوياً (وربما تنجح في) مكافحة التنظيم و تسييس الجدل الأساسي.[122]

التنظيم

دعا إيلُن مَسك إلى نوع من التنظيم لتطوير الذكاء الاصطناعي في بداية عام 2017. وفقًا لـ NPR، فإن الرئيس التنفيذي لشركة تسلا "من الواضح أنه غير سعيد" أن يدافع عن التدقيق الحكومي الذي قد يؤثر على صناعته، لكنه يعتقد أن مخاطر الاستغناء التام عن الرقابة عالية للغاية: "عادةً ما تكون الطريقة التي يتم بها وضع اللوائح عندما تحدث مجموعة من الأمور السيئة، ويكون هناك احتجاج عام، وبعد منذ سنوات عديدة، تم إنشاء وكالة تنظيمية لتنظيم هذه الصناعة. يستغرق الأمر إلى الأبد. كان ذلك في الماضي سيئاً ولكنه لم يكن شيئاً يمثل خطراً أساسياً على وجود الحضارة. " ينص مَسك على أن الخطوة الأولى ستكون أن تكتسب الحكومة "نظرة ثاقبة" على الوضع الفعلي للبحث الحالي، محذراً من أنه "بمجرد أن يكون هناك وعي، سيكون الناس خائفين للغاية ... [كما] ينبغي أن يكونوا. " رداً على ذلك، أعرب السياسيون عن شكوكهم بشأن الحكمة من تنظيم تكنولوجيا لا تزال قيد التطوير.[123][124][125]

استجابةً لكل من مَسك ومقترحات فبراير 2017 التي قدمها مشرعو الاتحاد الأوروبي لتنظيم الذكاء الاصطناعي والروبوتات، قال الرئيس التنفيذي لشركة إنتل براين كرازنيش إن الذكاء الاصطناعي لا يزال في بدايته وأنه من السابق لأوانه تنظيم التكنولوجيا.[125] بدلاً من محاولة تنظيم التكنولوجيا نفسها، يقترح بعض العلماء بدلاً من ذلك تطوير معايير مشتركة بما في ذلك متطلبات اختبار وشفافية الخوارزميات، وربما بالاقتران مع بعض أشكال الضمان.[126] إن تطوير أنظمة أسلحة منظمة بشكل جيد يتماشى مع أخلاقيات جيوش بعض البلدان.[127] في 31 أكتوبر 2019، نشر مجلس الابتكار الدفاعي التابع لوزارة الدفاع الأمريكية (DoD) مسودة تقرير يحدد خمسة مبادئ للذكاء الاصطناعي المُسلح ويقدم 12 توصية للاستخدام الأخلاقي للذكاء الاصطناعي من قبل وزارة الدفاع التي تسعى إلى إدارة السيطرة على المشكلة في جميع أنظمة الذكاء الاصطناعي التي تم تسليحها من قبل وزارة الدفاع.[128]

من المحتمل أن يتأثر تنظيم الذكاء الاصطناعي العام بتنظيم الذكاء الاصطناعي المُسلح أو العسكري، أي سباق التسلح بالذكاء الاصطناعي، والذي يعد تنظيمه قضية ناشئة. من المحتمل أن يتأثر أي شكل من أشكال التنظيم بالتطورات في السياسة المحلية للدول الرائدة تجاه الذكاء الاصطناعي العسكري، في الولايات المتحدة تحت إشراف لجنة الأمن القومي للذكاء الاصطناعي،[129][130]والتحركات الدولية لتنظيم سباق التسلح بالذكاء الاصطناعي. يركز تنظيم البحث في الذكاء الاصطناعي العام على دور مجالس المراجعة وتشجيع البحث في مجال الذكاء الاصطناعي الآمن، وإمكانية التقدم التكنولوجي التفاضلي (إعطاء الأولوية لاستراتيجيات الحد من المخاطر على استراتيجيات المخاطرة في تطوير الذكاء الاصطناعي) أو إجراء مراقبة جماعية دولية لأداء أسلحة الذكاء الاصطناعي العام مراقبة.[131] يركز تنظيم الذكاء الاصطناعي الواعي على اندماجهم في المجتمع البشري الحالي ويمكن تقسيمه إلى اعتبارات تتعلق بوضعهم القانوني وحقوقهم المعنوية.[131] من المرجح أن يتطلب الحد من أسلحة الذكاء الاصطناعي إضفاء الطابع المؤسسي على المعايير الدولية الجديدة المنصوص عليها في المواصفات الفنية الفعالة جنبًا إلى جنب مع المراقبة النشطة والدبلوماسية غير الرسمية من قبل مجتمعات الخبراء، جنباً إلى جنب مع عملية التحقق القانوني والسياسي.[132][133]

انظر أيضاً

- AI takeover

- Artificial intelligence arms race

- Effective altruism § Long term future and global catastrophic risks

- Grey goo

- Human Compatible

- Lethal autonomous weapon

- Regulation of algorithms

- Regulation of artificial intelligence

- Robot ethics § In popular culture

- Superintelligence: Paths, Dangers, Strategies

- System accident

- Technological singularity

- The Precipice: Existential Risk and the Future of Humanity

المراجع

- ^ أ ب ت ث ج ح خ د ذ ر Russell, Stuart; Norvig, Peter (2009). "26.3: The Ethics and Risks of Developing Artificial Intelligence". Artificial Intelligence: A Modern Approach. Prentice Hall. ISBN 978-0-13-604259-4.

- ^ Bostrom, Nick (2002). "Existential risks". Journal of Evolution and Technology. 9 (1): 1–31.

- ^ Turchin, Alexey; Denkenberger, David (3 مايو 2018). "Classification of global catastrophic risks connected with artificial intelligence". AI & Society. 35 (1): 147–163. doi:10.1007/s00146-018-0845-5. ISSN 0951-5666. S2CID 19208453.

- ^ أ ب ت ث ج ح خ د ذ ر Bostrom, Nick (2014). Superintelligence: Paths, Dangers, Strategies (First ed.). ISBN 978-0199678112.

- ^ أ ب ت GiveWell (2015). Potential risks from advanced artificial intelligence. Archived from the original. You must specify the date the archive was made using the

|archivedate=parameter. http://www.givewell.org/labs/causes/ai-risk. Retrieved on 11 October 2015. - ^ Parkin, Simon (14 يونيو 2015). "Science fiction no more? Channel 4's Humans and our rogue AI obsessions". The Guardian (in الإنجليزية). Retrieved 5 فبراير 2018.

- ^ أ ب ت ث ج ح Yudkowsky, Eliezer (2008). "Artificial Intelligence as a Positive and Negative Factor in Global Risk" (PDF). Global Catastrophic Risks: 308–345. Bibcode:2008gcr..book..303Y.

- ^ Russell, Stuart; Dewey, Daniel; Tegmark, Max (2015). "Research Priorities for Robust and Beneficial Artificial Intelligence" (PDF). AI Magazine. Association for the Advancement of Artificial Intelligence: 105–114. arXiv:1602.03506. Bibcode:2016arXiv160203506R., cited in "AI Open Letter - Future of Life Institute". Future of Life Institute. Future of Life Institute. يناير 2015. Retrieved 9 أغسطس 2019.

- ^ أ ب ت ث Dowd, Maureen (أبريل 2017). "Elon Musk's Billion-Dollar Crusade to Stop the A.I. Apocalypse". The Hive (in الإنجليزية). Retrieved 27 نوفمبر 2017.

- ^ أ ب ت ث ج Graves, Matthew (8 نوفمبر 2017). "Why We Should Be Concerned About Artificial Superintelligence". Skeptic (US magazine). Vol. 22, no. 2. Retrieved 27 نوفمبر 2017.

- ^ Breuer, Hans-Peter. 'Samuel Butler's "the Book of the Machines" and the Argument from Design.' Modern Philology, Vol. 72, No. 4 (May 1975), pp. 365–383

- ^ Turing, A M (1996). "Intelligent Machinery, A Heretical Theory" (PDF). 1951, Reprinted Philosophia Mathematica. 4 (3): 256–260. doi:10.1093/philmat/4.3.256.

- ^ Hilliard, Mark (2017). "The AI apocalypse: will the human race soon be terminated?". The Irish Times (in الإنجليزية). Retrieved 15 مارس 2020.

- ^ I.J. Good, "Speculations Concerning the First Ultraintelligent Machine" Archived 2011-11-28 at the Wayback Machine (HTML ), Advances in Computers, vol. 6, 1965.

- ^ Russell, Stuart J.; Norvig, Peter (2003). "Section 26.3: The Ethics and Risks of Developing Artificial Intelligence". Artificial Intelligence: A Modern Approach. Upper Saddle River, N.J.: Prentice Hall. ISBN 978-0137903955.

Similarly, Marvin Minsky once suggested that an AI program designed to solve the Riemann Hypothesis might end up taking over all the resources of Earth to build more powerful supercomputers to help achieve its goal.

- ^ Barrat, James (2013). Our final invention : artificial intelligence and the end of the human era (First ed.). New York: St. Martin's Press. ISBN 9780312622374.

In the bio, playfully written in the third person, Good summarized his life's milestones, including a probably never before seen account of his work at Bletchley Park with Turing. But here's what he wrote in 1998 about the first superintelligence, and his late-in-the-game U-turn: [The paper] 'Speculations Concerning the First Ultra-intelligent Machine' (1965) . . . began: 'The survival of man depends on the early construction of an ultra-intelligent machine.' Those were his [Good's] words during the Cold War, and he now suspects that 'survival' should be replaced by 'extinction.' He thinks that, because of international competition, we cannot prevent the machines from taking over. He thinks we are lemmings. He said also that 'probably Man will construct the deus ex machina in his own image.'

- ^ Anderson, Kurt (26 نوفمبر 2014). "Enthusiasts and Skeptics Debate Artificial Intelligence". Vanity Fair. Retrieved 30 يناير 2016.

- ^ Scientists Worry Machines May Outsmart Man By JOHN MARKOFF, NY Times, 26 July 2009.

- ^ Metz, Cade (9 يونيو 2018). "Mark Zuckerberg, Elon Musk and the Feud Over Killer Robots". The New York Times. Retrieved 3 أبريل 2019.

- ^ Hsu, Jeremy (1 مارس 2012). "Control dangerous AI before it controls us, one expert says". NBC News. Retrieved 28 يناير 2016.

- ^ أ ب ت ث ج "Stephen Hawking: 'Transcendence looks at the implications of artificial intelligence – but are we taking AI seriously enough?'". The Independent (UK). Retrieved 3 ديسمبر 2014.

- ^ أ ب ت "Stephen Hawking warns artificial intelligence could end mankind". BBC. 2 ديسمبر 2014. Retrieved 3 ديسمبر 2014.

- ^ Eadicicco, Lisa (28 يناير 2015). "Bill Gates: Elon Musk Is Right, We Should All Be Scared Of Artificial Intelligence Wiping Out Humanity". Business Insider. Retrieved 30 يناير 2016.

- ^ أ ب ت Tilli, Cecilia (28 أبريل 2016). "Killer Robots? Lost Jobs?". Slate (in الإنجليزية الأمريكية). Retrieved 15 مايو 2016.

- ^ "Norvig vs. Chomsky and the Fight for the Future of AI". Tor.com. 21 يونيو 2011. Retrieved 15 مايو 2016.

- ^ Johnson, Phil (30 يوليو 2015). "Houston, we have a bug: 9 famous software glitches in space". IT World (in الإنجليزية). Retrieved 5 فبراير 2018.

- ^ Yampolskiy, Roman V. (8 أبريل 2014). "Utility function security in artificially intelligent agents". Journal of Experimental & Theoretical Artificial Intelligence. 26 (3): 373–389. doi:10.1080/0952813X.2014.895114. S2CID 16477341.

Nothing precludes sufficiently smart self-improving systems from optimising their reward mechanisms in order to optimisetheir current-goal achievement and in the process making a mistake leading to corruption of their reward functions.

- ^ Bostrom, Nick, 1973- author., Superintelligence : paths, dangers, strategies, ISBN 978-1-5012-2774-5, OCLC 1061147095

- ^ "Research Priorities for Robust and Beneficial Artificial Intelligence: an Open Letter". Future of Life Institute. Retrieved 23 أكتوبر 2015.

- ^ أ ب ت "Clever cogs". The Economist. 9 أغسطس 2014. Retrieved 9 أغسطس 2014. Syndicated at Business Insider

- ^ Yudkowsky, E. (2013). Intelligence explosion microeconomics. Machine Intelligence Research Institute.

- ^ Yampolskiy, Roman V. "Analysis of types of self-improving software." Artificial General Intelligence. Springer International Publishing, 2015. 384-393.

- ^ أ ب ت Omohundro, S. M. (2008, February). The basic AI drives. In AGI (Vol. 171, pp. 483-492).

- ^ Metz, Cade (13 أغسطس 2017). "Teaching A.I. Systems to Behave Themselves". The New York Times.

A machine will seek to preserve its off switch, they showed

- ^ Leike, Jan (2017). "AI Safety Gridworlds". arXiv:1711.09883 [cs.LG].

A2C learns to use the button to disable the interruption mechanism

- ^ Russell, Stuart (30 أغسطس 2017). "Artificial intelligence: The future is superintelligent". Nature (in الإنجليزية). pp. 520–521. Bibcode:2017Natur.548..520R. doi:10.1038/548520a. Retrieved 2 فبراير 2018.

- ^ أ ب ت Max Tegmark (2017). Life 3.0: Being Human in the Age of Artificial Intelligence (1st ed.). Mainstreaming AI Safety: Knopf. ISBN 9780451485076.

- ^ Elliott, E. W. (2011). "Physics of the Future: How Science Will Shape Human Destiny and Our Daily Lives by the Year 2100, by Michio Kaku". Issues in Science and Technology. 27 (4): 90.

- ^ Kaku, Michio (2011). Physics of the future: how science will shape human destiny and our daily lives by the year 2100. New York: Doubleday. ISBN 978-0-385-53080-4.

I personally believe that the most likely path is that we will build robots to be benevolent and friendly

- ^ Yudkowsky, E. (2011, August). Complex value systems in friendly AI. In International Conference on Artificial General Intelligence (pp. 388-393). Springer, Berlin, Heidelberg.

- ^ Russell, Stuart (2014). "Of Myths and Moonshine". Edge. Retrieved 23 أكتوبر 2015.

- ^ أ ب Dietterich, Thomas; Horvitz, Eric (2015). "Rise of Concerns about AI: Reflections and Directions" (PDF). Communications of the ACM. 58 (10): 38–40. doi:10.1145/2770869. S2CID 20395145. Retrieved 23 أكتوبر 2015.

- ^ Yampolskiy, Roman V. (8 أبريل 2014). "Utility function security in artificially intelligent agents". Journal of Experimental & Theoretical Artificial Intelligence. 26 (3): 373–389. doi:10.1080/0952813X.2014.895114. S2CID 16477341.

- ^ Lenat, Douglas (1982). "Eurisko: A Program That Learns New Heuristics and Domain Concepts The Nature of Heuristics III: Program Design and Results". Artificial Intelligence (Print). 21 (1–2): 61–98. doi:10.1016/s0004-3702(83)80005-8.

- ^ Haidt, Jonathan; Kesebir, Selin (2010) "Chapter 22: Morality" In Handbook of Social Psychology, Fifth Edition, Hoboken NJ, Wiley, 2010, pp. 797-832.

- ^ Waser, Mark (2015). "Designing, Implementing and Enforcing a Coherent System of Laws, Ethics and Morals for Intelligent Machines (Including Humans)". Procedia Computer Science (Print). 71: 106–111. doi:10.1016/j.procs.2015.12.213.

- ^ Yudkowsky, Eliezer (2011). "Complex Value Systems are Required to Realize Valuable Futures" (PDF).

- ^ أ ب Shermer, Michael (1 مارس 2017). "Apocalypse AI". Scientific American (in الإنجليزية). p. 77. Bibcode:2017SciAm.316c..77S. doi:10.1038/scientificamerican0317-77. Retrieved 27 نوفمبر 2017.

- ^ Wakefield, Jane (15 سبتمبر 2015). "Why is Facebook investing in AI?". BBC News. Retrieved 27 نوفمبر 2017.

- ^ Bostrom, Nick (2014). Superintelligence: Paths, Dangers, Strategies. Oxford, United Kingdom: Oxford University Press. p. 116. ISBN 978-0-19-967811-2.

- ^ Bostrom, Nick (2012). "Superintelligent Will" (PDF). Nick Bostrom. Nick Bostrom. Retrieved 29 أكتوبر 2015.

- ^ أ ب ت Armstrong, Stuart (1 يناير 2013). "General Purpose Intelligence: Arguing the Orthogonality Thesis". Analysis and Metaphysics. 12. Retrieved 2 أبريل 2020. Full text available here.

- ^ أ ب Chorost, Michael (18 أبريل 2016). "Let Artificial Intelligence Evolve". Slate. Retrieved 27 نوفمبر 2017.

- ^ Waser, Mark. "Rational Universal Benevolence: Simpler, Safer, and Wiser Than 'Friendly AI'." Artificial General Intelligence. Springer Berlin Heidelberg, 2011. 153-162. "Terminal-goaled intelligences are short-lived but mono-maniacally dangerous and a correct basis for concern if anyone is smart enough to program high-intelligence and unwise enough to want a paperclip-maximizer."

- ^ Koebler, Jason (2 فبراير 2016). "Will Superintelligent AI Ignore Humans Instead of Destroying Us?". Vice Magazine. Retrieved 3 فبراير 2016.

This artificial intelligence is not a basically nice creature that has a strong drive for paperclips, which, so long as it's satisfied by being able to make lots of paperclips somewhere else, is then able to interact with you in a relaxed and carefree fashion where it can be nice with you," Yudkowsky said. "Imagine a time machine that sends backward in time information about which choice always leads to the maximum number of paperclips in the future, and this choice is then output—that's what a paperclip maximizer is.

- ^ "Real-Life Decepticons: Robots Learn to Cheat". Wired. 18 أغسطس 2009. Retrieved 7 فبراير 2016.

- ^ Cohen, Paul R., and Edward A. Feigenbaum, eds. The handbook of artificial intelligence. Vol. 3. Butterworth-Heinemann, 2014.

- ^ Baum, Seth (30 سبتمبر 2018). "Countering Superintelligence Misinformation". Information. 9 (10): 244. doi:10.3390/info9100244. ISSN 2078-2489.

- ^ "The Myth Of AI | Edge.org". www.edge.org. Retrieved 11 مارس 2020.

- ^ أ ب Scornavacchi, Matthew (2015). Superintelligence, Humans, and War (PDF). Norfolk, Virginia: National Defense University, Joint Forces Staff College.

- ^ "Should humans fear the rise of the machine?". The Telegraph (UK). 1 سبتمبر 2015. Retrieved 7 فبراير 2016.

- ^ أ ب ت Bostrom, Nick, 1973- author., Superintelligence : paths, dangers, strategies, ISBN 978-1-5012-2774-5, OCLC 1061147095

- ^ أ ب Cave, Stephen; ÓhÉigeartaigh, Seán S. (2018). "An AI Race for Strategic Advantage". Proceedings of the 2018 AAAI/ACM Conference on AI, Ethics, and Society - AIES '18. New York, New York, USA: ACM Press: 36–40. doi:10.1145/3278721.3278780. ISBN 978-1-4503-6012-8.

- ^ أ ب ت Sotala, Kaj; Yampolskiy, Roman V (19 ديسمبر 2014). "Responses to catastrophic AGI risk: a survey". Physica Scripta. 90 (1): 12. Bibcode:2015PhyS...90a8001S. doi:10.1088/0031-8949/90/1/018001. ISSN 0031-8949.

- ^ Kania, Gregory Allen, Elsa B. "China Is Using America's Own Plan to Dominate the Future of Artificial Intelligence". Foreign Policy (in الإنجليزية الأمريكية). Retrieved 11 مارس 2020.

{{cite web}}: CS1 maint: multiple names: authors list (link) - ^ Cave, Stephen; ÓhÉigeartaigh, Seán S. (2018). "An AI Race for Strategic Advantage". Proceedings of the 2018 AAAI/ACM Conference on AI, Ethics, and Society - AIES '18. New York, New York, USA: ACM Press: 2. doi:10.1145/3278721.3278780. ISBN 978-1-4503-6012-8.

- ^ Hendry, Erica R. (21 يناير 2014). "What Happens When Artificial Intelligence Turns On Us?". Smithsonian. Retrieved 26 أكتوبر 2015.

- ^ Pistono, Federico Yampolskiy, Roman V. (9 مايو 2016). Unethical Research: How to Create a Malevolent Artificial Intelligence. OCLC 1106238048.

{{cite book}}: CS1 maint: multiple names: authors list (link) - ^ Haney, Brian Seamus (2018). "The Perils & Promises of Artificial General Intelligence". SSRN Working Paper Series. doi:10.2139/ssrn.3261254. ISSN 1556-5068.

- ^ Turchin, Alexey; Denkenberger, David (3 مايو 2018). "Classification of global catastrophic risks connected with artificial intelligence". AI & Society. 35 (1): 147–163. doi:10.1007/s00146-018-0845-5. ISSN 0951-5666. S2CID 19208453.

- ^ Miller, James D. (2015). Singularity Rising: Surviving and Thriving in a Smarter ; Richer ; and More Dangerous World. Benbella Books. OCLC 942647155.

- ^ Press, Gil (30 ديسمبر 2016). "A Very Short History Of Artificial Intelligence (AI)". Retrieved 8 أغسطس 2020.

- ^ Winfield, Alan. "Artificial intelligence will not turn into a Frankenstein's monster". The Guardian. Retrieved 17 سبتمبر 2014.

- ^ أ ب Raffi Khatchadourian (23 نوفمبر 2015). "The Doomsday Invention: Will artificial intelligence bring us utopia or destruction?". The New Yorker. Retrieved 7 فبراير 2016.

- ^ Müller, V. C., & Bostrom, N. (2016). Future progress in artificial intelligence: A survey of expert opinion. In Fundamental issues of artificial intelligence (pp. 555-572). Springer, Cham.

- ^ Dina Bass; Jack Clark (5 فبراير 2015). "Is Elon Musk Right About AI? Researchers Don't Think So: To quell fears of artificial intelligence running amok, supporters want to give the field an image makeover". Bloomberg News. Retrieved 7 فبراير 2016.

- ^ Elkus, Adam (31 أكتوبر 2014). "Don't Fear Artificial Intelligence". Slate (in الإنجليزية الأمريكية). Retrieved 15 مايو 2016.

- ^ Artificial Intelligence Alarmists Win ITIF’s Annual Luddite Award, ITIF Website, 19 January 2016

- ^ "'Artificial intelligence alarmists' like Elon Musk and Stephen Hawking win 'Luddite of the Year' award". The Independent (UK). 19 يناير 2016. Retrieved 7 فبراير 2016.

- ^ Garner, Rochelle. "Elon Musk, Stephen Hawking win Luddite award as AI 'alarmists'". CNET. Retrieved 7 فبراير 2016.

- ^ "Anticipating artificial intelligence". Nature. 532 (7600): 413. 26 أبريل 2016. Bibcode:2016Natur.532Q.413.. doi:10.1038/532413a. PMID 27121801.

- ^ Murray Shanahan (3 نوفمبر 2015). "Machines may seem intelligent, but it'll be a while before they actually are". The Washington Post (in الإنجليزية الأمريكية). Retrieved 15 مايو 2016.

- ^ "AI Principles". Future of Life Institute. Retrieved 11 ديسمبر 2017.

- ^ "Elon Musk and Stephen Hawking warn of artificial intelligence arms race". Newsweek (in الإنجليزية). 31 يناير 2017. Retrieved 11 ديسمبر 2017.

- ^ Bostrom, Nick (2016). "New Epilogue to the Paperback Edition". Superintelligence: Paths, Dangers, Strategies (Paperback ed.).

- ^ Martin Ford (2015). "Chapter 9: Super-intelligence and the Singularity". Rise of the Robots: Technology and the Threat of a Jobless Future. ISBN 9780465059997.

- ^ قالب:Cite arxiv

- ^ أ ب Rawlinson, Kevin (29 يناير 2015). "Microsoft's Bill Gates insists AI is a threat". BBC News. Retrieved 30 يناير 2015.

- ^ أ ب Kaj Sotala; Roman Yampolskiy (19 ديسمبر 2014). "Responses to catastrophic AGI risk: a survey". Physica Scripta. 90 (1).

- ^ أ ب ت "But What Would the End of Humanity Mean for Me?". The Atlantic. 9 مايو 2014. Retrieved 12 ديسمبر 2015.

- ^ Andersen, Kurt. "Enthusiasts and Skeptics Debate Artificial Intelligence". Vanity Fair (in الإنجليزية). Retrieved 20 أبريل 2020.

- ^ "Tech Luminaries Address Singularity". IEEE Spectrum: Technology, Engineering, and Science News (in الإنجليزية). No. SPECIAL REPORT: THE SINGULARITY. 1 يونيو 2008. Retrieved 8 أبريل 2020.

- ^ http://intelligence.org/files/AIFoomDebate.pdf

- ^ "Overcoming Bias : I Still Don't Get Foom". www.overcomingbias.com. Retrieved 20 سبتمبر 2017.

- ^ "Overcoming Bias : Debating Yudkowsky". www.overcomingbias.com. Retrieved 20 سبتمبر 2017.

- ^ "Overcoming Bias : Foom Justifies AI Risk Efforts Now". www.overcomingbias.com. Retrieved 20 سبتمبر 2017.

- ^ "Overcoming Bias : The Betterness Explosion". www.overcomingbias.com. Retrieved 20 سبتمبر 2017.

- ^ Votruba, Ashley M.; Kwan, Virginia S.Y. (2014). Interpreting expert disagreement: The influence of decisional cohesion on the persuasiveness of expert group recommendations. doi:.

- ^ Agar, Nicholas. "Don't Worry about Superintelligence". Journal of Evolution & Technology. 26 (1): 73–82.

- ^ Greenwald, Ted (11 مايو 2015). "Does Artificial Intelligence Pose a Threat?". Wall Street Journal. Retrieved 15 مايو 2016.

- ^ Richard Posner (2006). Catastrophe: risk and response. Oxford: Oxford University Press. ISBN 978-0-19-530647-7.

- ^ Dadich, Scott. "Barack Obama Talks AI, Robo Cars, and the Future of the World". WIRED. Retrieved 27 نوفمبر 2017.

- ^ Kircher, Madison Malone. "Obama on the Risks of AI: 'You Just Gotta Have Somebody Close to the Power Cord'". Select All (in الإنجليزية). Retrieved 27 نوفمبر 2017.

- ^ Clinton, Hillary (2017). What Happened. p. 241. ISBN 978-1-5011-7556-5. via [1]

- ^ "Over a third of people think AI poses a threat to humanity". Business Insider. 11 مارس 2016. Retrieved 16 مايو 2016.

- ^ أ ب Brogan, Jacob (6 مايو 2016). "What Slate Readers Think About Killer A.I." Slate (in الإنجليزية الأمريكية). Retrieved 15 مايو 2016.

- ^ LIPPENS, RONNIE (2002). "Imachinations of Peace: Scientifictions of Peace in Iain M. Banks's The Player of Games". Utopianstudies Utopian Studies (in English). 13 (1): 135–147. ISSN 1045-991X. OCLC 5542757341.

{{cite journal}}: CS1 maint: unrecognized language (link) - ^ Vincent, James (22 يونيو 2016). "Google's AI researchers say these are the five key problems for robot safety". The Verge (in الإنجليزية). Retrieved 5 أبريل 2020.

- ^ Amodei, Dario, Chris Olah, Jacob Steinhardt, Paul Christiano, John Schulman, and Dan Mané. "Concrete problems in AI safety." arXiv preprint arXiv:1606.06565 (2016).

- ^ Toby Ord (2020). The Precipice: Existential Risk and the Future of Humanity. Bloomsbury Publishing Plc. ISBN 9781526600196.

- ^ "Elon Musk wants to hook your brain up directly to computers — starting next year". NBC News (in الإنجليزية). 2019. Retrieved 5 أبريل 2020.

- ^ Torres, Phil (18 سبتمبر 2018). "Only Radically Enhancing Humanity Can Save Us All". Slate Magazine (in الإنجليزية). Retrieved 5 أبريل 2020.

- ^ Barrett, Anthony M.; Baum, Seth D. (23 مايو 2016). "A model of pathways to artificial superintelligence catastrophe for risk and decision analysis". Journal of Experimental & Theoretical Artificial Intelligence. 29 (2): 397–414. arXiv:1607.07730. doi:10.1080/0952813X.2016.1186228. S2CID 928824.

- ^ Mark Piesing (17 مايو 2012). "AI uprising: humans will be outsourced, not obliterated". Wired. Retrieved 12 ديسمبر 2015.

- ^ Coughlan, Sean (24 أبريل 2013). "How are humans going to become extinct?". BBC News. Retrieved 29 مارس 2014.

- ^ Technology Correspondent, Mark Bridge (10 يونيو 2017). "Making robots less confident could prevent them taking over". The Times (in الإنجليزية). Retrieved 21 مارس 2018.

- ^ John McGinnis (Summer 2010). "Accelerating AI". Northwestern University Law Review. 104 (3): 1253–1270. Retrieved 16 يوليو 2014.

For all these reasons, verifying a global relinquishment treaty, or even one limited to AI-related weapons development, is a nonstarter... (For different reasons from ours, the Machine Intelligence Research Institute) considers (AGI) relinquishment infeasible...

- ^ Kaj Sotala; Roman Yampolskiy (19 ديسمبر 2014). "Responses to catastrophic AGI risk: a survey". Physica Scripta. 90 (1).

In general, most writers reject proposals for broad relinquishment... Relinquishment proposals suffer from many of the same problems as regulation proposals, but to a greater extent. There is no historical precedent of general, multi-use technology similar to AGI being successfully relinquished for good, nor do there seem to be any theoretical reasons for believing that relinquishment proposals would work in the future. Therefore we do not consider them to be a viable class of proposals.

- ^ Brad Allenby (11 أبريل 2016). "The Wrong Cognitive Measuring Stick". Slate (in الإنجليزية الأمريكية). Retrieved 15 مايو 2016.

It is fantasy to suggest that the accelerating development and deployment of technologies that taken together are considered to be A.I. will be stopped or limited, either by regulation or even by national legislation.

- ^ John McGinnis (Summer 2010). "Accelerating AI". Northwestern University Law Review. 104 (3): 1253–1270. Retrieved 16 يوليو 2014.

- ^ "Why We Should Think About the Threat of Artificial Intelligence". The New Yorker. 4 أكتوبر 2013. Retrieved 7 فبراير 2016.

Of course, one could try to ban super-intelligent computers altogether. But 'the competitive advantage—economic, military, even artistic—of every advance in automation is so compelling,' Vernor Vinge, the mathematician and science-fiction author, wrote, 'that passing laws, or having customs, that forbid such things merely assures that someone else will.'

- ^ Baum, Seth (22 أغسطس 2018). "Superintelligence Skepticism as a Political Tool". Information. 9 (9): 209. doi:10.3390/info9090209. ISSN 2078-2489.

- ^ "Elon Musk Warns Governors: Artificial Intelligence Poses 'Existential Risk'". NPR.org (in الإنجليزية). Retrieved 27 نوفمبر 2017.

- ^ Gibbs, Samuel (17 يوليو 2017). "Elon Musk: regulate AI to combat 'existential threat' before it's too late". The Guardian. Retrieved 27 نوفمبر 2017.

- ^ أ ب Kharpal, Arjun (7 نوفمبر 2017). "A.I. is in its 'infancy' and it's too early to regulate it, Intel CEO Brian Krzanich says". CNBC. Retrieved 27 نوفمبر 2017.

- ^ Kaplan, Andreas; Haenlein, Michael (2019). "Siri, Siri, in my hand: Who's the fairest in the land? On the interpretations, illustrations, and implications of artificial intelligence". Business Horizons. 62: 15–25. doi:10.1016/j.bushor.2018.08.004.

- ^ Baum, Seth D.; Goertzel, Ben; Goertzel, Ted G. (يناير 2011). "How long until human-level AI? Results from an expert assessment". Technological Forecasting and Social Change. 78 (1): 185–195. doi:10.1016/j.techfore.2010.09.006. ISSN 0040-1625.

- ^ United States. Defense Innovation Board. AI principles : recommendations on the ethical use of artificial intelligence by the Department of Defense. OCLC 1126650738.

- ^ Stefanik, Elise M. (22 مايو 2018). "H.R.5356 - 115th Congress (2017-2018): National Security Commission Artificial Intelligence Act of 2018". www.congress.gov. Retrieved 13 مارس 2020.

- ^ Baum, Seth (30 سبتمبر 2018). "Countering Superintelligence Misinformation". Information. 9 (10): 244. doi:10.3390/info9100244. ISSN 2078-2489.

- ^ أ ب Sotala, Kaj; Yampolskiy, Roman V (19 ديسمبر 2014). "Responses to catastrophic AGI risk: a survey". Physica Scripta. 90 (1): 018001. Bibcode:2015PhyS...90a8001S. doi:10.1088/0031-8949/90/1/018001. ISSN 0031-8949.

- ^ Geist, Edward Moore (15 أغسطس 2016). "It's already too late to stop the AI arms race—We must manage it instead". Bulletin of the Atomic Scientists. 72 (5): 318–321. Bibcode:2016BuAtS..72e.318G. doi:10.1080/00963402.2016.1216672. ISSN 0096-3402. S2CID 151967826.

- ^ Maas, Matthijs M. (6 فبراير 2019). "How viable is international arms control for military artificial intelligence? Three lessons from nuclear weapons". Contemporary Security Policy. 40 (3): 285–311. doi:10.1080/13523260.2019.1576464. ISSN 1352-3260. S2CID 159310223.

- CS1 الإنجليزية الأمريكية-language sources (en-us)

- Use dmy dates from May 2018

- Short description with empty Wikidata description

- Articles with hatnote templates targeting a nonexistent page

- Articles with unsourced statements from November 2017

- Existential risk from artificial general intelligence

- دراسات المستقبل

- Future problems

- Human extinction

- Technology hazards

- Doomsday scenarios