تعلم عميق

| جزء من سلسلة عن |

| التعلم الآلي والتنقيب في البيانات |

|---|

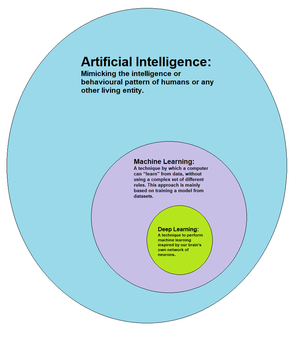

التعلم المنظم العميق Deep Learning أو التعلم الهرمي) هو جزء من عائلة أوسع من التعلم الآلي و هو يعتمد على الشبكات العصبية الاصطناعية. يمكن أن يكون التعلم إما تحت الإشراف، نصف الإشراف أو غير الخاضع للإشراف.[1][2][3]

تم تطبيق أسلوب البنائي في التعلم العميق مثل الشبكات العصبية العميقة وشبكة المعتقدات العميقة و الشبكات العصبية المتكررة و الشبكات العصبية التلافيفية على الحقول بما في ذلك الرؤية الحاسوبية، التعرف على الكلام، معالجة اللغة الطبيعية، التعرف على الصوت، تصفية الشبكة الاجتماعية، الترجمة الآلية، المعلوماتية الحيوية، تصميم الأدوية، برامج تحليل الصور الطبية وفحص المواد وبرامج الألعاب اللوحية، حيث حققوا نتائج مماثلة للخبراء البشر وفي بعض الحالات متفوقة عليها.[4][5][6]

تم استنباط فكرة الشبكات العصبية الاصطناعية (ANNs) من معالجة المعلومات وعقد الاتصالات الموزعة في النظم البيولوجية. تختلف ANNs عن الاختلافات البيولوجية عن الدماغ. وعلى وجه التحديد، تميل الشبكات العصبية إلى أن تكون ثابتة ورمزية، في حين أن الدماغ البيولوجي لمعظم الكائنات الحية يكون ديناميكي (لدن) وتناظري . [7][8][9]

تعريف

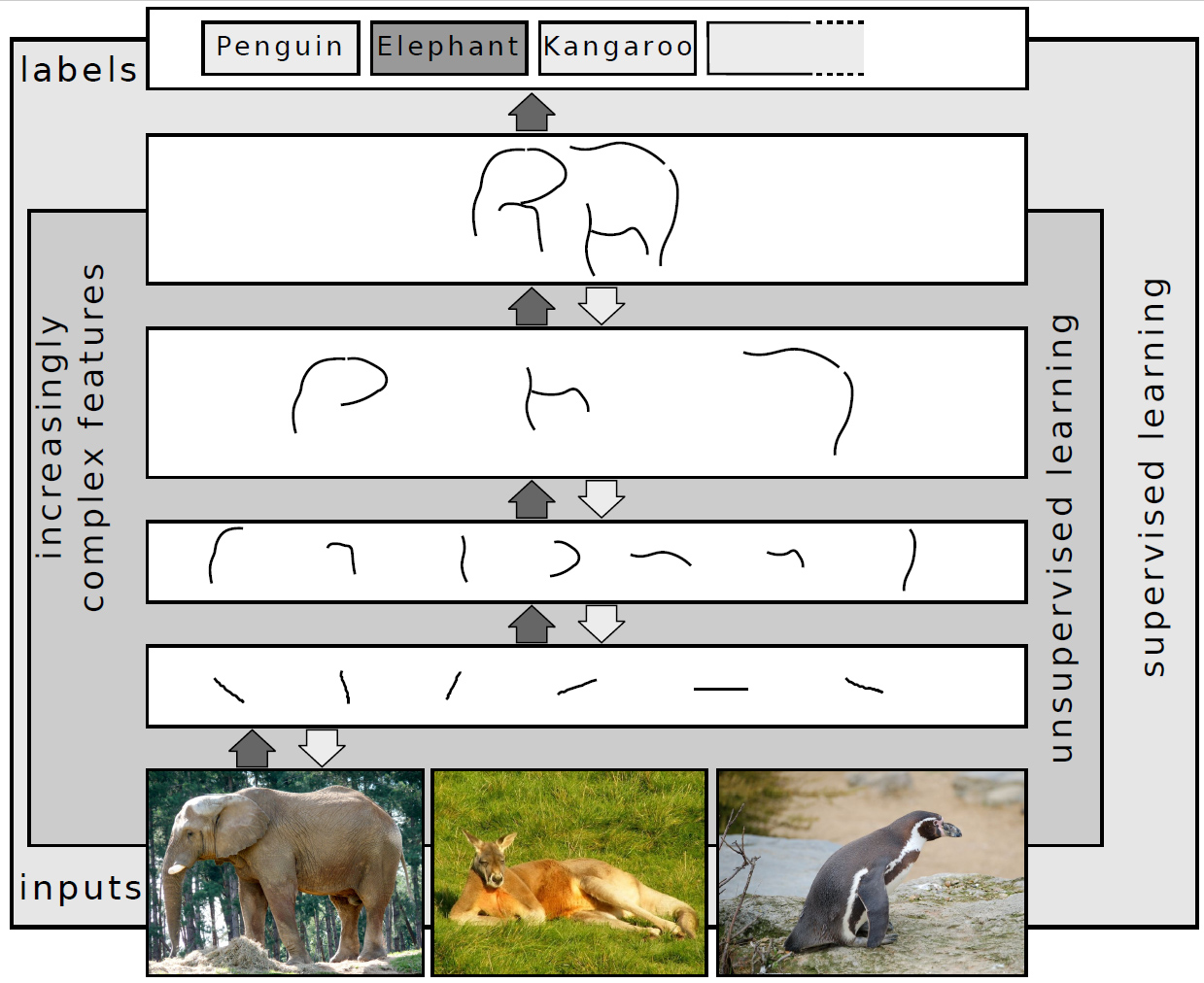

التعلم العميق هو فئة من التعلم الآلي كخوارزمية التي [11] حيث يتم تستخدام طبقات متعددة لاستخراج ميزات المستوى الأعلى تدريجياً من الإدخال الخام. على سبيل المثال ، في معالجة الصور ، قد تحدد الطبقات السفلية الحواف، بينما قد تحدد الطبقات الأعلى المفاهيم ذات الصلة بالإنسان مثل الأرقام أو الحروف أو الوجوه.

نظرة عامة

تعتمد معظم نماذج التعلم العميق الحديثة على الشبكات العصبية الاصطناعية، على وجه التحديد، الشبكة العصبية التلافيفية (CNN)، على الرغم من أنها يمكن أن تشمل أيضًا صيغة مقترحة أو متغيرات كامنة مرتبة بطبقة عميقة في النموذج العام مثل العقد في شبكة المعتقدات العميقة والعمق آلة بولتزمانBoltzmann machine .[12]

في التعلم العميق ،يقوم كل مستوى بتعلم تحويل بيانات المدخلات الخاصة به إلى تمثيل أكثر تجريدية و تركيباً . في تطبيق التعرف على الصور ، قد يكون الإدخال الأولي مصفوفات من البكسل ؛ فالطبقة التمثيلية الأولى قد تستخلص البيكسلات وتشفير الحواف ؛ الطبقة الثانية قد تؤلف وترمز ترتيبات الحواف ؛ الطبقة الثالثة قد تشفر الأنف والعينين ؛ وقد تتعرف الطبقة الرابعة على أن الصورة تحتوي على وجه. الأهم من ذلك ، عملية التعلم العميق يمكن أن تتعلم أي الميزات لوضعها على النحو الأمثل في أي مستوى "من تلقاء نفسها". (بالطبع ، هذا لا يلغي الحاجة إلى ضبط اليد تمامًا ؛ على سبيل المثال، يمكن أن توفر الأعداد المختلفة للطبقات وأحجام الطبقات درجات مختلفة من التجريد.)[1][13]

تشير كلمة "عميق" في "التعلم العميق" إلى عدد الطبقات التي يتم من خلالها تحويل البيانات. بتعبير أدق ، تتمتع أنظمة التعلم العميق بعمق كبير في "مسار تخصيص الائتمان" (CAP). CAP هو سلسلة من التحولات من الإدخال إلى الإخراج. تصف CAPs الاتصالات المحتملة المحتملة بين المدخلات والمخرجات. بالنسبة إلى الشبكة العصبية ذات التغذية الأمامية، فإن عمق CAPs هو عمق الشبكة وهو عبارة عن عدد الطبقات المخفية بالإضافة إلى طبقة واحدة (لأن طبقة المخرجات يتم تحديدها أيضًا). بالنسبة إلى الشبكة العصبية المتكررة و الدورية، التي قد تنتشر فيها إشارة عبر طبقة أكثر من مرة، و يحتمل أن يكون عمق CAP غير محدود.[2] لا توجد حدود متفق عليها عالميا لتقسيم عمق التعلم السطحي من التعلم العميق، لكن معظم الباحثين يتفقون على أن التعلم العميق يشمل عمق CAP أعلى من 2. وقد تبين أن CAP للعمق 2 هو تقريب عالمي، بمعنى أنه يمكن محاكاة أي وظيفة.[citation needed] علاوة على ذلك، لا يتم إضافة المزيد من الطبقات إلى وظيفة تقريب الإمكانية و القدرة للشبكة. النماذج العميقة (CAP> 2) قادرة على استخراج ميزات أفضل من النماذج السطحية، وبالتالي، تساعد الطبقات الإضافية في تعلم الميزات بفعالية.

يمكن تشكيل بنية التعلم العميق باستخدام الخوارزمية النهمة طبقة تلو طبقة.[14]حيث يساعد التعلم العميق على فصل هذه التجريدات واختيار الميزات التي تحسن الأداء. [1].[1]

بالنسبة لمهام التعلم الخاضع للإشراف، تستبعد أساليب التعلم العميق هندسة الميزات، من خلال ترجمة البيانات إلى تمثيلات وسيطة مدمجة أقرب إلى تحليل المكونات الرئيسية، واستنباط البنى ذات الطبقات التي تزيل التكرار في التمثيل .

يمكن تطبيق خوارزميات التعلم العميق على مهام التعلم غير الخاضعة للإشراف. هذه فائدة مهمة لأن البيانات غير المسماة أكثر وفرة من البيانات المصنفة. من الأمثلة على الهياكل العميقة التي يمكن تدريبها بطريقة غير خاضعة للإشراف هي السجلات العصبية و ضواغطها [15] و شبكات المعتقدات العميقة.[1][16]

تفسيرات

يتم تفسير و ترجمة الشبكات العصبية العميقة عمومًا لنظرية التقريب الشامل [17][18][19][20][21][22] أو الاستدلال البايزي.[11][12][1][2][16][23][24]

تتعلق نظرية التقريب العالمية الكلاسيكية بقدرة و إمكانية الشبكات العصبونية المغذاة أمامياً مع طبقة مخفية واحدة من الحجم المحدود لتقريب التوابع المستمرة .[17][18][19][20][21] في عام 1989 ، تم نشر الدليل و البرهان الأول بواسطة جورج سايبنكو لوظائف التنشيط و التفعيل ل دالة السيني[18] وتم تعميمها لتغذية البنى متعددة الطبقات في عام 1991 بواسطة كيرت هورنيك.[19] أظهر العمل الأخير أيضًا أن التقريب العالمي ينطبق أيضًا على وظائف التنشيط غير المحددة مثل الوحدة الخطية المصححة. [25] تتعلق النظرية العامة للتقريب لـ الشبكات العصبية العميقة بقدرة الشبكات ذات العرض المقيد ولكن يسمح لهذا العمق بالنمو. أثبت Lu et al. [22] أنه إذا كان عرض شبكة عصبية عميقة مع تنشيط ReLU أكبر تمامًا من بعد الإدخال ، فيمكن للشبكة تقريب أي تكامل وظيفة لايبزگ قابلة للتكامل ؛أما إذا كان العرض أصغر أو مساويًا لبعد الإدخال، فإن الشبكة العصبية العميقة ليست تقريبًا عالميًا. فالتفسير الاحتمالي [23] probabilistic فهو مشتق من مجال التعلم الآلي. يتميز بالاستدلال ، [11] [12] [1] [2] [16] < ref name = "MURPHY" /> وكذلك بالأمثلية فمفاهيم التدريب و الاختبار ، تتعلق بالتركيب و التعميم، على التوالي. وبشكل أكثر تحديداً، يعتبر التفسير الاحتمالي أن التفعيل غير الخطي هو دالة التوزيع التراكمي . [23] و قد أدى التفسير الاحتمالي إلى إدخال التسرب المنظم في الشبكات العصبية.[26] تم تقديم التفسير الاحتمالي من قبل الباحثين جون هوپفلد ودرو و نارندا و التعميمات في استطلاعات الرأي من قِبل بِشوپ. [27]

سجل و تاريخ التعلم العميق

تم تقديم مصطلح "التعلم العميق" إلى مجتمع التعلم الآلي بواسطة رينا ديتشر في عام 1986 ، [28][15] وإلى الشبكات العصبية الاصطناعية بواسطة إيگور أيزنبرگ وزملاؤه في عام 2000، في سياق الخلايا العصبية المنطقية.[29][30]

تم نشر أول خوارزمية تعلم عميق خاضعة للإشراف، ذات تغذية أمامية، مستقبلات متعددة المستويات من قِبل ألكسي إڤاخنينكو ولاپا في عام 1965.[31]وصفت ورقة بحثية عام 1971 لشبكة عميقة مع 8 طبقات تم تدريبها بواسطة خوارزمية مجموعة طرق للتعامل مع البيانات.[32]

بدأ العمل على أساليب بناء أخرى للتعلم العميق، خاصة تلك التي تم تصميمها من أجل رؤية الحاسب، بواسطة نيوكوجنيترون وهي شبكة عصبية اصطناعية متعددة الطبقات و التي قدمها كونيهيكو فوكوشيما في عام 1980.[33] في عام 1989، طبق يان ليكون مع آخرون خوارزمية انتشار عكسي القياسية و هي خوارزمية تستخدم على نطاق واسع في تدريب الشبكات العصبية ذات التغذية الأمامية في التعلم الخاضع للإشراف ، التي كانت موجودة كوضع عكسي لـ التمايز و الاختلاف التلقائي منذ عام 1970 ، [34][35][36][37] إلى شبكة عصبية عميقة بهدف التعرف على الرمز البريدي ZIP code المكتوب بخط اليد عبر البريد. أثناء عمل الخوارزمية، تطلب التدريب 3 أيام .[38]

بحلول عام 1991 ، تم استخدام هذه الأنظمة للتعرف على الأرقام المكتوبة بخط اليد المعزولة ثنائية الأبعاد ، بينما تم التعرف على الكائنات ثلاثية الأبعاد عن طريق مطابقة الصور ثنائية الأبعاد بنموذج كائن ثلاثي الأبعاد يدويًا. اقترح ونج وآخرون أن عقل الإنسان لا يستخدم نموذج كائن ثلاثي الأبعاد متحد ، وفي عام 1992 قاموا بنشر Cresceptron,[39][40][41] و هي طريقة لأداء التعرف على الكائن ثلاثي الأبعاد في المشاهد المشوشة. نظرًا لأنه يستخدم الصور الطبيعية مباشرةً ، بدأت كريسسبترون بالتعلم المرئي للأغراض العامة للعوالم ثلاثية الأبعاد الطبيعية. كريسسبترون فهي سلسلة من طبقات مماثلة لنيوكوجونيترون. لكن بينما يتطلب نيوكوجنيترون مبرمجًا بشريًا لميزات دمج اليد ، فقد تعلمت Cresceptron عددًا مفتوحًا من الميزات في كل طبقة دون إشراف ، حيث يتم تمثيل كل ميزة بواسطة الالتفاف convolution kernel. قامت كريسسبترون بتقسيم كل كائن تم تعلمه من مشهد تشوش من خلال التحليل الخلفي عبر الشبكة. الحد الأقصى للتجميع Max pooling ، الذي يتم اعتماده الآن في كثير من الأحيان بواسطة شبكات عصبية عميقة ( مثل اختبارات ImageNet ) ،و تم استخدامها لأول مرة لتقليل دقة الموقف بعامل (2 × 2) إلى 1 من خلال التسلسل لتحسين التعميم. في عام 1994 ، نشر أندريه دي كارڤاليو، مع مايك فيرهورست وديڤد بيسيت، نتائج تجريبية لشبكة عصبية متعددة الطبقات جبر بولياني، والمعروفة أيضًا باسم شبكة عصبية انعدام الوزن، مؤلفة من 3 طبقات ذاتية التنظيم لوحدة استخراج الشبكة العصبية (SOFT) متبوعة بوحدة شبكة عصبية ذات تصنيف متعدد الطبقات (GSN) ، والتي تم تدريبها بشكل مستقل. تستخرج كل طبقة في وحدة استخراج المعالم ميزات ذات تعقيد متزايد فيما يتعلق بالطبقة السابقة.[42]

في عام 1995، أوضح براندن فراي بإمكانية تدريب شبكة تحتوي على ستة طبقات متصلة بالكامل وعدة مئات من الوحدات المخفية باستخدام خوارزمية التنشيط و الخمول (استيقاظ-النوم) (لأكثر من يومين) ،حيث تم تطويرها بشكل مشترك مع پيتر ديان و هينتون.[43] تساهم العديد من العوامل في السرعة البطيئة، بما في ذلك مشكلة التدرج المتلاشي التي تم تحليلها في عام 1991 بواسطة سيپ هوكريتر.[44][45] فقد كانت النماذج الأكثر بساطة التي تستخدم ميزات يدوية خاصة بالمهمة أو العمل مثل مرشح گابور و آلات الدعم الشعاعي support vector machine (SVMs) خيارًا شائعًا في التسعينات وعام 2000 ،لكن بسبب الشبكات العصبية الاصطناعية (ANN) حصلنا على تكلفة حسابية و توصلنا لعدم فهم لكيفية توصيل الدماغ لشبكاته البيولوجية.

تم استكشاف كل من التعلم السطحي والعميق منذ سنوات عديدة(على سبيل المثال، الشبكات المتكررة) لشبكات ANN. [46][47][48] These methods never outperformed non-uniform internal-handcrafting Gaussian mixture model/Hidden Markov model (GMM-HMM) technology based on generative models of speech trained discriminatively.[49]وقد تم تحليل الصعوبات الرئيسية ، بما في ذلك تقلص التدرج [44] وضعف بنية الارتباط الزمني في النماذج التنبؤية العصبية.[50][51] صعوبات إضافية كانت في عدم وجود بيانات التدريب وقوة الحوسبة محدودة. تجنب معظم الباحثين في التعرف على الكلام الشبكات العصبية لمتابعة النمذجة التوليفية. و كان هنالك استثناء في SRI International في أواخر التسعينيات. بتمويل من حكومة الولايات المتحدة NSA National Security Agency و DARPA ، درست SRI الشبكات العصبية العميقة في التعرف على اللغة و الكلام. حقق فريق التعرف على المتحدث بقيادة لاري هِك لاري هيك أول نجاح كبير مع الشبكات العصبية العميقة في معالجة الكلام و في تقييم التعرف على اللغة لعام 1998 المعهد الوطني للمعايير والتكنولوجيا National Institute of Standards and Technology.[52] بينما حققت SRI نجاحًا مع شبكات عصبية عميقة في التعرف على المتحدث ، إلا أنها لم تنجح في إظهار نجاح مماثل في التعرف على الكلام. تم استكشاف مبدأ رفع الميزات "الأولية" عن التحسين المصنوع يدويًا لأول مرة بنجاح في بنية برنامج التشفير التلقائي العميق على ميزات الطيفية "الأولية" أو ميزات بنك-مرشحات خطية في أواخر التسعينيات ، [52] عرض تفوقها على ميزات Mel Cepstral التي تحتوي على مراحل التحول الثابت من الطيفية. الميزات الأولية للكلام ، شكل موجة waveform ، حيث أنتجت فيما بعد نتائج ممتازة على نطاق واسع.[53]

تم تبني العديد من جوانب التعرف على الكلام من خلال طريقة تعلم عميقة تسمى ذاكرة قصيرة المدى (LSTM)، وهي شبكة عصبية متكررة نشرتها هوكريتر و شميدهوبر في عام 1997.[54] تتجنب RNNs LSTM مشكلة تدرج التلاشي و الزوال ويمكن أن تتعلم مهام "التعلم العميق جدًا" [2] التي تتطلب ذكريات الأحداث التي حدثت آلاف الخطوات الزمنية المنفصلة من قبل ، والتي تعد مهمة للتعبير. في عام 2003 ، بدأت LSTM لتصبح قادرة على المنافسة مع أجهزة التعرف على الكلام التقليدية في بعض المهام.[55]تم دمجها لاحقًا مع التصنيف الزمني للتوصيل (CTC)[56] in stacks of LSTM RNNs.[57] في عام 2015 ، ذُكر أن التعرف على الكلام من Google شهد قفزة هائلة في الأداء بنسبة 49 ٪ من خلال LSTM و المدربين من CTC ، والتي أتاحوها من خلال البحث الصوتي بغوغل Google Voice Search .[58]

في عام 2006 ، تم النشر من قِبل جيف هينتون ، رسلان سالاخوتدينوڤ، أوسينديرو و تيه [59] [60][61] تم إظهار كيف يمكن تدريب طبقة شبكة عصبية بتغذية أمامية feedforward neural network متعددة التغذية بطبقة واحدة بشكل مسبق في وقت واحد ، بحيث يعامل كل طبقة بدورها على أنهاغير مقيدة آلة بولتزمان المقيدة restricted Boltzmann machine ، ثم صقلها باستخدام إشراف عكسي backpropagation .[62] تشير الأوراق البحثية إلى أن "التعلم" من أجل "شبكات الإيمان و الاعتقاد العميق.

التعلم العميق هو جزء من أحدث النظم في مختلف التخصصات ، وخاصة رؤية الكمبيوتر و التعرف التلقائي على الكلام (ASR).حيث تحسنت النتائج بشكل مطرد على مجموعات التقييم الشائعة الاستخدام مثل TIMIT (ASR) و MNIST و (تصنيف الصورة)، بالإضافة إلى مجموعة من مهام التعرف على الكلام و المفردات الكبيرة.[63][64][65] تم استبدال الشبكة العصبية التلافيفية (CNN) لـ ASR بواسطة CTC[56] for LSTM.[54][58][66][67][68][69][70] ولكن أكثر نجاحا في رؤية الحاسوبية. بدأ تأثير التعلم العميق في الصناعة في أوائل عام 2000 ، عندما قامت CNNs بالفعل بمعالجة ما يتراوح بين 10٪ و 20٪ من جميع الشيكات المكتوبة في الولايات المتحدة، وفقًا لـ Yann LeCun.[71] Yann LeCun (2016). بدأت التطبيقات الصناعية للتعلم العميق حتى التعرف على الكلام على نطاق واسع في عام 2010.. ورشة NIPS 2009 حول التعلم العميق للتعرف على الكلام[72] وكان الدافع وراء القيود أو الحدود المفروضة على نماذج عميقة من الكلام ، وإمكانية أن تعطى أكثر قدرة للأجهزة ومجموعات البيانات على نطاق واسع أن الشبكات العصبية العميقة (DNN) قد تصبح عملية. اعتُقد أن DNNs ما قبل التدريب باستخدام نماذج توليدية من شبكات الاعتقاد العميق (DBN) من شأنه أن يتغلب على الصعوبات الرئيسية في الشبكات العصبيةts.[73]ومع ذلك ، تم اكتشاف أن الاستعاضة عن التدريب المسبق بكميات كبيرة من بيانات التدريب من أجل النشر العكسي مباشرة عند استخدام DNNs مع طبقات الإخراج الكبيرة التي تعتمد على السياق أنتجت معدلات خطأ أقل بشكل كبير من نموذج مزيج گاوسي الحديث في ذلك الوقت (GMM) ) / نموذج ماركوف المخفي (HMM) وأيضًا من الأنظمة القائمة على النموذج التوليفي الأكثر تطوراً.[63][74] كانت طبيعة أخطاء التعرف الناتجة عن هذين النوعين من الأنظمة مختلفة بشكل مميز,[75][72]تم تقديم رؤى تقنية حول كيفية دمج التعلم العميق في نظام فك تشفير الكلام الحالي عالي الكفاءة ، والذي تم نشره بواسطة جميع الأنظمة الرئيسية للتعرف على الكلام .[11][76][77]فالتحليل في الفترة ما بين 2009-2010 ، على النقيض من GMM (ونماذج الكلام التوليفية الأخرى) مقابل نماذج DNN ، حيث حفز الاستثمار الصناعي المبكر على التعلم العميق للتعرف و إدراك الكلام,[75][72] في نهاية المطاف t`g; يؤدي إلى انتشار واسع النطاق والاستخدام المهيمن في تلك الصناعة. وقد تم هذا التحليل مع أداء مشابه (أقل من 1.5 ٪ في معدل الخطأ) بين DNNs التمييزية والنماذج التوليدية.[63][75][73][78]

في عام 2010، قام الباحثون بتوسيع التعلم العميق من TIMIT إلى التعرف على كلام المفردات الكبيرة ، من خلال اعتماد طبقات خرج كبيرة من DNN بناءً على حالات HMM التي تعتمد على السياق والتي صاغتها شجرة القرار.[79][80][81][76]

أدت التطورات في الأجهزة إلى الاهتمام المتجدد بالتعلم العميق. ففي عام 2009 ، شاركت Nvidia فيما أطلق عليه "الانفجار الكبير" للتعلم العميق ، "حيث تم تدريب الشبكات العصبية للتعلم العميق مع Nvidia وحدة معالجة الرسومات GPUs graphics processing unit .”[82]في تلك السنة أيضاً، استخدم دماغ گوگل وحدات معالجة الرسومات لـ Nvidia لإنشاء DNNs مؤهَّل. بينما ، قرر Andrew Ng أن وحدات معالجة الرسومات يمكن أن تزيد من سرعة أنظمة التعلم العميق بحوالي 100 مرة.[83] على وجه الخصوص ،فإن GPUs مناسبة تمامًا لحسابات المصفوفة / المتجهات التي تشارك في التعلم الآلي.[84][85][86] تعمل وحدات معالجة الرسومات على تسريع خوارزميات التدريب بأوامر من الحجم ، مما يقلل من أوقات التشغيل من أسابيع إلى أيام.[87][88] علاوة على ذلك ، يمكن استخدام تحسينات الأجهزة والخوارزميات المتخصصة من أجل المعالجة الفعالة لنماذج التعلم العميق.[89]

ثورة التعلم العميق

في عام 2012 ، فاز فريق بقيادة جورج داهل George E. Dahl بـ "Merck Molecular Activity Challenge" باستخدام شبكات عصبية عميقة متعددة المهام للتنبؤ بالهدف الجزيئي الحيوي biomolecular target لدواء واحد ما.[90][91]في عام 2014 ، استخدمت مجموعة Hochreiter للتعلم العميق لاكتشاف التأثيرات السامة غير المستهدفة للمواد الكيميائية البيئية في المغذيات والمنتجات المنزلية والأدوية وفازت بـ "تحدي بيانات Tox21" لـ NIH و FDA و المركز الوطني المتقدم للعلوم المفسرة NCATS.[92][93][94]

تم ملاحظة التأثيرات الإضافية الكبيرة في التعرف على الصور أو الأشياء من عام 2011 إلى عام 2012. على الرغم من أن شبكات CNN المدربة من قبل النشر العكسي كانت موجودة منذ عقود ، وتطبيقات GPU لشبكات NNs لسنوات ، بما في ذلك شبكات CNN ، والتطبيقات السريعة لشبكات CNN مع التجميع الأقصى على وحدات معالجة الرسومات في النمط من Ciresan و زملائها فقد كانت هنالك حاجة للتقدم في الرؤية الحاسوبية .[84][86][38][95][2] في عام 2011 ، حقق هذا النهج لأول مرة أداءً خارقاً في مسابقة التعرف على الأنماط المرئية. وفي عام 2011 أيضًا ، فاز بالمسابقة الصينية للكتابة اليدوية ICDAR ، وفي مايو 2012 ، فاز بمسابقة تجزئة الصورة ISBI.[96] حتى عام 2011 ، لم تلعب شبكات CNN دورًا رئيسيًا في مؤتمرات رؤية الحاسب ، لكن في يونيو 2012 ،من ورقة كتبها Ciresan et al. في المؤتمر الرائد ، أظهرت CVPR [97] كيف يمكن لـ cns-max-pooling على GPU أن تحسِّن بشكل كبير من العديد من السجلات القياسية للرؤية الحاسوبية . و في أكتوبر 2012 ،تم تشكيل نظام مماثل من قبل Krizhevsky et al.[5]ربح ImageNet في المنافسة على نطاق واسع بفارق كبير عن الأساليب السطحية لتعلم الآلة .و في نوفمبر 2012 ، فاز نظام Ciresan et al. أيضًا بمسابقة ICPR عن تحليل الصور الطبية الكبيرة للكشف عن السرطان ، وفي العام التالي أيضًا فاز MICCAI Grand Challenge حول نفس الموضوع.[98]في عامي 2013 و 2014 ، تم تخفيض معدل الخطأ في مهمة ImageNet باستخدام التعلم العميق ، وذلك في أعقاب اتجاه مماثل في التعرف على الكلام على نطاق واسع. نشر مشروع وولفرام لتعريف الصور هذه التحسينات.[99]

ثم تم توسيع تصنيف الصور إلى المهمة الأكثر تحديا المتمثلة في إنشاء أوصاف (تعليق) للصور ، وغالبا ما تكون عبارة عن مزيج من CNNs و LSTMs.[100][101][102][103]

يقدر بعض الباحثين أن انتصار ImageNet في أكتوبر 2012 يرتكز على بداية "ثورة تعليمية عميقة" حولت صناعة الذكاء الاصطناعي.[104]

في مارس 2019 ، تم منح كل جوشوا بنجك و جفري هنتن و يان ليكون جائزة تورنگ تقديراً عن الاختراقات المفاهيمية والهندسية التي جعلت الشبكات العصبية العميقة مكونًا مهمًا للحوسبة.

الشبكات العصبونية

الشبكات العصبونية الاصطناعية

تم استيحاء فكرة الشبكات العصبية الاصطناعية ANNs أو التوصيلية نظم الحوسبة من الشبكة العصبية البيولوجية التي تشكل عقول الكائنات الحية . فتتعلم مثل هذه الأنظمة (تحسين قدرتها تدريجياً) على القيام بالمهام من خلال النظر في الأمثلة ، بشكل عام دون برمجة خاصة بالمهام. على سبيل المثال ، في التعرف على الصور ، قد يتعلمون كيفية تحديد الصور التي تحتوي على القطط من خلال تحليل أمثلة الصور التي تم يدويًا المسمى على أنها "قطة" أو "لا قطة" واستخدام النتائج التحليلية لتحديد القطط في صور اخرى لقد وجدوا معظم الاستخدام في التطبيقات يصعب التعبير عنها باستخدام خوارزمية كمبيوتر تقليدية أي باستخدام البرمجة المستندة إلى القواعد. تعتمد ANN على مجموعة من الوحدات المتصلة تسمى الخلايا العصبية الاصطناعية، (تشبه الخلايا العصبية البيولوجية في الدماغ البيولوجي). يمكن لكل اتصال (المشبك) بين الخلايا العصبية نقل إشارة إلى خلية عصبية أخرى.و يمكن للخلية العصبية المستقبلة (ما بعد المشبكي) معالجة الإشارة (الإشارات) و من ثم معالجة الإشارة إلى الخلايا العصبية المتلقية لها . قد يكون للخلايا العصبية حالة ، يتم تمثيلها عمومًا بأرقام حقيقية، عادة بين 0 و 1. قد يكون للخلايا العصبية والمشابك أيضًا وزن يختلف مع تقدم التعلم ، مما قد يزيد أو يقلل من قوة الإشارة التي يرسلها في اتجاه سياق أو تيار نقل الإشارة . عادة ، يتم تنظيم الخلايا العصبية في طبقات. قد تقوم الطبقات المختلفة بإجراء أنواع مختلفة من التحويلات على مدخلاتها. تنتقل الإشارات من أول (إدخال) ، إلى آخر طبقة (إخراج) ، وربما بعد اجتياز الطبقات عدة مرات. كان الهدف الأساسي لنهج الشبكة العصبية هو حل المواضيع أو المشكلات بنفس الطريقة التي يحل بها الدماغ البشري. مع مرور الوقت ، تَركز الانتباه على مطابقة القدرات العقلية المحددة ، مما يؤدي إلى الانحرافات عن علم الأحياء مثل النشر العكسي، أو تمرير المعلومات في الاتجاه المعاكس وضبط الشبكة لتعكس تلك المعلومات. تم استخدام الشبكات العصبية في مجموعة متنوعة من المهام ، بما في ذلك رؤية الكمبيوتر ، التعرف على الكلام، الترجمة الآلية، الشبكة الاجتماعية ، ألعاب اللوحية وألعاب الفيديو والتشخيص الطبي. اعتبارًا من عام 2017 ، فقد تعددت الشبكات العصبية بما يتراوح بين عدة آلاف إلى بضعة ملايين وحدة وملايين من الوصلات. على الرغم من أن هذا العدد يكون أقل بعدة مرات من حيث الحجم من عدد الخلايا العصبية في الدماغ البشري ، فإن هذه الشبكات يمكنها أداء العديد من المهام على مستوى يتجاوز مستوى البشر (مثل التعرف على الوجوه ، ولعب ألعاب "Go"[105] ).

الشبكات العصبونية العميقة

هذه المقالة may be too technical for most readers to understand. Please improve هذه المقالة to make it understandable to non-experts, without removing the technical details. (July 2016) |

الشبكة العصبية العميقة (DNN) عبارة عن الشبكة العصبية الاصطناعية (ANN) ذات طبقات متعددة بين طبقات المدخلات والمخرجات. [12] [2] تجد DNN طريقة لمعالجة رياضية صحيحة لتحويل المدخلات إلى الإخراج ، سواء أكانت علاقة خطية أو علاقة غير خطية. تنتقل الشبكة عبر الطبقات لحساب احتمال كل مخرجات. على سبيل المثال ، فإن DNN الذي تم تدريبها على التعرف على سلالات الكلاب سوف تتجاوز الصورة المحددة وتحسب احتمال أن يكون الكلب في الصورة سلالة معينة. يمكن للمستخدم مراجعة النتائج وتحديد الاحتمالات التي يجب أن تعرضها الشبكة (أعلى من حد معين ، وما إلى ذلك) وإرجاع التسمية المقترحة. كل معالجة رياضية على هذا النحو تعتبر طبقة ، و DNN المعقدة لها العديد من الطبقات ، ومن هنا جاءت تسميتها الشبكات "العميقة". يمكن أن تمثل DNNs العلاقات المعقدة غير الخطية. تقوم بنيات DNN بإنشاء نماذج مركبة حيث يتم التعبير عن الكائن كتركيبة ذات طبقات من بدائية Primitive data type.[106] تمكّن الطبقات الإضافية من تكوين ميزات من الطبقات السفلية ، مما قد يؤدي إلى نمذجة البيانات المعقدة مع وحدات أقل من شبكة سطحية ذات أداء مشابه.[12]

وتشمل بنية العمق العديد من المتغيرات لعدد قليل من النهج الأساسية. وجد في كل أسلوب بناء نجاحًا في مجالات محددة. لا يمكن دائمًا مقارنة أداء العديد من البنيات ، ما لم يتم تقييمها على مجموعات البيانات نفسها. عادةً ما تكون DNNs شبكات تغذية حيث يتم من خلالها تدفق البيانات من طبقة الإدخال إلى طبقة الإخراج دون تكرار الحلقات. في البداية ، تقوم DNN بإنشاء خريطة للخلايا العصبية الافتراضية وتعيين قيم رقمية عشوائية ، أو "أوزان" ، للاتصالات فيما بينها. يتم مضاعفة الأوزان والمدخلات وإرجاع ناتج ما بين 0 و 1. إذا لم تتعرف الشبكة بدقة على نمط معين ، فستقوم الخوارزمية بضبط تلك الأوزان.[107]وبهذه الطريقة ، يمكن للخوارزمية أن تجعل بعض البارامترات أكثر نفوذاً ، إلى أن تحدد المعالجة الرياضية الصحيحة لمعالجة البيانات بالكامل.

الشبكات العصبية المتكررة (RNNs) ، والتي يمكن أن تتدفق البيانات في أي اتجاه ،حيث تستخدم لتطبيقات مثل نموذج اللغة language model .[108][109][110][111][112]حيث نجد أن الذاكرة طويلة المدى فعالة بشكل خاص لهذا الاستخدام.[54][113]

و حيث تستخدم في رؤية الكمبيوتر الشبكات العصبية العميقة التلافيفية (CNNs) (CNNs) .[114]تم تطبيق CNNs أيضًا على النموذج صوتي acoustic modeling للحصول على التعرف التلقائي على الكلام (ASR).[70]

التحديات

كما هو الحال مع ANNs ، يمكن أن تنشأ العديد من المشكلات مع DNNs المدربة بطريقة سطحية. فهنالك مشكلتان شائعتان هما الطفحان ووقت الحساب. DNNs عرضة للتركيب الزائد بسبب الطبقات المضافة من التجريد و الأفكار الملخصة ، والتي تسمح لهم بنمذجة التبعيات النادرة في بيانات التدريب.و التنظيم طريقة من طرق مثل تشذيب وحدة Ivakhnenko[32] أو اضمحلال الوزن (-regularization) أو التفرق و الانفصال (-regularization) يمكن تطبيقها أثناء التدريب لمكافحة التجاوز.[115] وبدلاً من ذلك ، يحذف تنظيم التسرب بشكل عشوائيّ الوحدات من الطبقات المخفية أثناء التدريب. هذا ما يساعد على استبعاد التبعيات النادرة.[116]أخيرًا ، يمكن زيادة البيانات من خلال أساليب مثل أخذ النتائج وتدويرها بحيث يمكن زيادة حجم مجموعات التدريب الأصغر لتقليل فرص التجهيز الزائد أو التركيب .[117]

يجب أن تراعي DNN العديد من بارامترات التدريب ، مثل الحجم (عدد الطبقات وعدد الوحدات لكل طبقة) و معدل التعلم والأوزان الأولية. قد لا يكون مسح فضاء الپارامتر للپارامترات المثلى ممكنًا بسبب التكلفة في الوقت والموارد الحسابية. و الحيل المختلفة ، مثل الخلط (حساب التدرج اللوني على العديد من الأمثلة التدريبية في وقت واحد بدلاً من الأمثلة الفردية)[118] تسريع الحساب. حيث أنتجت قدرات المعالجة الكبيرة للعديد من البنى الأساسية (مثل GPUs أو Intel Xeon Phi) سرعات كبيرة في التدريب ، بسبب ملاءمة بنية المعالجة لهذه المصفوفات وحسابات المتجهات.[119][120] بدلاً من ذلك ، قد يبحث المهندسون عن أنواع أخرى من الشبكات العصبية مع خوارزميات تدريب أكثر وضوحًا وتقاربًا. CMAC (وحدة التحكم المفصلية للنموذج المخيخي) هو أحد هذه الشبكات العصبية. لا تتطلب معدلات تعلم أو أوزان أولية عشوائية لـ CMAC. حيث يمكن ضمان أن تتقارب عملية التدريب في خطوة واحدة مع مجموعة جديدة من البيانات ، ويكون التعقيد الحسابي لخوارزمية التدريب خطياً فيما يتعلق بعدد الخلايا العصبية المعنية.[121][122]

التطبيقات

التعرف التلقائي على الكلام

يعد التعرف التلقائي على الكلام على نطاق واسع أول حالة ناجحة وأكثرها إقناعًا للتعلم العميق. يمكن لشبكات LSTM RNN أن تتعلم مهام "التعلم العميق جدًا" [2] التي تتضمن فواصل زمنية مدتها عدة ثوانٍ تحتوي على أحداث كلامية مفصولة بآلاف الخطوات الزمنية المنفصلة ، حيث تتوافق الخطوة الواحدة مع حوالي 10 مللي ثانية. LSTM مع نسيان البوابات الدخل s[113] منافسة مع أدوات التعرف على الكلام التقليدية في بعض الحالات و المهمات .[55]

كان النجاح الأولي في التعرف على الكلام يعتمد على مهام التعرف على نطاق صغير على أساس TIMIT. حيث تحتوي مجموعة البيانات على 630 متحدثًا من ثمانية لهجات رئيسية من اللغة الإنگليزية الأمريكية ، حيث يقرأ كل متحدث 10 جمل.[123] حجمها الصغير يتيح تجربة العديد من التكوينات. الأهم من ذلك ، أن مهمة TIMIT تتعلق بالتعرف على تسلسل الهاتف ، والذي ، على عكس التعرف على تسلسل الكلمات ، يسمح بنماذج لغة ضعيفة بايگرام للهاتف. يتيح ذلك تحليل جوانب النمذجة الصوتية للتعرف على الكلام بسهولة أكبر. تم تلخيص معدلات الخطأ المذكورة أدناه ، بما في ذلك هذه النتائج المبكرة والتي تم قياسها كنسبة مئوية من معدلات أخطاء الهاتف (PER) ، منذ عام 1991.

| المنهج | "معدل الخطأ بالمئة" (%) |

|---|---|

| التهيئة العشوائية ل RNN [124] | 26.1 |

| النظرية الافتراضية GMM-HMM | 25.6 |

| نموذج مسار خفي إنتاجي | 24.8 |

| تهيئة أحادية لDNN بشكل عشوائي | 23.4 |

| تهيئة أحادية لDBN-DNN | 22.4 |

| تهيئة سلسلة ثلاث أصوات GMM-HMM مع تدريب لBMMI | 21.7 |

| تهيئة أحادية لDBN-DNN على fnank | 20.7 |

| تلافيف DNN [125] | 20.0 |

| تلافيف DNN w. مع تجمع غير متجانس | 18.7 |

| تجمع لDNN/CNN/RNN [126] | 18.3 |

| LSTM ثنائية الاتجاه | 17.9 |

| التسلسل الهرمي التوافقي العميق لشبكة Maxout[127] | 16.5 |

ظهرت DNNs للتعرف على المتحدثين في أواخر التسعينيات والتعرّف على الكلام في الفترة بين 2009-2011 و LSTM في الفترة 2003-2007 ،حيث تسارعت وتيرة التقدم في ثمانية مجالات رئيسية:[11][78][76]

- زيادة/توسيع وتسريع تدريب DNN وفك التشفير

- تمييز تسلسل التدريب

- ميزة معالجة النماذج العميقة مع فهم قوي للآليات الأساسية

- التكيف مع DNNs والنماذج العميقة ذات صلة

- التعلم متعدد المهام Multi-task learning و نقل التعلم Inductive transfer بواسطة DNNs والنماذج العميقة ذات صلة

- شبكات CNN وكيفية تصميمها لاستغلال مجال المعرفة domain knowledge على أفضل وجه

- RNN ومتغيرات LSTM الغنية به

- أنواع أخرى من النماذج العميقة بما في ذلك النماذج القائمة على الموتر والنماذج العميقة / التمييزية المتكاملة.

11 من الأنظمة التجارية الكبرى للتعرف على الكلام (مثل، مايكروسوفت كورتانا، إكس بوكس، مترجم سكايپ، أمازون ألكسا، گوگل ناو، آپل سيري، بايدو و البحث الصوتي آي فلاي تك، و مجال إنتاج الكلام الفارق الدقيق، إلخ.) جميعها تعتمد على التعلم العميق .[11][128][129][130]

التعرف على الصور

MNIST هي مجموعة التقييم الشائعة لتصنيف الصور فهي مجموعة بيانات لقاعدة البيانات . تتكون MNIST من أرقام مكتوبة بخط اليد ويتضمن 60000 أمثلة تدريبية و 10000 من أمثلة الاختبار. كما هو الحال مع TIMIT ، حيث يتيح حجمها الصغير للمستخدمين اختبار تكوينات متعددة. و تتوفر قائمة شاملة بالنتائج على هذه المجموعة.[131]

وجدنا أن التعرف على الصور القائم على التعلم العميق "خارقًا للإنسان" ، مما أدى إلى نتائج أكثر دقة من نتائج المتسابقين من البشر. حدث هذا لأول مرة في عام 2011.[132]

المركبات و المحركات المدرَّبة على التعلم العميق توضح لنا الآن رؤية الكاميرا و المعاينة بزاوية 360 درجة.[133] مثال آخر هو التحليل الغير مألوف للتشوه الوجهي (FDNA) المستخدم لتحليل حالات التشوه البشري المرتبطة بقاعدة بيانات كبيرة من المتلازمات الجينية.

معالجة الفنون البصرية

هذا ما يرتبط ارتباطًا وثيقًا بالتقدم الذي تم إحرازه في التعرف على الصور بالتطبيق المتزايد لتقنيات التعلم العميق على مختلف مهام الفنون البصرية. أثبتت DNNs قدرتها على ، على سبيل المثال ، أ) تحديد الأسلوب المستخدم في لوحة ما وفي حقبة زمنية ما ، ب) محو الشكل العصبي - التقاط نمط عمل فني معين وتطبيقه بطريقة مرضية بصريًا على صورة عشوائية أو فيديو ، و ج) إنشاء صور ملفتة للنظر استنادًا إلى حقول الإدخال البصري العشوائية.[134][135]

معالجة الشبكات العصبونية

تم استخدام الشبكات العصبونية لتنفيذ نماذج اللغة منذ أوائل العقد الأول من القرن العشرين.[108][136] حيث ساعدت LSTM في تحسين الترجمة الآلية ونمذجة اللغة.[109][110][111]

التقنيات الرئيسية الأخرى في هذا المجال هي أخذ العينات السلبية[137] و تضمين الكلمة. حيث يمكن اعتبار تضمين الكلمات ، مثل "word2vec"، طبقة تمثيلية في بنية تعلم عميقة تحوّل كلمة ذرية أو محورية ما إلى تمثيل موضعي للكلمة بالنسبة إلى كلمات أخرى في مجموعة البيانات ؛ يتم تمثيل الموضع كنقطة في فضاء المتجه. و يتيح استخدام تضمين الكلمات كطبقة إدخال RNN للشبكة تحليل الجمل والعبارات باستخدام قواعد متجهية فعالة.حيث يمكن اعتبار القواعد النحوية للمتجهات بمثابة قواعد احتمالية خالية من السياق الاحتمالي (PCFG) يتم تنفيذها بواسطة RNN.[138] يمكن أن تقوم أجهزة التشفير التلقائي التكرارية و التي تم تصميمها بناء على الكلمات المضمنة بتقييم تشابه الجمل واكتشاف إعادة الصياغة.[138] تقدم البنى العصبونية العميقة أفضل النتائج لـ تحليل الدوائر الانتخابية،[139]ةتحليل المشاعر ,[140] استرجاع المعلومات,[141][142] فهم اللغة المتكلَّم بها ,[143] الترجمة الآلية ,[109][144] ربط كيان ما في سياق ما،[144] التعرف على أسلوب الكتابة,[145] تصنيف النصوص وغيرها.[146]

التطويرات الأخيرة تعمم تضمين الكلمة إلى تضمين الجملة.

تستخدم ترجمة گوگل شبكة ذاكرة كبيرة طويلة المدى نهاية إلى نهاية.[147][148][149][150][151][152] الترجمة الآلية من گوگل (GNMT) تستخدم الترجمة الآلية المستندة إلى الأمثلة التي يتعلم فيها النظام "من ملايين الأمثلة."[148]يقوم بترجمة "جمل كاملة في وقت واحد ، بدلا من القطع . ترجمة Google تدعم أكثر من مائة لغة .[148]ترمز الشبكة إلى "دلالات الجملة و ألفاظها" بدلاً من مجرد حفظ ترجمات العبارة إلى جمل".[148][153] تستخدم ترجمة اللغة الإنگليزية كوسيط بين معظم أزواج اللغات.[153]

اكتشاف الأدوية و علم السموم

تفشل نسبة كبيرة من الأدوية المرشحة في الحصول على موافقة الجهات التنظيمية.حيث تنجم هذه الإخفاقات عن عدم كفاية الفعالية (التأثير على الهدف) ، أو التفاعلات غير المرغوب فيها (الآثار غير المستهدفة) ، أو غير المتوقعة التأثيرات السامة toxic effects .[154][155] اكتشف البحث استخدام التعلم العميق لتنبؤ الأهداف الجزيئية الحيوية،[90][91]، و الآثار غير المستهدفة و التأثيرات السامة للمواد الكيميائية البيئية في العناصر الغذائية والمنتجات المنزلية والعقاقير. [92] [93][94]

AtomNet عبارة عن نظام تعليمي عميق قائم على البنية تصميم الأدوية.[156] تم استخدام AtomNet للتنبؤ بالجزيئات الحيوية المرشحة الجديدة لأهداف مرضية مثل Ebola virus[157] و تصلب الأنسجة المتعدد.[158][159] في عام 2019، استخدمت الشبكات العصبية التوليدية لإنتاج جزيئات تم التحقق من صحتها تجريبياً على الفئران [160], [161].

إدارة علاقات العملاء

تم استخدام التعلم التعزيزي العميق لتقريب قيمة الإجراءات للتسويق المباشر المحتملة، المعرّفة من حيث المتغيرات RFM customer value . تم توضيح أن وظيفة القيمة المقدرة لها تفسير طبيعي على أنها قيمة عمر العميل.[162]

نظم التوصية

استخدمت أنظمة التوصية التعلم العميق لاستخلاص سمات ذات مغزى لبناء نموذج عوامل كامنة يكون قادر على اقتراح مقطوعات موسيقية بناء على الاختيارات السابقة لنفس المستخدم.[163] [164] تم تطبيق التعلم العميق متعدد المقاطع لتعلم تفضيلات المستخدم في مجالات متعددة.[165]يستخدم النموذج مقاربة هجينة متعاونة وقائمة على المحتوى ويعزز التوصيات في مهام متعددة.

المعلوماتية الحيوية

تم استخدام التشفير التلقائي ANN في المعلوماتية الحيوية، للتنبؤ بشروح الجينات الوجودية وعلاقات الوظيفة الجينية.[166]

في المعلوماتية الطبية ، تم استخدام التعلم العميق للتنبؤ بجودة النوم بناءً على بيانات من الأجهزة القابلة للارتداء[167]وتوقعات المضاعفات الصحية من بيانات التسجيلات الصحية بطريقة إلكترونية electronic health record .[168] أظهر التعلم العميق أيضًا فاعلية في الرعاية الصحية.[169]

تحليل الصور الطبية

لقد تبين أن التعلم العميق قام بتقديم نتائج تنافسية في التطبيقات الطبية مثل تصنيف خلايا السرطان، واكتشاف الأمراض ، وتجزئة الأعضاء وتحسين الصور[170][171]

إعلانات الهاتف المحمول

إن العثور على جمهور مناسب لـ إعلانات الهاتف المحمول هو أمر صعب دائماً، حيث وجب النظر في العديد من نقاط البيانات واستيعابها قبل إنشاء شريحة مستهدفة واستخدامها في عرض الإعلانات بواسطة أي مخدم إعلانات.[172]لقد تم استخدام التعلم العميق في تفسير مجموعات البيانات الإعلانية الكبيرة متعددة الأبعاد. حيث يتم جمع العديد من نقاط البيانات عند الطلب / الخدمة / النقرة على الإنترنت خلال دورة الإعلان . و يمكن أن تشكل هذه المعلومات أساسًا للتعلم الآلي لتحسين اختيار الإعلانات.

استعادة الصور

لقد نجح تطبيق التعلم العميق على حل القضايا بطريقة معكوسة مثل إزالة الضجيج أو التنقية، الدقة العالية، الاكتشاف، و تلوين الأفلام.[173] تتضمن هذه التطبيقات طرقًا تعليمية مثل "تقليص الحقل من أجل الاستعادة الفعالة للصورة "[174]حيث يتم التدرب على مجموعة بيانات الصورة، Deep Image Prior حيث تتدرب على الصورة التي تحتاج إلى استعادة.

اكتشاف الاحتيال المالي

يتم تطبيق التعلم العميق بطريقة ناجحة على كشف الاحتيال المالي ومكافحة غسيل الأموال. حيث "تمكن النظام الكشف العميق عن مكافحة غسل الأموال من اكتشاف العلاقات والتشابهات بين البيانات والتعرف عليها، وكذلك تعلم كيفية اكتشاف الحالات الشاذة أو تصنيف أحداث معينة والتنبؤ بها". يمكن حل هذه القضية بتعزيز و تقوية كل من تقنيات التعلم الخاضعة للإشراف ، مثل تصنيف المعاملات المشبوهة والتعلم غير الخاضع للإشراف ، على سبيل المثال كاكتشاف أي شدوذ .[175]

الناحية العسكرية

طبقت وزارة الدفاع الأمريكية التعلم العميق لتدريب الروبوتات في مهام جديدة من خلال عملية الملاحظة.[176]

العلاقة مع التنمية البشرية من الناحية المعرفية و تطوير الإدراك

يرتبط التعلم العميق ارتباطًا وثيقًا بفئة من نظريات نمو و تطور الدماغ (على وجه التحديد ، نمو القشرة المخية حديثاً) التي اقترحها علماء الأعصاب الإدراكية cognitive neuroscientists في أوائل التسعينيات.[177][178][179][180] تم إنشاء أمثلة لهذه النظريات التنموية في النماذج الحسابية ، مما يجعلها نماذجاً لأنظمة التعلم العميق. تشترك هذه النماذج التنموية في الخاصية التي تدعمها مختلف ديناميكيات التعلم المقترحة في الدماغ (على سبيل المثال ، موجة من عامل نمو الأعصاب) و الداعمة للتنظيم الذاتي المماثلة إلى حد ما للشبكات العصبية المستخدمة في نماذج التعلم العميق. مثل نيوكورتكس، تستخدم الشبكات العصبية تسلسلًا هرميًا من المرشحات ذات الطبقات التي تأخذ كل طبقة في الاعتبار المعلومات من طبقة سابقة (أو بيئة التشغيل)، ثم تقوم بتمرير الخرج الخاص بها (وربما الإدخال الأصلي) ، إلى طبقات أخرى. تعطي هذه العملية مجموعة ذاتية التنظيم من محول ، مضبوطة جيدًا لبيئة التشغيل الخاصة بها. جاء في وصف عام 1995 ، "... يبدو أن دماغ الرضيع ينظم نفسه تحت تأثير موجات ما يسمى بالعوامل التغذوية ... حيث تتصل مناطق مختلفة من الدماغ بشكل تسلسلي ، مع وجود طبقة من الأنسجة تنضج قبل الأخرى وهكذا حتى ينضج كامل الدماغ ."[181]

وقد تم استخدام مجموعة متنوعة من الأساليب للتحقيق في مدى معقولية نماذج التعلم العميق من منظور بيولوجي عصبي. من ناحية، تم اقتراح العديد من المتغيرات لخوارزمية النشر العكسي من أجل زيادة واقعية المعالجة.[182][183]تجادل باحثون آخرون بأن الأشكال غير الخاضعة للرقابة للتعلم العميق ، مثل تلك القائمة على التسلسل الهرمي نماذج التوليف و شبكات الاعتقاد و المسلمات العميقة، قد تكون أقرب إلى الواقع البيولوجي.[184][185] في هذا الصدد، ارتبطت نماذج الشبكة العصبية التوليدية بالأدلة البيولوجية العصبية حول المعالجة القائمة على أخذ العينات في القشرة الدماغية.[186]

على الرغم من عدم إجراء مقارنة منهجية بين تنظيم الدماغ البشري وترميز الخلايا العصبية في الشبكات العميقة، فقد تم الإبلاغ عن العديد من التشابهات. على سبيل المثال ، يمكن أن تكون العمليات الحسابية التي تقوم بها وحدات التعلم العميق مشابهة لتلك الموجودة في الخلايا العصبية الفعلية[187][188] وذات الكثافة العصبية.[189] وبالمثل ، فإن التمثيلات التي طورتها نماذج التعلم العميق تشبه تلك المقاسة في النظام البصري للكائنات الحية من رتبة الرئيسيات[190] سواء في وحدة واحدة[191] أو على رتبة السكان[192] .

النشاط التجاري

تنفذ مختبرات الذكاء الاصطناعي لفيسبوك مهاماً مثل وضع علامات على الصور التي تم تحميلها تلقائياً مع أسماء الأشخاص الموجودين فيها.[193]

طورت DeepMind Technologie من Google نظامًا قادرًا على تعلم كيفية لعب أتاري ألعاب الفيديو باستخدام وحدات الپكسل فقط كمدخلات للبيانات. في عام 2015 ، أظهر نظامهم AlphaGo ، الذي تعلم لعبة Go جيدًا بما يكفي للتغلب على لاعب Go محترف.[194][195][196] تستخدم Google Translate LSTM للترجمة بين أكثر من 100 لغة. في عام 2015 ، أظهر Blippar ,i, تطبيقًا محمولًا للواقع المعزز augmented reality يستخدم التعلم العميق للتعرف على الأشياء في الوقت الحقيقي.[197]

في عام 2017 ، تم إطلاق Covariant.ai ، والذي يركز على دمج التعلم العميق في المصانع.[198]

اعتباراً من عام 2008,[199] طور باحثون في جامعة تكساس في أوستن The University of Texas at Austin (UT) إطارًا للتعلم الآلي يدعى "تدريب العامل يدويًا عن طريق التعزيز التقييمي ، أو TAMER" ، الذي اقترح أساليب جديدة للروبوتات أو برامج الكمبيوتر لتعلم كيفية أداء المهام من خلال التفاعل مع مدرب بشري.[176] تم التطوير لأول مرة باسم TAMER ، بعدها تم تقديم خوارزمية جديدة تسمى Deep TAMER في عام 2018 أثناء التعاون بين الولايات المتحدة مختبر أبحاث الجيش U.S. Army Research Laboratory (ARL) وباحثي UT.حيث استخدم Deep TAMER التعلم العميق لتوفير القدرة على تعلم مهام جديدة للروبوتات عن طريق الملاحظة.[176] باستخدام Deep TAMER ، تم تعليم الروبوت المهمة مع مدرب بشري ، ومشاهدة سياق الفيديوهات أو مراقبة إنسان يقوم بمهمة شخصية. حيث مارس الروبوت فيما بعد المهمة عن طريق بعض التدريب من المدرب ، الذي قدم ملاحظات مثل "عمل جيد" و "عمل سيئ".”[200]

تعليقات و ملاحظات

لقد جذب التعلم العميق كلاً من النقد أو الملاحظات والتعليقات ، و في بعض الحالات من خارج مجال علوم الحاسب.

الجانب النظري

يرتبط النقد أو الملاحظات الأساسية بعدم وجود نظرية حول بعض الأساليب أو النهج المتبعة.[201] تم تنفيذ نظرية التعلم في أكثر البنى العميقة شيوعاً باستخدام النسب المتدرجة التي تم فهمها جيداً. ومع ذلك ، فإن النظرية المحيطة بالخوارزميات الأخرى ، مثل الانحراف أو التباعد المتباين ، فهي أقل وضوحًا.[citation needed] (على سبيل المثال ، هل تتقارب؟ إذا كان الأمر كذلك ، فما مدى سرعة التقريب؟) غالبًا ما ينظر إليها على أنها صندوق أسود، مع معظم التأكيدات التي تمت تجريبياً ، بدلاً من الناحية النظرية.[202]

يشير آخرون إلى أنه ينبغي النظر إلى التعلم العميق كخطوة نحو تحقيق ذكاء اصطناعي متين، وليس كحل شامل. على الرغم من قوة أساليب التعلم العميق ، إلا أنها لا تزال تفتقر إلى الكثير من الوظائف اللازمة لتحقيق هذا الهدف بالكامل. لاحظ عالم النفس البحثي جاري ماركوس:

"من الناحية الواقعية ، التعلم العميق ليس سوى جزء من التحدي الأكبر المتمثل في بناء الآلات الذكية. هذه التقنيات تفتقر إلى طرق لتمثيل العلاقات السببية causal relationships (...) ليست لديها طرق واضحة ل أداء استدلالات منطقية logical inferences ، وهي لا تزال بعيدة عن دمج المعرفة المجردة ، مثل المعلومات حول ماهية الأشياء ، وما هدفها ، وكيف يتم استخدامها عادةً. أقوى أنظمة الذكاء الاصطناعي ، مثل واتسن (...) يستخدم تقنيات مثل التعلم العميق كعنصر واحد فقط في مجموعة معقدة للغاية من التقنيات ، بدءاً من التقنية الإحصائية الاستدلال البايزي إلى الاستنتاج المنطقي."[203]

وكبديل لهذا التركيز و التشديد على حدود التعلم العميق ، تكهن أحد المؤلفين بأنه قد يكون من الممكن تدريب مجموعة الرؤية الآلية لأداء المهمة المعقدة المتمثلة في التمييز بين "الرسومات القديمة" ورسومات تخيلات الهواة ، وافترض أن هذه الحساسية قد تمثل أساسيات التفاعل مع آلة غير مبتذلة.[204] اقترح هذا المؤلف نفسه أن يتماشى ذلك مع الأنثروبولوجيا أي العلوم الإنسانية ، التي تحدد الاهتمام بالجماليات كعنصر أساسي في الحداثة السلوكية behavioral modernity.[205]

في إشارة أخرى إلى فكرة أن الحساسية الخلاقة أو الفنية قد تندرج ضمن مستويات منخفضة نسبيًا من التسلسل الهرمي المعرفي ، لدينا مثلاً سلسلة منشورة من الرسوم البيانية للحالات الداخلية للشبكات العصبية العميقة (20-30 طبقة) تحاول تمييز الصور من البيانات العشوائية خاصة عن طريق الشبكات التي تم تدريبها[206]إثبات و إثبات فكرة الجاذبية بصرية : حيث تلقى الإشعار البحثي الأصلي أكثر من 1000 تعليق ، وكان موضوعًا لما كان في وقت ما أكثر المقالات التي يتم الوصول إليها بشكل متكرر على موقع الويب الخاص بـ الگارديان[207].

الأخطاء

تعرض بعض بنى التعلم العميق سلوكيات إشكالية و مريبة،[208]مثلاً كالتصنيف بشكل موثوق للصور الغير معروفة على أنها تنتمي إلى فئة مألوفة من الصور العادية[209] وتصنيف الاضطرابات الضئيلة من الصور المصنفة بشكل صحيح.[210]افترض Goertzel أن هذه السلوكيات ترجع إلى قيود في تمثيلاتها الداخلية وأن هذه القيود ستحول دون الاندماج في بنى متعددة المكونات غير متجانسة كالذكاء العام الاصطناعي(AGI).[208] قد تتم معالجة هذه المشكلات من خلال بنى التعلم العميقة التي تشكل حالات متجانسة لقواعد الصورة الداخلية[211]تحليل الكيانات والأحداث المرصودة و التي تم ملاحظتها.[208] ف تعلم القواعد (المرئية أو اللغوية) من بيانات التدريب سيكون مكافئًا لتقييد النظام بـ الاستنتاج بالمنطق السليم الذي يعمل وفقًا لمفاهيم القواعد النحوية قواعد الإنتاج وهو هدف أساسي لاكتساب اللغة البشرية[212] و الذكاء الصناعي (AI).[213]

التهديدات السيبرانية

مع انتقال التعلم العميق من المختبر إلى العالم الحقيقي ، تُظهر الأبحاث والتجارب أن الشبكات العصبية الاصطناعية عرضة للاختراقات والتضليل .[214]من خلال تحديد الأنماط التي تستخدمها هذه الأنظمة لأداء المهمة ، يمكن للمهاجمين تعديل المدخلات على شبكات ANN بطريقة تجعل الشبكة ANN مطابقة بشكل لم يتعرف عليه المراقبون. على سبيل المثال ، يمكن للمهاجم إجراء تغييرات طفيفة على صورة بحيث يجد ANN تطابقًا على الرغم من أن الصورة تتطلع إلى إنسان لا يشبه هدف البحث. مثل هذا التلاعب يسمى "الهجوم العدائي.”[215] في عام 2016 ، استخدم الباحثون ANN لصور طبية الطبيب بطريقة التجريب و الأخطاء ، وتحديد نقاط الاتصال الخاصة بالأشخاص الآخرين ، وبالتالي إنشاء صور خادعة . الصور المعدلة لا تبدو مختلفة عن عيون البشر. و قد أظهرت مجموعة أخرى أن الصور المطبوعة التي تمت معالجتها ثم صُورت بنجاح قامت بخداع نظام تصنيف الصور.[216] أحد الدفاعات هو البحث العكسي عن الصور ، حيث يتم إرسال صورة بتزييف محتمل إلى موقع مثل TinEye يمكنه حينئذٍ العثور على مثيلات أخرى منها . أما التنقيح هو البحث باستخدام أجزاء فقط من الصورة ، لتحديد الصور التي ربما تم أخذ تلك القطعة منها "" "." ""[217]

أظهرت مجموعة أخرى أن بعض الفن المخدر يمكن أن تخدع نظام التعرف على الوجه إلى الاعتقاد بأن الناس العاديين هم من المشاهير ، مما يسمح لشخص ما بانتحال شخصية فرد آخر. في عام 2017 ، أضاف الباحثون ملصقات إلى علامات التوقف وتسببت في إصابة ANN بسوء تصنيفها.[216]

ومع ذلك ، يمكن تدريب ANNs أيضًا على اكتشاف محاولات الخداع و الغش ، مما يحتمل أن يقود المهاجمين والمدافعين إلى سباق للتسلح على غرار النوع المعروف مسبقاً بالصناعة الدفاعية كالبرامج الضارة . فتم تدريب ANN على هزيمة برنامج مكافحة البرامج الضارة المستندة إلى ANN من خلال مهاجمة دفاع بشكل متكرر باستخدام برامج ضارة تم تغييرها باستمرار بواسطة خوارزمية وراثية حتى تخدع البرامج الضارة مع الحفاظ على قدرتها على إتلاف الهدف.[216]

أثبتت مجموعة أخرى أن بعض الأصوات قد تجعل گوگل ناو نظام الأوامر الصوتية يفتح عنوان ويب معينًا من شأنه تنزيل بعض من البرامج الضارة.[216]

في ما يسمى "بتسمم البيانات" ، يتم تهريب البيانات الخاطئة باستمرار إلى مجموعة تدريب على أنظمة التعلم الآلي لمنعها من تحقيق الإتقان في الإنجاز..[216]

انظر أيضاً

- تطبيقات في الذكاء الصناعي Applications of artificial intelligence

- مقارنة بين برامج التعلم العميق Comparison of deep learning software

- الاستشعار المضغوط Compressed sensing

- Echo state network

- قائمة مشاريع الذكاء الاصطناعي List of artificial intelligence projects

- Liquid state machine

- قائمة مجموعات البيانات لبحوث التعلم الآلي List of datasets for machine learning research

- الحوسبة الاحتياطية Reservoir computing

- الترميز المنتشر أو المتضائل sparse coding

المراجع

- ^ أ ب ت ث ج ح خ Bengio, Y.; Courville, A.; Vincent, P. (2013). "Representation Learning: A Review and New Perspectives". IEEE Transactions on Pattern Analysis and Machine Intelligence. 35 (8): 1798–1828. arXiv:1206.5538. doi:10.1109/tpami.2013.50. PMID 23787338.

- ^ أ ب ت ث ج ح خ د Schmidhuber, J. (2015). "Deep Learning in Neural Networks: An Overview". Neural Networks. 61: 85–117. arXiv:1404.7828. doi:10.1016/j.neunet.2014.09.003. PMID 25462637.

- ^ Bengio, Yoshua; LeCun, Yann; Hinton, Geoffrey (2015). "Deep Learning". Nature. 521 (7553): 436–444. Bibcode:2015Natur.521..436L. doi:10.1038/nature14539. PMID 26017442.

- ^ Ciresan, Dan; Meier, U.; Schmidhuber, J. (June 2012). "Multi-column deep neural networks for image classification". 2012 IEEE Conference on Computer Vision and Pattern Recognition: 3642–3649. arXiv:1202.2745. doi:10.1109/cvpr.2012.6248110. ISBN 978-1-4673-1228-8.

- ^ أ ب Krizhevsky, Alex; Sutskever, Ilya; Hinton, Geoffry (2012). "ImageNet Classification with Deep Convolutional Neural Networks" (PDF). NIPS 2012: Neural Information Processing Systems, Lake Tahoe, Nevada.

- ^ "Google's AlphaGo AI wins three-match series against the world's best Go player". TechCrunch. 25 May 2017.

- ^ Marblestone, Adam H.; Wayne, Greg; Kording, Konrad P. (2016). "Toward an Integration of Deep Learning and Neuroscience". Frontiers in Computational Neuroscience. 10: 94. doi:10.3389/fncom.2016.00094. PMC 5021692. PMID 27683554.

{{cite journal}}: CS1 maint: unflagged free DOI (link) - ^ Olshausen, B. A. (1996). "Emergence of simple-cell receptive field properties by learning a sparse code for natural images". Nature. 381 (6583): 607–609. Bibcode:1996Natur.381..607O. doi:10.1038/381607a0. PMID 8637596.

- ^ قالب:Cite arxiv

- ^ Schulz, Hannes; Behnke, Sven (2012-11-01). "Deep Learning". KI - Künstliche Intelligenz (in الإنجليزية). 26 (4): 357–363. doi:10.1007/s13218-012-0198-z. ISSN 1610-1987.

- ^ أ ب ت ث ج ح Deng, L.; Yu, D. (2014). "Deep Learning: Methods and Applications" (PDF). Foundations and Trends in Signal Processing. 7 (3–4): 1–199. doi:10.1561/2000000039.

- ^ أ ب ت ث ج Bengio, Yoshua (2009). "Learning Deep Architectures for AI" (PDF). Foundations and Trends in Machine Learning. 2 (1): 1–127. CiteSeerX 10.1.1.701.9550. doi:10.1561/2200000006. Archived from the original (PDF) on 2016-03-04. Retrieved 2015-09-03.

- ^ LeCun, Yann; Bengio, Yoshua; Hinton, Geoffrey (28 May 2015). "Deep learning". Nature. 521 (7553): 436–444. Bibcode:2015Natur.521..436L. doi:10.1038/nature14539. PMID 26017442.

- ^ (2007) "Greedy layer-wise training of deep networks" in Advances in neural information processing systems.: 153-160.

- ^ أ ب Jürgen Schmidhuber (2015). Deep Learning. Scholarpedia, 10(11):32832. Online

- ^ أ ب ت Hinton, G.E. (2009). "Deep belief networks". Scholarpedia. 4 (5): 5947. Bibcode:2009SchpJ...4.5947H. doi:10.4249/scholarpedia.5947.

- ^ أ ب Balázs Csanád Csáji (2001). Approximation with Artificial Neural Networks; Faculty of Sciences; Eötvös Loránd University, Hungary

- ^ أ ب ت Cybenko (1989). "Approximations by superpositions of sigmoidal functions" (PDF). Mathematics of Control, Signals, and Systems. 2 (4): 303–314. doi:10.1007/bf02551274. Archived from the original (PDF) on 2015-10-10.

- ^ أ ب ت Hornik, Kurt (1991). "Approximation Capabilities of Multilayer Feedforward Networks". Neural Networks. 4 (2): 251–257. doi:10.1016/0893-6080(91)90009-t.

- ^ أ ب Haykin, Simon S. (1999). Neural Networks: A Comprehensive Foundation. Prentice Hall. ISBN 978-0-13-273350-2.

- ^ أ ب Hassoun, Mohamad H. (1995). Fundamentals of Artificial Neural Networks. MIT Press. p. 48. ISBN 978-0-262-08239-6.

- ^ أ ب Lu, Z., Pu, H., Wang, F., Hu, Z., & Wang, L. (2017). The Expressive Power of Neural Networks: A View from the Width. Neural Information Processing Systems, 6231-6239.

- ^ أ ب ت Murphy, Kevin P. (24 August 2012). Machine Learning: A Probabilistic Perspective. MIT Press. ISBN 978-0-262-01802-9.

- ^ Patel, Ankit; Nguyen, Tan; Baraniuk, Richard (2016). "A Probabilistic Framework for Deep Learning" (PDF). Advances in Neural Information Processing Systems.

- ^ Sonoda, Sho; Murata, Noboru (2017). "Neural network with unbounded activation functions is universal approximator". Applied and Computational Harmonic Analysis. 43 (2): 233–268. doi:10.1016/j.acha.2015.12.005.

- ^ Hinton, G. E.; Srivastava, N.; Krizhevsky, A.; Sutskever, I.; Salakhutdinov, R.R. (2012). "Improving neural networks by preventing co-adaptation of feature detectors". arXiv:1207.0580 [math.LG].

- ^ Bishop، ChristopherM. (2006). Pattern Recognition and Machine Learning (PDF). Springer. ISBN 978-0-387-31073-2.

- ^ Rina Dechter (1986). بالتعلم أثناء البحث في مشاكل الرضا و القبول بالقيود و الحدود. في جامعة كاليفورنيا، قسم علوم الحاسب، مختبر النظم المعرفية.Online

- ^ Igor Aizenberg, Naum N. Aizenberg, Joos P.L. Vandewalle (2000). Multi-Valued and Universal Binary Neurons: Theory, Learning and Applications. Springer Science & Business Media.

- ^ Co-evolving recurrent neurons learn deep memory POMDPs. Proc. GECCO, Washington, D. C., pp. 1795-1802, ACM Press, New York, NY, USA, 2005.

- ^ Ivakhnenko, A. G. (1973). Cybernetic Predicting Devices. CCM Information Corporation.

- ^ أ ب Ivakhnenko, Alexey (1971). "Polynomial theory of complex systems". IEEE Transactions on Systems, Man and Cybernetics. 1 (4): 364–378. doi:10.1109/TSMC.1971.4308320.

- ^ Fukushima, K. (1980). "Neocognitron: A self-organizing neural network model for a mechanism of pattern recognition unaffected by shift in position". Biol. Cybern. 36 (4): 193–202. doi:10.1007/bf00344251. PMID 7370364.

- ^ Seppo Linnainmaa (1970). تمثيلاً لخطأ التقريب التراكمي لخوارزمية كمنشور تايلور لأخطاء التقريب المحلية . في رسالة ماجستير (بالفنلندية)، جامعة. هلسنكي.

- ^ Griewank, Andreas (2012). "Who Invented the Reverse Mode of Differentiation?" (PDF). Documenta Mathematica (Extra Volume ISMP): 389–400. Archived from the original (PDF) on 2017-07-21. Retrieved 2017-06-11.

- ^ Werbos, P. (1974). "Beyond Regression: New Tools for Prediction and Analysis in the Behavioral Sciences". Harvard University. Retrieved 12 June 2017.

- ^ Werbos, Paul (1982). "Applications of advances in nonlinear sensitivity analysis" (PDF). System modeling and optimization. Springer. pp. 762–770.

- ^ أ ب LeCun et al., "Backpropagation Applied to Handwritten Zip Code Recognition," Neural Computation, 1, pp. 541–551, 1989.

- ^ J. Weng, N. Ahuja and T. S. Huang, " Cresceptron: a self-organizing neural network which grows adaptively," Proc. International Joint Conference on Neural Networks, Baltimore, Maryland, vol I, pp. 576-581, June, 1992.

- ^ J. Weng, N. Ahuja and T. S. Huang, "Learning recognition and segmentation of 3-D objects from 2-D images," Proc. 4th International Conf. Computer Vision, Berlin, Germany, pp. 121-128, May, 1993.

- ^ J. Weng, N. Ahuja and T. S. Huang, "Learning recognition and segmentation using the Cresceptron," International Journal of Computer Vision, vol. 25, no. 2, pp. 105-139, Nov. 1997.

- ^ de Carvalho, Andre C. L. F.; Fairhurst, Mike C.; Bisset, David (1994-08-08). "An integrated Boolean neural network for pattern classification". Pattern Recognition Letters. 15 (8): 807–813. doi:10.1016/0167-8655(94)90009-4.

- ^ Hinton, Geoffrey E.; Dayan, Peter; Frey, Brendan J.; Neal, Radford (1995-05-26). "The wake-sleep algorithm for unsupervised neural networks". Science. 268 (5214): 1158–1161. Bibcode:1995Sci...268.1158H. doi:10.1126/science.7761831. PMID 7761831.

- ^ أ ب S. Hochreiter., "Untersuchungen zu dynamischen neuronalen Netzen," Diploma thesis. Institut f. Informatik, Technische Univ. Munich. Advisor: J. Schmidhuber, 1991.

- ^ Hochreiter, S.; et al. (15 January 2001). "Gradient flow in recurrent nets: the difficulty of learning long-term dependencies". In Kolen, John F.; Kremer, Stefan C. (eds.). A Field Guide to Dynamical Recurrent Networks. John Wiley & Sons. ISBN 978-0-7803-5369-5.

- ^ Morgan, Nelson; Bourlard, Hervé; Renals, Steve; Cohen, Michael; Franco, Horacio (1993-08-01). "Hybrid neural network/hidden markov model systems for continuous speech recognition". International Journal of Pattern Recognition and Artificial Intelligence. 07 (4): 899–916. doi:10.1142/s0218001493000455. ISSN 0218-0014.

- ^ Robinson, T. (1992). "A real-time recurrent error propagation network word recognition system". ICASSP. Icassp'92: 617–620. ISBN 9780780305328.

- ^ Waibel, A.; Hanazawa, T.; Hinton, G.; Shikano, K.; Lang, K. J. (March 1989). "Phoneme recognition using time-delay neural networks" (PDF). IEEE Transactions on Acoustics, Speech, and Signal Processing. 37 (3): 328–339. doi:10.1109/29.21701. hdl:10338.dmlcz/135496. ISSN 0096-3518.

- ^ Baker, J.; Deng, Li; Glass, Jim; Khudanpur, S.; Lee, C.-H.; Morgan, N.; O'Shaughnessy, D. (2009). "Research Developments and Directions in Speech Recognition and Understanding, Part 1". IEEE Signal Processing Magazine. 26 (3): 75–80. Bibcode:2009ISPM...26...75B. doi:10.1109/msp.2009.932166.

- ^ Bengio, Y. (1991). "Artificial Neural Networks and their Application to Speech/Sequence Recognition". McGill University Ph.D. thesis.

- ^ Deng, L.; Hassanein, K.; Elmasry, M. (1994). "Analysis of correlation structure for a neural predictive model with applications to speech recognition". Neural Networks. 7 (2): 331–339. doi:10.1016/0893-6080(94)90027-2.

- ^ أ ب Heck, L.; Konig, Y.; Sonmez, M.; Weintraub, M. (2000). "Robustness to Telephone Handset Distortion in Speaker Recognition by Discriminative Feature Design". Speech Communication. 31 (2): 181–192. doi:10.1016/s0167-6393(99)00077-1.

- ^ "Acoustic Modeling with Deep Neural Networks Using Raw Time Signal for LVCSR (PDF Download Available)". ResearchGate. Retrieved 2017-06-14.

- ^ أ ب ت Hochreiter, Sepp; Schmidhuber, Jürgen (1997-11-01). "Long Short-Term Memory". Neural Computation. 9 (8): 1735–1780. doi:10.1162/neco.1997.9.8.1735. ISSN 0899-7667. PMID 9377276.

- ^ أ ب Graves, Alex; Eck, Douglas; Beringer, Nicole; Schmidhuber, Jürgen (2003). "Biologically Plausible Speech Recognition with LSTM Neural Nets" (PDF). 1st Intl. Workshop on Biologically Inspired Approaches to Advanced Information Technology, Bio-ADIT 2004, Lausanne, Switzerland. pp. 175–184.

- ^ أ ب Graves, Alex; Fernández, Santiago; Gomez, Faustino (2006). "Connectionist temporal classification: Labelling unsegmented sequence data with recurrent neural networks". Proceedings of the International Conference on Machine Learning, ICML 2006: 369–376. CiteSeerX 10.1.1.75.6306.

- ^ Santiago Fernandez, Alex Graves, and Jürgen Schmidhuber (2007). An application of recurrent neural networks to discriminative keyword spotting. Proceedings of ICANN (2), pp. 220–229.

- ^ أ ب Sak, Haşim; Senior, Andrew; Rao, Kanishka; Beaufays, Françoise; Schalkwyk, Johan (September 2015). "Google voice search: faster and more accurate".

- ^ Hinton, Geoffrey E. (2007-10-01). "Learning multiple layers of representation". Trends in Cognitive Sciences. 11 (10): 428–434. doi:10.1016/j.tics.2007.09.004. ISSN 1364-6613. PMID 17921042.

- ^ Hinton, G. E.; Osindero, S.; Teh, Y. W. (2006). "A Fast Learning Algorithm for Deep Belief Nets" (PDF). Neural Computation. 18 (7): 1527–1554. doi:10.1162/neco.2006.18.7.1527. PMID 16764513.

- ^ Bengio, Yoshua (2012). "Practical recommendations for gradient-based training of deep architectures". arXiv:1206.5533 [cs.LG].

- ^ G. E. Hinton., "Learning multiple layers of representation," Trends in Cognitive Sciences, 11, pp. 428–434, 2007.

- ^ أ ب ت Hinton, G.; Deng, L.; Yu, D.; Dahl, G.; Mohamed, A.; Jaitly, N.; Senior, A.; Vanhoucke, V.; Nguyen, P.; Sainath, T.; Kingsbury, B. (2012). "Deep Neural Networks for Acoustic Modeling in Speech Recognition --- The shared views of four research groups". IEEE Signal Processing Magazine. 29 (6): 82–97. doi:10.1109/msp.2012.2205597.

- ^ Deng, Li; Hinton, Geoffrey; Kingsbury, Brian (1 May 2013). "New types of deep neural network learning for speech recognition and related applications: An overview". Microsoft Research – via research.microsoft.com.

- ^ Deng, L.; Li, J.; Huang, J. T.; Yao, K.; Yu, D.; Seide, F.; Seltzer, M.; Zweig, G.; He, X. (May 2013). "Recent advances in deep learning for speech research at Microsoft". 2013 IEEE International Conference on Acoustics, Speech and Signal Processing: 8604–8608. doi:10.1109/icassp.2013.6639345. ISBN 978-1-4799-0356-6.

- ^ Sak, Hasim; Senior, Andrew; Beaufays, Francoise (2014). "Long Short-Term Memory recurrent neural network architectures for large scale acoustic modeling" (PDF).

- ^ قالب:Cite arxiv

- ^ Zen, Heiga; Sak, Hasim (2015). "Unidirectional Long Short-Term Memory Recurrent Neural Network with Recurrent Output Layer for Low-Latency Speech Synthesis" (PDF). Google.com. ICASSP. pp. 4470–4474.

- ^ Deng, L.; Abdel-Hamid, O.; Yu, D. (2013). "A deep convolutional neural network using heterogeneous pooling for trading acoustic invariance with phonetic confusion" (PDF). Google.com. ICASSP.

- ^ أ ب Sainath, T. N.; Mohamed, A. r; Kingsbury, B.; Ramabhadran, B. (May 2013). "Deep convolutional neural networks for LVCSR". 2013 IEEE International Conference on Acoustics, Speech and Signal Processing: 8614–8618. doi:10.1109/icassp.2013.6639347. ISBN 978-1-4799-0356-6.

- ^ يان ليكون (2016). Slides on Deep Learning Online

- ^ أ ب ت NIPS Workshop: Deep Learning for Speech Recognition and Related Applications, Whistler, BC, Canada, Dec. 2009 (Organizers: Li Deng, Geoff Hinton, D. Yu).

- ^ أ ب Keynote talk: Recent Developments in Deep Neural Networks. ICASSP, 2013 (by Geoff Hinton).

- ^ D. Yu, L. Deng, G. Li, and F. Seide (2011). "Discriminative pretraining of deep neural networks," U.S. Patent Filing.

- ^ أ ب ت Deng, L.; Hinton, G.; Kingsbury, B. (2013). "New types of deep neural network learning for speech recognition and related applications: An overview (ICASSP)" (PDF).

{{cite journal}}: Cite journal requires|journal=(help) - ^ أ ب ت Yu, D.; Deng, L. (2014). Automatic Speech Recognition: A Deep Learning Approach (Publisher: Springer). ISBN 978-1-4471-5779-3.

- ^ "Deng receives prestigious IEEE Technical Achievement Award - Microsoft Research". Microsoft Research. 3 December 2015.

- ^ أ ب Li, Deng (September 2014). "Keynote talk: 'Achievements and Challenges of Deep Learning - From Speech Analysis and Recognition To Language and Multimodal Processing'". Interspeech.

- ^ Yu, D.; Deng, L. (2010). "Roles of Pre-Training and Fine-Tuning in Context-Dependent DBN-HMMs for Real-World Speech Recognition". NIPS Workshop on Deep Learning and Unsupervised Feature Learning.

- ^ Seide, F.; Li, G.; Yu, D. (2011). "Conversational speech transcription using context-dependent deep neural networks". Interspeech.

- ^ Deng, Li; Li, Jinyu; Huang, Jui-Ting; Yao, Kaisheng; Yu, Dong; Seide, Frank; Seltzer, Mike; Zweig, Geoff; He, Xiaodong (2013-05-01). "Recent Advances in Deep Learning for Speech Research at Microsoft". Microsoft Research.

- ^ "Nvidia CEO bets big on deep learning and VR". Venture Beat. April 5, 2016.

- ^ "From not working to neural networking". The Economist.

- ^ أ ب Oh, K.-S.; Jung, K. (2004). "GPU implementation of neural networks". Pattern Recognition. 37 (6): 1311–1314. doi:10.1016/j.patcog.2004.01.013.

- ^ "A Survey of Techniques for Optimizing Deep Learning on GPUs", S. Mittal and S. Vaishay, Journal of Systems Architecture, 2019

- ^ أ ب Chellapilla, K., Puri, S., and Simard, P. (2006). High performance convolutional neural networks for document processing. International Workshop on Frontiers in Handwriting Recognition.

- ^ Cireşan, Dan Claudiu; Meier, Ueli; Gambardella, Luca Maria; Schmidhuber, Jürgen (2010-09-21). "Deep, Big, Simple Neural Nets for Handwritten Digit Recognition". Neural Computation. 22 (12): 3207–3220. arXiv:1003.0358. doi:10.1162/neco_a_00052. ISSN 0899-7667. PMID 20858131.

- ^ Raina, Rajat; Madhavan, Anand; Ng, Andrew Y. (2009). "Large-scale Deep Unsupervised Learning Using Graphics Processors". Proceedings of the 26th Annual International Conference on Machine Learning. ICML '09. New York, NY, USA: ACM: 873–880. CiteSeerX 10.1.1.154.372. doi:10.1145/1553374.1553486. ISBN 9781605585161.

- ^ Sze, Vivienne; Chen, Yu-Hsin; Yang, Tien-Ju; Emer, Joel (2017). "Efficient Processing of Deep Neural Networks: A Tutorial and Survey". arXiv:1703.09039 [cs.CV].

- ^ أ ب "Announcement of the winners of the Merck Molecular Activity Challenge".

- ^ أ ب "Multi-task Neural Networks for QSAR Predictions | Data Science Association". www.datascienceassn.org. Retrieved 2017-06-14.

- ^ أ ب "Toxicology in the 21st century Data Challenge"

- ^ أ ب "NCATS Announces Tox21 Data Challenge Winners".

- ^ أ ب "Archived copy". Archived from the original on 2015-02-28. Retrieved 2015-03-05.

{{cite web}}: CS1 maint: archived copy as title (link) - ^ Ciresan, D. C.; Meier, U.; Masci, J.; Gambardella, L. M.; Schmidhuber, J. (2011). "Flexible, High Performance Convolutional Neural Networks for Image Classification" (PDF). International Joint Conference on Artificial Intelligence. doi:10.5591/978-1-57735-516-8/ijcai11-210.

- ^ Ciresan, Dan; Giusti, Alessandro; Gambardella, Luca M.; Schmidhuber, Juergen (2012). Pereira, F.; Burges, C. J. C.; Bottou, L.; Weinberger, K. Q. (eds.). Advances in Neural Information Processing Systems 25 (PDF). Curran Associates, Inc. pp. 2843–2851.

- ^ خطأ استشهاد: وسم

<ref>غير صحيح؛ لا نص تم توفيره للمراجع المسماة: 9 - ^ Ciresan, D.; Giusti, A.; Gambardella, L.M.; Schmidhuber, J. (2013). "Mitosis Detection in Breast Cancer Histology Images using Deep Neural Networks". Proceedings MICCAI. Lecture Notes in Computer Science. 7908: 411–418. doi:10.1007/978-3-642-40763-5_51. ISBN 978-3-642-38708-1.

- ^ "The Wolfram Language Image Identification Project". www.imageidentify.com. Retrieved 2017-03-22.

- ^ قالب:Cite arxiv.

- ^ قالب:Cite arxiv.

- ^ قالب:Cite arxiv.

- ^ Zhong, Sheng-hua; Liu, Yan; Liu, Yang (2011). "Bilinear Deep Learning for Image Classification". Proceedings of the 19th ACM International Conference on Multimedia. MM '11. New York, NY, USA: ACM: 343–352. doi:10.1145/2072298.2072344. ISBN 9781450306164.

- ^ "Why Deep Learning Is Suddenly Changing Your Life". Fortune. 2016. Retrieved 13 April 2018.

- ^ Silver, David; Huang, Aja; Maddison, Chris J.; Guez, Arthur; Sifre, Laurent; Driessche, George van den; Schrittwieser, Julian; Antonoglou, Ioannis; Panneershelvam, Veda (January 2016). "Mastering the game of Go with deep neural networks and tree search". Nature. 529 (7587): 484–489. Bibcode:2016Natur.529..484S. doi:10.1038/nature16961. ISSN 1476-4687. PMID 26819042.

- ^ Szegedy, Christian; Toshev, Alexander; Erhan, Dumitru (2013). "Deep neural networks for object detection". Advances in Neural Information Processing Systems: 2553–2561.

- ^ Hof, Robert D. "Is Artificial Intelligence Finally Coming into Its Own?". MIT Technology Review. Retrieved 2018-07-10.

- ^ أ ب Gers, Felix A.; Schmidhuber, Jürgen (2001). "LSTM Recurrent Networks Learn Simple Context Free and Context Sensitive Languages". IEEE Trans. Neural Netw. 12 (6): 1333–1340. doi:10.1109/72.963769. PMID 18249962.

- ^ أ ب ت Sutskever, L.; Vinyals, O.; Le, Q. (2014). "Sequence to Sequence Learning with Neural Networks" (PDF). Proc. NIPS.

- ^ أ ب قالب:Cite arxiv

- ^ أ ب قالب:Cite arxiv

- ^ Mikolov, T.; et al. (2010). "Recurrent neural network based language model" (PDF). Interspeech.

- ^ أ ب "Learning Precise Timing with LSTM Recurrent Networks (PDF Download Available)". ResearchGate. Retrieved 2017-06-13.

- ^ LeCun, Y.; et al. (1998). "Gradient-based learning applied to document recognition". Proceedings of the IEEE. 86 (11): 2278–2324. doi:10.1109/5.726791.

- ^ Bengio, Y.; Boulanger-Lewandowski, N.; Pascanu, R. (May 2013). "Advances in optimizing recurrent networks". 2013 IEEE International Conference on Acoustics, Speech and Signal Processing: 8624–8628. arXiv:1212.0901. CiteSeerX 10.1.1.752.9151. doi:10.1109/icassp.2013.6639349. ISBN 978-1-4799-0356-6.

- ^ Dahl, G.; et al. (2013). "Improving DNNs for LVCSR using rectified linear units and dropout" (PDF). ICASSP.

- ^ "Data Augmentation - deeplearning.ai | Coursera". Coursera. Retrieved 2017-11-30.

- ^ Hinton, G. E. (2010). "A Practical Guide to Training Restricted Boltzmann Machines". Tech. Rep. UTML TR 2010-003.

- ^ You, Yang; Buluç, Aydın; Demmel, James (November 2017). "Scaling deep learning on GPU and knights landing clusters". Proceedings of the International Conference for High Performance Computing, Networking, Storage and Analysis on - SC '17. SC '17, ACM. pp. 1–12. doi:10.1145/3126908.3126912. ISBN 9781450351140. Retrieved 5 March 2018.

- ^ Viebke, André; Memeti, Suejb; Pllana, Sabri; Abraham, Ajith (March 2017). "CHAOS: a parallelization scheme for training convolutional neural networks on Intel Xeon Phi". The Journal of Supercomputing. 75: 197–227. arXiv:1702.07908. doi:10.1007/s11227-017-1994-x.

- ^ Ting Qin, et al. "A learning algorithm of CMAC based on RLS." Neural Processing Letters 19.1 (2004): 49-61.

- ^ Ting Qin, et al. "Continuous CMAC-QRLS and its systolic array." Neural Processing Letters 22.1 (2005): 1-16.

- ^ TIMIT Acoustic-Phonetic Continuous Speech Corpus Linguistic Data Consortium, Philadelphia.

- ^ Robinson, Tony (30 September 1991). "Several Improvements to a Recurrent Error Propagation Network Phone Recognition System". Cambridge University Engineering Department Technical Report. CUED/F-INFENG/TR82. doi:10.13140/RG.2.2.15418.90567.

- ^ Abdel-Hamid, O.; et al. (2014). "Convolutional Neural Networks for Speech Recognition". IEEE/ACM Transactions on Audio, Speech, and Language Processing. 22 (10): 1533–1545. doi:10.1109/taslp.2014.2339736.

- ^ Deng, L.; Platt, J. (2014). "Ensemble Deep Learning for Speech Recognition" (PDF). Proc. Interspeech.

- ^ Tóth, Laszló (2015). "Phone Recognition with Hierarchical Convolutional Deep Maxout Networks" (PDF). EURASIP Journal on Audio, Speech, and Music Processing. 2015. doi:10.1186/s13636-015-0068-3.

{{cite journal}}: CS1 maint: unflagged free DOI (link) - ^ "How Skype Used AI to Build Its Amazing New Language Translator | WIRED". Wired. 2014-12-17. Retrieved 2017-06-14.

- ^ قالب:Cite arxiv

- ^ "Plenary presentation at ICASSP-2016" (PDF).

- ^ "MNIST handwritten digit database, Yann LeCun, Corinna Cortes and Chris Burges". yann.lecun.com.

- ^ Cireşan, Dan; Meier, Ueli; Masci, Jonathan; Schmidhuber, Jürgen (August 2012). "Multi-column deep neural network for traffic sign classification". Neural Networks. Selected Papers from IJCNN 2011. 32: 333–338. CiteSeerX 10.1.1.226.8219. doi:10.1016/j.neunet.2012.02.023. PMID 22386783.

- ^ Nvidia Demos a Car Computer Trained with "Deep Learning" (2015-01-06), David Talbot, MIT Technology Review

- ^ G. W. Smith; Frederic Fol Leymarie (10 April 2017). "The Machine as Artist: An Introduction". Arts. 6 (4): 5. doi:10.3390/arts6020005.

{{cite journal}}: CS1 maint: unflagged free DOI (link) - ^ Blaise Agüera y Arcas (29 September 2017). "Art in the Age of Machine Intelligence". Arts. 6 (4): 18. doi:10.3390/arts6040018.

{{cite journal}}: CS1 maint: unflagged free DOI (link) - ^ Bengio, Yoshua; Ducharme, Réjean; Vincent, Pascal; Janvin, Christian (March 2003). "A Neural Probabilistic Language Model". J. Mach. Learn. Res. 3: 1137–1155. ISSN 1532-4435.

- ^ Goldberg, Yoav; Levy, Omar (2014). "word2vec Explained: Deriving Mikolov et al.'s Negative-Sampling Word-Embedding Method". arXiv:1402.3722 [cs.CL].

- ^ أ ب Socher, Richard; Manning, Christopher. "Deep Learning for NLP" (PDF). Retrieved 26 October 2014.

- ^ Socher, Richard; Bauer, John; Manning, Christopher; Ng, Andrew (2013). "Parsing With Compositional Vector Grammars" (PDF). Proceedings of the ACL 2013 Conference.

- ^ Socher, Richard (2013). "Recursive Deep Models for Semantic Compositionality Over a Sentiment Treebank" (PDF).

{{cite journal}}: Cite journal requires|journal=(help) - ^ Shen, Yelong; He, Xiaodong; Gao, Jianfeng; Deng, Li; Mesnil, Gregoire (2014-11-01). "A Latent Semantic Model with Convolutional-Pooling Structure for Information Retrieval". Microsoft Research.

- ^ Huang, Po-Sen; He, Xiaodong; Gao, Jianfeng; Deng, Li; Acero, Alex; Heck, Larry (2013-10-01). "Learning Deep Structured Semantic Models for Web Search using Clickthrough Data". Microsoft Research.

- ^ Mesnil, G.; Dauphin, Y.; Yao, K.; Bengio, Y.; Deng, L.; Hakkani-Tur, D.; He, X.; Heck, L.; Tur, G.; Yu, D.; Zweig, G. (2015). "Using recurrent neural networks for slot filling in spoken language understanding". IEEE Transactions on Audio, Speech, and Language Processing. 23 (3): 530–539. doi:10.1109/taslp.2014.2383614.

- ^ أ ب Gao, Jianfeng; He, Xiaodong; Yih, Scott Wen-tau; Deng, Li (2014-06-01). "Learning Continuous Phrase Representations for Translation Modeling". Microsoft Research.

- ^ Brocardo, Marcelo Luiz; Traore, Issa; Woungang, Isaac; Obaidat, Mohammad S. (2017). "Authorship verification using deep belief network systems". International Journal of Communication Systems. 30 (12): e3259. doi:10.1002/dac.3259.

- ^ "Deep Learning for Natural Language Processing: Theory and Practice (CIKM2014 Tutorial) - Microsoft Research". Microsoft Research. Retrieved 2017-06-14.

- ^ Turovsky, Barak (November 15, 2016). "Found in translation: More accurate, fluent sentences in Google Translate". The Keyword Google Blog. Retrieved March 23, 2017.

- ^ أ ب ت ث Schuster, Mike; Johnson, Melvin; Thorat, Nikhil (November 22, 2016). "Zero-Shot Translation with Google's Multilingual Neural Machine Translation System". Google Research Blog. Retrieved March 23, 2017.

- ^ Sepp Hochreiter; Jürgen Schmidhuber (1997). "Long short-term memory". Neural Computation. 9 (8): 1735–1780. doi:10.1162/neco.1997.9.8.1735. PMID 9377276.

- ^ Felix A. Gers; Jürgen Schmidhuber; Fred Cummins (2000). "Learning to Forget: Continual Prediction with LSTM". Neural Computation. 12 (10): 2451–2471. CiteSeerX 10.1.1.55.5709. doi:10.1162/089976600300015015.

- ^ Wu, Yonghui; Schuster, Mike; Chen, Zhifeng; Le, Quoc V; Norouzi, Mohammad; Macherey, Wolfgang; Krikun, Maxim; Cao, Yuan; Gao, Qin; Macherey, Klaus; Klingner, Jeff; Shah, Apurva; Johnson, Melvin; Liu, Xiaobing; Kaiser, Łukasz; Gouws, Stephan; Kato, Yoshikiyo; Kudo, Taku; Kazawa, Hideto; Stevens, Keith; Kurian, George; Patil, Nishant; Wang, Wei; Young, Cliff; Smith, Jason; Riesa, Jason; Rudnick, Alex; Vinyals, Oriol; Corrado, Greg; et al. (2016). "Google's Neural Machine Translation System: Bridging the Gap between Human and Machine Translation". arXiv:1609.08144 [cs.CL].

- ^ "An Infusion of AI Makes Google Translate More Powerful Than Ever." Cade Metz, WIRED, Date of Publication: 09.27.16. https://www.wired.com/2016/09/google-claims-ai-breakthrough-machine-translation/

- ^ أ ب Boitet, Christian; Blanchon, Hervé; Seligman, Mark; Bellynck, Valérie (2010). "MT on and for the Web" (PDF). Retrieved December 1, 2016.

- ^ Arrowsmith, J; Miller, P (2013). "Trial watch: Phase II and phase III attrition rates 2011-2012". Nature Reviews Drug Discovery. 12 (8): 569. doi:10.1038/nrd4090. PMID 23903212.

- ^ Verbist, B; Klambauer, G; Vervoort, L; Talloen, W; The Qstar, Consortium; Shkedy, Z; Thas, O; Bender, A; Göhlmann, H. W.; Hochreiter, S (2015). "Using transcriptomics to guide lead optimization in drug discovery projects: Lessons learned from the QSTAR project". Drug Discovery Today. 20 (5): 505–513. doi:10.1016/j.drudis.2014.12.014. PMID 25582842.

- ^ Wallach, Izhar; Dzamba, Michael; Heifets, Abraham (2015-10-09). "AtomNet: A Deep Convolutional Neural Network for Bioactivity Prediction in Structure-based Drug Discovery". arXiv:1510.02855 [cs.LG].

- ^ "Toronto startup has a faster way to discover effective medicines". The Globe and Mail. Retrieved 2015-11-09.

- ^ "Startup Harnesses Supercomputers to Seek Cures". KQED Future of You. Retrieved 2015-11-09.

- ^ "Toronto startup has a faster way to discover effective medicines".

- ^ Zhavoronkov, Alex (2019). "Deep learning enables rapid identification of potent DDR1 kinase inhibitors". Nature Biotechnology. doi:10.1038/s41587-019-0224-x.

{{cite journal}}: Cite has empty unknown parameter:|1=(help) - ^ Gregory, Barber. "A Molecule Designed By AI Exhibits 'Druglike' Qualities". Wired.

- ^ قالب:Cite arxiv

- ^ van den Oord, Aaron; Dieleman, Sander; Schrauwen, Benjamin (2013). Burges, C. J. C.; Bottou, L.; Welling, M.; Ghahramani, Z.; Weinberger, K. Q. (eds.). Advances in Neural Information Processing Systems 26 (PDF). Curran Associates, Inc. pp. 2643–2651.

- ^ X.Y. Feng, H. Zhang, Y.J. Ren, P.H. Shang, Y. Zhu, Y.C. Liang, R.C. Guan, D. Xu, (2019), "The Deep Learning–Based Recommender System “Pubmender” for Choosing a Biomedical Publication Venue: Development and Validation Study", Journal of medical Internet research, 21 (5): e12957

- ^ Elkahky, Ali Mamdouh; Song, Yang; He, Xiaodong (2015-05-01). "A Multi-View Deep Learning Approach for Cross Domain User Modeling in Recommendation Systems". Microsoft Research.

- ^ Chicco, Davide; Sadowski, Peter; Baldi, Pierre (1 January 2014). Deep Autoencoder Neural Networks for Gene Ontology Annotation Predictions. ACM. pp. 533–540. doi:10.1145/2649387.2649442. hdl:11311/964622. ISBN 9781450328944.

{{cite book}}:|journal=ignored (help) - ^ Sathyanarayana, Aarti (2016-01-01). "Sleep Quality Prediction From Wearable Data Using Deep Learning". JMIR mHealth and uHealth. 4 (4): e125. doi:10.2196/mhealth.6562. PMC 5116102. PMID 27815231.

{{cite journal}}: CS1 maint: unflagged free DOI (link) - ^ Choi, Edward; Schuetz, Andy; Stewart, Walter F.; Sun, Jimeng (2016-08-13). "Using recurrent neural network models for early detection of heart failure onset". Journal of the American Medical Informatics Association. 24 (2): 361–370. doi:10.1093/jamia/ocw112. ISSN 1067-5027. PMC 5391725. PMID 27521897.

- ^ healthcare-challenges-and-opportunities-d2eee7e2545 "Deep Learning in Healthcare: Challenges and Opportunities". Medium. 2016-08-12. Retrieved 2018-04-10.

{{cite web}}: Check|url=value (help) - ^ Litjens, Geert; Kooi, Thijs; Bejnordi, Babak Ehteshami; Setio, Arnaud Arindra Adiyoso; Ciompi, Francesco; Ghafoorian, Mohsen; van der Laak, Jeroen A.W.M.; van Ginneken, Bram; Sánchez, Clara I. (December 2017). "A survey on deep learning in medical image analysis". Medical Image Analysis. 42: 60–88. arXiv:1702.05747. doi:10.1016/j.media.2017.07.005. PMID 28778026.

- ^ Forslid, Gustav; Wieslander, Hakan; Bengtsson, Ewert; Wahlby, Carolina; Hirsch, Jan-Michael; Stark, Christina Runow; Sadanandan, Sajith Kecheril (October 2017). "Deep Convolutional Neural Networks for Detecting Cellular Changes Due to Malignancy". 2017 IEEE International Conference on Computer Vision Workshops (ICCVW). Venice: IEEE: 82–89. doi:10.1109/ICCVW.2017.18. ISBN 9781538610343.

- ^ De, Shaunak; Maity, Abhishek; Goel, Vritti; Shitole, Sanjay; Bhattacharya, Avik (2017). "Predicting the popularity of instagram posts for a lifestyle magazine using deep learning". 2nd IEEE Conference on Communication Systems, Computing and IT Applications: 174–177. doi:10.1109/CSCITA.2017.8066548. ISBN 978-1-5090-4381-1.

- ^ "Colorizing and Restoring Old Images with Deep Learning". FloydHub Blog (in الإنجليزية). 2018-11-13. Retrieved 2019-10-11.

- ^ "Shrinkage Fields for Effective Image Restoration" in Computer Vision and Pattern Recognition (CVPR), 2014 IEEE Conference on..

- ^ Czech, Tomasz. "Deep learning: the next frontier for money laundering detection". Global Banking and Finance Review.

- ^ أ ب ت "Army researchers develop new algorithms to train robots". EurekAlert!. Retrieved 2018-08-29.

- ^ Utgoff, P. E.; Stracuzzi, D. J. (2002). "Many-layered learning". Neural Computation. 14 (10): 2497–2529. doi:10.1162/08997660260293319. PMID 12396572.

- ^ Elman, Jeffrey L. (1998). Rethinking Innateness: A Connectionist Perspective on Development. MIT Press. ISBN 978-0-262-55030-7.

- ^ Shrager, J.; Johnson, MH (1996). "Dynamic plasticity influences the emergence of function in a simple cortical array". Neural Networks. 9 (7): 1119–1129. doi:10.1016/0893-6080(96)00033-0. PMID 12662587.

- ^ Quartz, SR; Sejnowski, TJ (1997). "The neural basis of cognitive development: A constructivist manifesto". Behavioral and Brain Sciences. 20 (4): 537–556. CiteSeerX 10.1.1.41.7854. doi:10.1017/s0140525x97001581.

- ^ S. Blakeslee., "In brain's early growth, timetable may be critical," The New York Times, Science Section, pp. B5–B6, 1995.

- ^ Mazzoni, P.; Andersen, R. A.; Jordan, M. I. (1991-05-15). "A more biologically plausible learning rule for neural networks". Proceedings of the National Academy of Sciences. 88 (10): 4433–4437. Bibcode:1991PNAS...88.4433M. doi:10.1073/pnas.88.10.4433. ISSN 0027-8424. PMC 51674. PMID 1903542.

- ^ O'Reilly, Randall C. (1996-07-01). "Biologically Plausible Error-Driven Learning Using Local Activation Differences: The Generalized Recirculation Algorithm". Neural Computation. 8 (5): 895–938. doi:10.1162/neco.1996.8.5.895. ISSN 0899-7667.

- ^ Testolin, Alberto; Zorzi, Marco (2016). "Probabilistic Models and Generative Neural Networks: Towards an Unified Framework for Modeling Normal and Impaired Neurocognitive Functions". Frontiers in Computational Neuroscience. 10: 73. doi:10.3389/fncom.2016.00073. ISSN 1662-5188. PMC 4943066. PMID 27468262.

{{cite journal}}: CS1 maint: unflagged free DOI (link) - ^ Testolin, Alberto; Stoianov, Ivilin; Zorzi, Marco (September 2017). "Letter perception emerges from unsupervised deep learning and recycling of natural image features". Nature Human Behaviour. 1 (9): 657–664. doi:10.1038/s41562-017-0186-2. ISSN 2397-3374. PMID 31024135.

- ^ Buesing, Lars; Bill, Johannes; Nessler, Bernhard; Maass, Wolfgang (2011-11-03). "Neural Dynamics as Sampling: A Model for Stochastic Computation in Recurrent Networks of Spiking Neurons". PLOS Computational Biology. 7 (11): e1002211. Bibcode:2011PLSCB...7E2211B. doi:10.1371/journal.pcbi.1002211. ISSN 1553-7358. PMC 3207943. PMID 22096452.

{{cite journal}}: CS1 maint: unflagged free DOI (link) - ^ Morel, Danielle; Singh, Chandan; Levy, William B. (2018-01-25). "Linearization of excitatory synaptic integration at no extra cost". Journal of Computational Neuroscience. 44 (2): 173–188. doi:10.1007/s10827-017-0673-5. ISSN 0929-5313. PMID 29372434.

- ^ Cash, S.; Yuste, R. (February 1999). "Linear summation of excitatory inputs by CA1 pyramidal neurons". Neuron. 22 (2): 383–394. doi:10.1016/s0896-6273(00)81098-3. ISSN 0896-6273. PMID 10069343.

- ^ Olshausen, B; Field, D (2004-08-01). "Sparse coding of sensory inputs". Current Opinion in Neurobiology. 14 (4): 481–487. doi:10.1016/j.conb.2004.07.007. ISSN 0959-4388. PMID 15321069.

- ^ Yamins, Daniel L K; DiCarlo, James J (March 2016). "Using goal-driven deep learning models to understand sensory cortex". Nature Neuroscience. 19 (3): 356–365. doi:10.1038/nn.4244. ISSN 1546-1726. PMID 26906502.

- ^ Zorzi, Marco; Testolin, Alberto (2018-02-19). "An emergentist perspective on the origin of number sense". Phil. Trans. R. Soc. B. 373 (1740): 20170043. doi:10.1098/rstb.2017.0043. ISSN 0962-8436. PMC 5784047. PMID 29292348.

- ^ Güçlü, Umut; van Gerven, Marcel A. J. (2015-07-08). "Deep Neural Networks Reveal a Gradient in the Complexity of Neural Representations across the Ventral Stream". Journal of Neuroscience. 35 (27): 10005–10014. arXiv:1411.6422. doi:10.1523/jneurosci.5023-14.2015. PMC 6605414. PMID 26157000.

- ^ Metz, C. (12 December 2013). "Facebook's 'Deep Learning' Guru Reveals the Future of AI". Wired.

- ^ "Google AI algorithm masters ancient game of Go". Nature News & Comment. Retrieved 2016-01-30.

- ^ Silver, David; Huang, Aja; Maddison, Chris J.; Guez, Arthur; Sifre, Laurent; Driessche, George van den; Schrittwieser, Julian; Antonoglou, Ioannis; Panneershelvam, Veda; Lanctot, Marc; Dieleman, Sander; Grewe, Dominik; Nham, John; Kalchbrenner, Nal; Sutskever, Ilya; Lillicrap, Timothy; Leach, Madeleine; Kavukcuoglu, Koray; Graepel, Thore; Hassabis, Demis (28 January 2016). "Mastering the game of Go with deep neural networks and tree search". Nature. 529 (7587): 484–489. Bibcode:2016Natur.529..484S. doi:10.1038/nature16961. ISSN 0028-0836. PMID 26819042.قالب:Closed access

- ^ "A Google DeepMind Algorithm Uses Deep Learning and More to Master the Game of Go | MIT Technology Review". MIT Technology Review. Retrieved 2016-01-30.

- ^ "Blippar Demonstrates New Real-Time Augmented Reality App". TechCrunch.

- ^ A.I. Researchers Leave Elon Musk Lab to Begin Robotics Start-Up

- ^ "TAMER: Training an Agent Manually via Evaluative Reinforcement - IEEE Conference Publication". ieeexplore.ieee.org. Retrieved 2018-08-29.

- ^ "Talk to the Algorithms: AI Becomes a Faster Learner". governmentciomedia.com. Retrieved 2018-08-29.

- ^ Marcus, Gary (2018-01-14). "In defense of skepticism about deep learning". Gary Marcus. Retrieved 2018-10-11.