الذكاء العام الاصطناعي

| جزء من سلسلة عن |

| الذكاء الاصطناعي |

|---|

الذكاء العام الاصطناعي Artificial general intelligence (AGI) هو الذكاء الافتراضي[1] للآلة ولديه القدرة على فهم أو تعلم أي مهمة فكرية والتي يستطيع الإنسان القيام بها. إنه هدف أساسي لبعض أبحاث الذكاء الاصطناعي وموضوع شائع في الخيال العلمي و الدراسات المستقبلية. يمكن أيضًا الإشارة إلى الذكاء الاصطناعي العام باسم الذكاء الاصطناعي القوي strong AI،[2][3][4] الذكاء الاصطناعي الكامل full AI،[5] أو الإجراء الذكي العام general intelligent action.[6] تحتفظ بعض المصادر الأكاديمية بمصطلح "ذكاء اصطناعي قوي" للآلات التي يمكنها اختبار الوعي.[7] فمن المتوقع أن يكون الذكاء الاصطناعي الحالي على بعد عقود من الذكاء الاصطناعي العام.[8][9]

على عكس الذكاء الاصطناعي القوي، الذكاء الاصطناعي الضعيف[10] (يسمى أيضًا بالذكاء الاصطناعي الضيق[3]) لا يُقصد به أداء القدرات البشرية الإدراكية، بالأحرى، يقتصر الذكاء الاصطناعي الضعيف على استخدام البرامج لدراسة أو إنجاز حل المشكلات أو مهام التفكير.

اعتباراً من عام 2017، أكثر من أربعين منظمة تقوم بالبحث بنشاط في الذكاء الاصطناعي العام.[11]

. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

المتطلبات

تم اقتراح معايير مختلفة لـ الذكاء (أشهرها اختبار تورِنگ ولكن حتى الآن، لا يوجد تعريف يرضي الجميع.[12] ومع ذلك، هناك اتفاق واسع بين باحثي الذكاء الاصطناعي على أن الذكاء مطلوب للقيام بما يلي:[13]

- السبب، استخدم الإستراتيجية، وحل الألغاز، وإصدار الأحكام بحكم عدم اليقين;

- تمثيل المعرفة، بما في ذلك المعرفة المنطقية;

- الخطة;

- التعلم;

- التواصل في اللغة الطبيعية;

- و دمج كل هذه المهارات نحو أهداف مشتركة.

تشمل القدرات المهمة الأخرى القدرة على الإحساس (على سبيل المثال النظر) والقدرة على التصرف (على سبيل المثال تحريك الأشياء ومعالجتها) في العالم الميط حيث يجب مراعاة السلوك الذكي.[14] قد يشمل ذلك القدرة على اكتشاف الخطر والاستجابة له.[15] تميل العديد من المناهج متعددة التخصصات للذكاء (على سبيل المثال العلوم المعرفية و الذكاء الحسابي و اتخاذ القرار) إلى التأكيد على الحاجة إلى النظر في سمات إضافية مثل التصور (تعتبر القدرة على تكوين صور ومفاهيم ذهنية لم تتم برمجتها فيها)[16] و الحكم الذاتي.[17] الأنظمة القائمة على الحاسب والتي تظهر العديد من هذه القدرات موجودة بالفعل (على سبيل المثال انظر الإبداع الحسابي، الاستدلال الآلي، نظام دعم القرار، الروبوت، الحساب التطوري، الوكيل الذكي)، ولكن ليس بالمستويات البشرية بعد.

اختبارات لتأكيد الذكاء الاصطناعي العام على المستوى البشري

تم النظر في الاختبارات التالية لتأكيد الذكاء الاصطناعي العام على المستوى البشري:[18][19]

- اختبار تورنگ ( تورنگ)

- آلة وإنسان كلاهما يتحاوران بشكل غير مرئي مع إنسان آخر، الذي يجب عليه تقييم أيهما هو الآلة، والذي يجتاز الاختبار إذا كان بإمكانه خداع المقيِّم لجزء كبير من الوقت. ملحوظة: لا يصف تورنگ ما يجب اعتباره ذكاءً، فقط أن معرفة أنها آلة ويجب أن يستبعدها.

- اختبار القهوة ( ڤزنياك)

- مطلوب آلة لدخول منزل أمريكي عادي ومعرفة كيفية صنع القهوة: ابحث عن آلة القهوة، وابحث عن القهوة، وأضف الماء، وابحث عن كوب، وقم بتحضير القهوة بالضغط على الأزرار المناسبة.

- اختبار الروبوت الجامعي لطلاب الكلية ( گورتزل)

- آلة تُسجل في إحدى الجامعات، وتلتحق بنفس الفصول الدراسية التي يمر بها البشر وتجتازها، وتحصل على الشهادة.

- اختبار التوظيف ( نيلسن)

- تعمل الآلة في وظيفة مهمة اقتصادياً، حيث تؤدي على الأقل أداء الإنسان في نفس الوظيفة.

المشكلات التي تتطلب حل الذكاء الاصطناعي العام

تُعرف أصعب المسائل التي تواجه أجهزة الحاسب بشكل غير رسمي باسم الذكاء الاصطناعي الكامل "AI-Complete" أو الذكاء الاصطناعي الصارم "AI-hard"، مما يعني أن حلها يعادل الكفاءة العامة للذكاء البشري، أو الذكاء الاصطناعي القوي، بما يتجاوز قدرات خوارزمية محددة الغرض.[20]

يُفترض أن تتضمن مشكلات للذكاء الاصطناعي الكامل رؤية الحاسب، فهم اللغة الطبيعية، والتعامل مع الظروف غير المتوقعة أثناء حل أي مشكلة في العالم الحقيقي.[21]

لا يمكن حل مشكلات الذكاء الاصطناعي الكامل باستخدام تكنولوجيا الحاسب الحالية وحدها، وتتطلب أيضًا حساب بشري. قد تكون هذه الخاصية مفيدة، على سبيل المثال، لاختبار وجود البشر، كما تهدف CAPTCHA إلى القيام به؛ و أمن الحاسب لصد هجوم القوى العدوانية.[22][23]

تاريخ

الذكاء الاصطناعي الكلاسيكي

بدأت أبحاث الذكاء الاصطناعي الحديثة في منتصف الخمسينيات.[24] كان الجيل الأول من باحثي الذكاء الاصطناعي مقتنعين بأن الذكاء الاصطناعي العام ممكن وأنه سيكون موجوداً في غضون بضعة عقود فقط. كتب رائد الذكاء الاصطناعي هربرت أ. سايمون في عام 1965: "ستكون الآلات قادرة، في غضون عشرين عاماً، على القيام بأي عمل يمكن للإنسان القيام به."[25] كانت تنبؤاتهم مصدر إلهام لشخصية ستانلي كوبريك و آرثر سي كلارك HAL 9000، اللذين جسدا ما اعتقد باحثو الذكاء الاصطناعي أنه بإمكانهم إنشاؤه بحلول عام 2001. فكان رائد الذكاء الاصطناعي مارڤن مينسكي مستشاراً[26]في مشروع جعل HAL 9000 واقعيًا قدر الإمكان وفقًا لتوقعات الإجماع في ذلك الوقت؛ اقتبس كريڤير منه قوله حول هذا الموضوع في عام 1967، "في غضون جيل ... سيتم حل مشكلة إنشاء الذكاء الاصطناعي بشكل فعال،"[27] على الرغم من أن مينسكي صرح أنه تم نقل قوله بشكل خاطئ.[بحاجة لمصدر]

ومع ذلك، في أوائل السبعينيات، أصبح من الواضح أن الباحثين قد قللوا بشكل كبير من صعوبة المشروع. وأصبحت وكالات التمويل متشككة في الذكاء الاصطناعي العام ووضعت الباحثين تحت ضغط متزايد لإنتاج "ذكاء اصطناعي تطبيقي" مفيد.[28]مع بداية الثمانينيات من القرن الماضي، أعاد مشروع حاسب الجيل الخامس في اليابان إحياء الاهتمام بالذكاء الاصطناعي العام، ووضع جدول زمني مدته عشر سنوات يتضمن أهدافًا للذكاء الاصطناعي العام مثل "إجراء محادثة غير رسمية".[29] استجابةً لذلك ولنجاح الأنظمة الخبيرة، قامت كل من الصناعة والحكومة بضخ الأموال مرة أخرى إلى هذه الميدان.[30]ومع ذلك، فقد انهارت الثقة في الذكاء الاصطناعي بشكل مذهل في أواخر الثمانينيات، ولم تتحقق أهداف مشروع الحاسب من الجيل الخامس.[31] للمرة الثانية خلال 20 عامًا، تبين أن باحثي الذكاء الاصطناعي الذين توقعوا الإنجاز الوشيك للذكاء الاصطناعي العام هم في الواقع مخطئون. بحلول التسعينيات، اكتسب باحثو الذكاء الاصطناعي شهرة في تقديم وعود عبثية. أصبحوا مترددين في تقديم تنبؤات بشكل تام[32]ولتجنب أي ذكر للذكاء الاصطناعي "على المستوى البشري" خوفًا من وصفهم بـ "الحالمين الجامحين"."[33]

البحث الضيق للذكاء الاصطناعي

في التسعينيات وأوائل القرن الحادي والعشرين، حقق الذكاء الاصطناعي السائد نجاحاً تجارياً أكبر بكثير واحتراماً أكاديمياً من خلال التركيز على مسائل فرعية محددة حيث يمكنهم تقديم نتائج يمكن التحقق منها بالإضافة لتطبيقات تجارية، مثل الشبكات العصبية الاصطناعية والتعلم الآلي الإحصائي.[34] تُستخدم أنظمة "الذكاء الاصطناعي التطبيقي" هذه الآن على نطاق واسع في جميع أنحاء صناعة التكنولوجيا، ويتم تمويل الأبحاث في هذا السياق بشكل كبير في الأوساط الأكاديمية والصناعية. حالياً، يعتبر التطوير في هذا المجال اتجاهاً ناشئاً، ومن المتوقع أن نصل لمرحلة ناضجة و مدروسة في أكثر من 10 سنوات.[35]

يأمل معظم باحثي الذكاء الاصطناعي السائد في إمكانية تطوير ذكاء اصطناعي قوي من خلال الجمع بين البرامج التي تحل مسائل فرعية مختلفة. فقد كتب هانز موراڤك في عام 1988:

"أنا واثق من أن هذا الطريق التصاعدي للذكاء الاصطناعي سيلتقي يومًا ما بالطريق التقليدي من أعلى إلى أسفل بأكثر من نصف الطريق، ويكون جاهزًا لتوفير الكفاءة في العالم الحقيقي و المعرفة المنطقية التي كانت محبطةً للغاية بعيدة المنال في برامج التفكير. ستقدم الآلات الذكية إنتاجاً عندما يتم دفع الارتفاع الذهبي المجازي لتوحيد الجهود."[36]

ومع ذلك، حتى هذه الفلسفة الأساسية كانت موضع نزاع. على سبيل المثال، اختتم ستيڤان هارناد من جامعة پرنستون ورقته البحثية عام 1990 حول فرضية المعرفة الأساسية الرمز بالقول:

غالبًا ما تم التعبير عن التوقع بأن المناهج "من أعلى إلى أسفل" (الرمزية) لنمذجة الإدراك ستلبي بطريقة ما مناهج "من أسفل إلى أعلى" (حسية) في مكان ما بينهما. إذا كانت اعتبارات المعرفة الأساسية في هذه الورقة صحيحة، فإن هذا التوقع سيكون معيارياً بشكل ميؤوس منه ولا يوجد حقاً سوى طريق واحد قابل للتطبيق من المعنى إلى الرموز: من الألف إلى الياء. لن يتم الوصول إلى مستوى رمزي عائم مثل مستوى برنامج الحاسب أبداً من خلال هذا المسار (أو العكس) - كما أنه ليس من الواضح لماذا يجب علينا محاولة الوصول إلى هذا المستوى، لأنه يبدو كما لو أن الوصول إليه سيكون فقط يصل إلى حد اقتلاع رموزنا من معانيها الجوهرية (وبالتالي مجرد اختزال أنفسنا إلى المكافئ الوظيفي لجهاز الحاسب القابل للبرمجة)."[37]

أبحاث الذكاء العام الاصطناعي الحديثة

تم استخدام مصطلح "الذكاء العام الاصطناعي" في وقت مبكر من عام 1997، من قبل مارك گوبرود[38] في مناقشة الآثار المترتبة على عمليات الإنتاج والعمليات العسكرية المؤتمتة بالكامل. تمت إعادة تقديم المصطلح ونشره من قبل شاين ليگ و بن گورتزل حوالي عام 2002.[39]فهدف البحث أقدم بكثير، على سبيل المثال مشروع دوگ لينات Cyc (الذي بدأ في عام 1984)، ومشروع ألين نيويل سَور يُعتبر المشروع هذا ضمن نطاق الذكاء العام الاصطناعي أيضاً. فقد وصف پي وانگ و بِن گورتزل نشاط بحث AGI في عام 2006[40] باسم "إنتاج المنشورات والنتائج الأولية". تم تنظيم أول مدرسة صيفية في AGI في شيامن، الصين في عام 2009[41] بواسطة مختبر الدماغ الاصطناعي بجامعة شيامن و OpenCog. تم تقديم أول دورة جامعية في عام 2010[42] و2011[43] في جامعة پلوڤديڤ، بلغاريا بواسطة تودور أرناودوڤ. وقد قدم معهد ماساتشوستس للتكنولوجيا دورة في الذكاء الاصطناعي العام في عام 2018، نظمها ليكس فريدمان وشارك فيها عدد من المحاضرين الضيوف. ومع ذلك، لم يكرس معظم باحثي الذكاء الاصطناعي حتى الآن سوى القليل من الاهتمام للذكاء العام الاصطناعي، حيث يزعم البعض أن الذكاء معقد للغاية بحيث لا يمكن تكراره بالكامل على المدى القريب. ومع ذلك، ينشط عدد قليل من علماء الحاسب في أبحاث الذكاء الاصطناعي العام، ويساهم العديد من هذه المجموعة في سلسلة من مؤتمرات الذكاء العام الاصطناعي. البحث متنوع للغاية وغالباً ما يكون رائداً في الطبيعة. في مقدمة كتابه، [44] يقول جورتزل إن تقديرات الوقت اللازم قبل بناء AGI المرن حقًا تختلف من 10 سنوات إلى أكثر من قرن ، ولكن الإجماع في مجتمع أبحاث AGI يبدو أن الجدول الزمني الذي ناقشه راي كورزويل في "التفرد قريب" The Singularity is Near[45] (أي بين عامي 2015 و 2045) أمر معقول.[46]

ومع ذلك، فقد قدم باحثو الذكاء الاصطناعي السائد مجموعة واسعة من الآراء حول ما إذا كان التقدم سيكون بهذه السرعة. وجد التحليل الفائق لعام 2012 لـ 95 رأيًا من هذا القبيل تحيزًا تجاه التنبؤ بأن ظهور الذكاء الاصطناعي العام سيحدث في غضون 16-26 عامًا للتنبؤات الحديثة والتاريخية على حد سواء. وتبين لاحقًا أن مجموعة البيانات أدرجت بعض الخبراء على أنهم غير خبراء والعكس صحيح.[47]

المنظمات التي تسعى صراحة إلى تحقيق الذكاء العام الاصطناعي تشمل مختبر الذكاء الاصطناعي السويسري IDSIA،[48] إنّايسنس،[49] ڤيكاريوس ، مالوبا،[11] مؤسسة OpenCog و الذكاء الاصطناعي التكيفي و ليدا و نيومنتا وما يرتبط بها من معهد ريدوود لعلم الأعصاب.[50] بالإضافة إلى ذلك، فإن المنظمات مثل معهد أبحاث ذكاء الآلة[51] وOpenAI[52] للتأثير على مسار تطوير الذكاء العام الاصطناعي. أخيرًا، مشاريع مثل مشروع الدماغ البشري[53] تهدف إلى بناء محاكاة وظيفية للدماغ البشري. وقد صنف مسح أُجري عام 2017 حول AGI خمسة وأربعين مشروعاً معروفاً من "مشاريع البحث والتطوير النشطة" التي تتضمن بحثًا صريحًا أو ضمنيًا (من خلال الأبحاث المنشورة)، وأكبر ثلاثة منها المخ العميق DeepMind، مشروع الدماغ البشري، و OpenAI.[11]

في عام 2017، أجرى الباحثون فنگ ليو و يونگ شي و ينگ ليو اختبارات ذكاء على الذكاء الاصطناعي الضعيف المتاح للعامة والذي يمكن الوصول إليه مجانًا مثل الذكاء الاصطناعي الخاص بگوگل أو سيري الخاص بآپل وغيرها. كحد أقصى، وصلت هذا الذكاء الاصطناعي إلى معدل ذكاء يبلغ حوالي 47، وهو ما يعادل تقريبًا طفل يبلغ من العمر ست سنوات في الصف الأول. يصل عمر البالغ إلى حوالي 100 في المتوسط. تم إجراء اختبارات مماثلة في عام 2014، حيث وصلت درجة حاصل الذكاء إلى الحد الأقصى لقيمة 27.[54][55]

في عام 2019، أعلن مبرمج ألعاب الفيديو ومهندس الطيران جون كارماك عن خطط لبحث الذكاء الاصطناعي العام.[56]

في عام 2020، قامت OpenAI بتطوير GPT-3، نموذج لغوي قادر على أداء العديد من المهام المتنوعة دون تدريب محدد. وفقًا لگاري گروسمان في مقالة VentureBeat، في حين أن هناك إجماعًا على أن GPT-3 ليس مثالًا على الذكاء الاصطناعي العام، إلا أنه يعتبره البعض متقدمًا جدًا بحيث لا يمكن تصنيفه كنظام ذكاء اصطناعي ضيق.[57]

قوة المعالجة اللازمة لمحاكاة الدماغ

. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

محاكاة الدماغ بالكامل

من الأساليب الشائعة التي نوقشت لتحقيق عمل ذكي عام محاكاة الدماغ بالكامل. يتم بناء نموذج الدماغ منخفض المستوى عن طريق المسح و رسم خرائط الدماغ البيولوجي بالتفصيل ونسخ حالته إلى نظام الحاسب أو جهاز حسابي آخر. يدير الحاسب نموذج محاكاة طبق الأصل بحيث يتصرف بشكل أساسي بنفس الطريقة التي يتصرف بها الدماغ الأصلي، أو لجميع الأغراض العملية، بشكل لا يمكن تمييزه.[58] تمت مناقشة محاكاة الدماغ بالكامل في علم الأعصاب الحسابي و المعلوماتية العصبية، في سياق محاكاة الدماغ لأغراض البحث الطبي. تمت مناقشته في بحث الذكاء الاصطناعي كنهج للذكاء الاصطناعي القوي. حيث تقوم تقنيات التصوير العصبي التي يمكن أن توفر الفهم التفصيلي الضروريبالتحسن السريع، وبحسب ما توقعه المستقبلي راي كورزويل في كتاب التفرد قريب[45]بأن خريطة الجودة الكافية ستصبح متاحة على نطاق زمني مشابه لقوة الحوسبة المطلوبة.

التقديرات الأولية

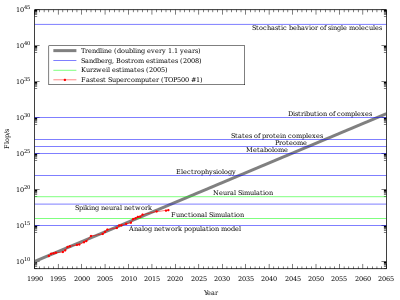

لمحاكاة الدماغ منخفضة المستوى، ستكون هناك حاجة إلى جهاز حاسب قوي للغاية. يحتوي الدماغ البشري على عدد هائل من نقاط الاشتباك العصبي. تحتوي كل من العصبونات 1011 (مائة مليار) في المتوسط 7000 وصلة متشابكة (المشابك) مع الخلايا العصبية الأخرى. تشير التقديرات إلى أن دماغ طفل يبلغ من العمر ثلاث سنوات لديه حوالي 1015 مشبك عصبي (1 كوادريليون). يتناقص هذا الرقم مع تقدم العمر، ويستقر عند البلوغ. تختلف التقديرات بالنسبة إلى شخص بالغ، حيث تتراوح من 1014 إلى 5×1014 (100 إلى 500 تريليون).[60] تقدير قوة معالجة الدماغ، استنادًا إلى نموذج التبديل البسيط لنشاط الخلايا العصبية، هو حوالي 1014 (100 تريليون) تحديث متشابك في الثانية (SUPS).[61] في عام 1997، نظر كورزويل في تقديرات مختلفة للأجهزة المطلوبة لتساوي الدماغ البشري واتخذ رقم 1016 حساباً في الثانية (cps).[62] (للمقارنة، إذا كان "الحساب" معادلاً لـ " عملية الفاصلة العائمة" - مقياس يستخدم لتقييم الحاسب الفائق - إذن 1016 "حساب "سيكون مكافئًا لـ 10 petaFLOPS، تم تحقيقه في 2011). استخدم هذا الرقم للتنبؤ بأن الأجهزة اللازمة ستكون متاحة في وقت ما بين 2015 و 2025، إذا استمر النمو الأسي في قوة الحاسب في وقت كتابة هذا التقرير.

نمذجة الخلايا العصبية بمزيد من التفصيل

إن نموذج الخلايا العصبية الاصطناعية الذي افترضه كورزويل والمستخدم في العديد من تطبيقات الشبكة العصبية الاصطناعية الحالية بسيط مقارنةً بـ الخلايا العصبية البيولوجية. من المحتمل أن تقوم محاكاة الدماغ بالتقاط السلوك الخلوي المفصل لـ العصبونات البيولوجية ، والمفهومة حاليًا فقط في أوسع الخطوط العريضة. تتطلب النفقات العامة التي أدخلتها النمذجة الكاملة للتفاصيل البيولوجية والكيميائية والفيزيائية للسلوك العصبي (خاصة على المستوى الجزيئي) قوى حسابية عدة مرات أكبر من تقدير كورزويل. بالإضافة إلى ذلك، لا تأخذ تقديرات الخلايا الدبقية في الحسبان، والتي هي على الأقل بعدد الخلايا العصبية، والتي قد تفوق عدد الخلايا العصبية بنسبة تصل إلى 10: 1، ومن المعروف الآن أنها تلعب دوراً في العمليات الإدراكية.[63]

البحث الحالي

هناك بعض المشاريع البحثية التي تبحث في محاكاة الدماغ باستخدام نماذج عصبية أكثر تعقيدًا، يتم تنفيذها على بنيات الحوسبة التقليدية. نفذ مشروع نظام الذكاء الاصطناعي عمليات محاكاة غير حقيقية لـ "الدماغ" (مع 1011 خلية عصبية) في عام 2005. استغرق الأمر 50 يومًا على مجموعة من 27 معالجًا لمحاكاة ثانية واحدة من النموذج.[64]استخدم مشروع Blue Brain واحدة من أسرع بنى الحواسيب العملاقة في العالم، منصة Blue Gene التابعة لIBM، لإنشاء محاكاة في الوقت الفعلي ل عمود القشرة الحديثة لفأر واحد تتكون من حوالي 10000 خلية عصبية و 10 نقاط تشابك عصبية 108 في عام 2006.[65]الهدف طويل المدى هو بناء محاكاة وظيفية مفصلة للعمليات الفيزيولوجية في الدماغ البشري: "ليس من المستحيل بناء دماغ بشري ويمكننا القيام بذلك في 10 سنوات"، هذا ما قاله هنري ماركرام، مدير من مشروع Blue Brain في عام 2009 في مؤتمر TED في أكسفورد.[66] كانت هناك أيضاً ادعاءات مثيرة للجدل بمحاكاة دماغ القط. تم اقتراح واجهات السيليكون العصبي كإستراتيجية تنفيذ بديلة قد تتوسع بشكل أفضل.[67]

تناول هانز موراڤك البراهين المذكورة أعلاه ("الأدمغة أكثر تعقيدًا"، "يجب تصميم الخلايا العصبية بمزيد من التفصيل") في بحثه عام 1997 "متى تتطابق أجهزة الحاسب مع الدماغ البشري؟".[68]وقام بقياس قدرة البرامج الموجودة على محاكاة وظائف الأنسجة العصبية، وخاصة شبكية العين. لا تعتمد نتائجه على عدد الخلايا الدبقية، ولا على أي نوع من الخلايا العصبية التي تؤدي دورها.

تم استكشاف التعقيد الفعلي لنمذجة الخلايا العصبية البيولوجية في OpenWorm Project الذي كان يهدف إلى محاكاة كاملة لدودة تحتوي على 302 خلية عصبية فقط في شبكتها العصبية (من بين حوالي 1000 خلية في المجموع). تم توثيق الشبكة العصبية للحيوان جيدًا قبل بدء المشروع. ومع ذلك، على الرغم من أن المهمة بدت بسيطة في البداية، إلا أن النماذج القائمة على شبكة عصبية عامة لم تنجح. تركز الجهود حاليًا على المحاكاة الدقيقة للخلايا العصبية البيولوجية (جزئيًا على المستوى الجزيئي)، ولكن لا يمكن اعتبار النتيجة نجاحًا تامًا حتى الآن. حتى إذا كان عدد المشكلات التي يتعين حلها في نموذج مقياس الدماغ البشري لا يتناسب مع عدد الخلايا العصبية، فإن مقدار العمل على طول هذا المسار واضح.

انتقادات للنهج القائم على المحاكاة

يُشتق النقد الأساسي لنهج محاكاة الدماغ من الإدراك المتجسد حيث يتم أخذ التجسيد البشري باعتباره جانباً أساسياً من جوانب الذكاء البشري. يعتقد العديد من الباحثين أن التجسيد ضروري لتأسيس المعنى.[69] إذا كان هذا الرأي صحيحاً، فإن أي نموذج دماغي يعمل بكامل طاقته سيحتاج إلى أكثر من مجرد الخلايا العصبية(عصبونات) (أي الجسم الآلي).[46] يقترح گورتزل تجسيداً افتراضياً (كما هو الحال في الحياة الثانية)، لكن لم يُعرف بعد ما إذا كان هذا سيكون كافيًا.

أجهزة الحاسب سطح المكتب التي تستخدم معالجات دقيقة قادرة على أكثر من 109 cps (وحدة كورزويل غير القياسية "حساب في الثانية"، انظر أعلاه) متوفرة منذ عام 2005. وفقاً لتقديرات قوة الدماغ التي استخدمها كورزويل (و موراڤك)، يجب أن يكون هذا الحاسب قادراً على دعم محاكاة لدماغ النحل، ولكن على الرغم من بعض الاهتمام[70] لا توجد مثل هذه المحاكاة[بحاجة لمصدر]. هناك على الاقل ثلاثة أسباب لحدوث ذلك:

- يبدو أن نموذج الخلايا العصبية مفرط في التبسيط (انظر القسم التالي).

- لا يوجد فهم كافٍ للعمليات الإدراكية الأعلى[71] لتحديد ما يرتبط به النشاط العصبي للدماغ، الذي يتم ملاحظته باستخدام تقنيات مثل التصوير بالرنين المغناطيسي الوظيفي.

- حتى لو تقدم فهمنا للإدراك بشكل كافٍ، فمن المحتمل أن تكون برامج المحاكاة المبكرة غير فعالة للغاية، وبالتالي ، ستحتاج إلى المزيد من الأجهزة بشكل كبير.

- قد لا يكون دماغ الكائن الحي، على الرغم من أهميته، حدودًا مناسبة للنموذج المعرفي. لمحاكاة دماغ النحل ، قد يكون من الضروري محاكاة الجسم والبيئة. تضفي أطروحة العقل الموسع طابعاً رسمياً على المفهوم الفلسفي، وقد أظهر البحث في رأسيات الأرجل أمثلة واضحة للنظام اللامركزي.[72]

بالإضافة إلى ذلك، فإن حجم الدماغ البشري ليس مقيداً جيداً حالياً. أحد التقديرات يضع الدماغ البشري عند حوالي 100 مليار خلية عصبية و 100 تريليون نقطة الاشتباك العصبي.[73][74] تقدير آخر هو 86 مليار خلية عصبية، منها 16.3 مليار في القشرة المخية و 69 مليارًا في المخيخ.[75] أما المشابك العصبية للخلية الدبقية فهي غير محددة الكمية حالياً ولكن من المعروف أنها عديدة للغاية.

الذكاء الاصطناعي القوي والإدراك

في عام 1980، صاغ الفيلسوف جون سيرل مصطلح "الذكاء الاصطناعي القوي" كجزء من برهانه غرفة صينية.[76]أراد التمييز بين فرضيتين مختلفتين حول الذكاء الاصطناعي:[77]

- يمكن لنظام الذكاء الاصطناعي أن يفكر ويكون له عقل. (لكلمة "عقل" معنى محدد للفلاسفة، كما تستخدم في "مسألة العقل والجسد" أو "فلسفة العقل".)

- يمكن لنظام الذكاء الاصطناعي (فقط) أن يتصرف كما أنه يفكر ولديه عقل.

الأولى تسمى فرضية الذكاء الاصطناعي القوية والثانية هي فرضية الذكاء الاصطناعي الضعيفة لأن الأولى تجعل العبارة أقوى: تفترض أن شيئاً خاصاً قد حدث لـ آلة تتجاوز كل قدراتها التي يمكننا اختبارها. أشار سيرل إلى "فرضية الذكاء الاصطناعي القوية" على أنها "ذكاء اصطناعي قوي". هذا الاستخدام شائع أيضًا في أبحاث الذكاء الاصطناعي والكتب الأكاديمية.[78]

إن فرضية الذكاء الاصطناعي الضعيفة تعادل الفرضية القائلة بأن الذكاء الاصطناعي العام ممكن. وفقًا لـ راسل و نورڤگ ، "يعتبر معظم الباحثين في الذكاء الاصطناعي فرضية الذكاء الاصطناعي الضعيفة أمراً مفروغاً منه، ولا يهتمون بفرضية الذكاء الاصطناعي القوية."[79]

على عكس سيرل، يستخدم راي كورزويل مصطلح "الذكاء الاصطناعي القوي" لوصف أي نظام ذكاء اصطناعي يعمل كما لو كان لديه عقل،[45] بغض النظر عما إذا كان الفيلسوف قادرًا على تحديد ما إذا كان لديه عقل أم لا. في الخيال العلمي، يرتبط الذكاء الاصطناعي العام بسمات مثل الإدراك و الإحساس و العقل و الوعي الذاتي التي لوحظت في الكائنات الحية. ومع ذلك، وفقًا لسيرل، فإنه سؤال مفتوح عما إذا كان الذكاء العام كافياً للوعي. يجب عدم الخلط بين "الذكاء الاصطناعي القوي" (على النحو المحدد أعلاه من قبل كورزويل) وبين "فرضية الذكاء الاصطناعي القوية لسيرل". الفرضية القوية للذكاء الاصطناعي هي الادعاء بأن الحاسب الذي يتصرف بذكاء مثل الشخص يجب أن يكون بالضرورة لديه عقل و وعي. يشير الذكاء الاصطناعي العام فقط إلى مقدار الذكاء الذي تعرضه الآلة، بعقل أو بدونه.

الإدراك

هناك جوانب أخرى للعقل البشري إلى جانب الذكاء ذات صلة بمفهوم الذكاء الاصطناعي القوي والتي تلعب دورًا رئيسيًا في الخيال العلمي و أخلاقيات الذكاء الاصطناعي:

- الإدراك: أن يكون لديك تجربة ذاتية و فكر.[80]

- الوعي الذاتي: أن يكون المرء مدركًا لنفسه كفرد منفصل، خاصةً ليكون مدركًا لأفكاره.

- الإحساس: القدرة على "الشعور" بالإدراكات أو العواطف بشكل شخصي.

- لتعقل: القدرة على الحكمة.

هذه السمات لها بُعد أخلاقي، لأن الآلة التي تمتلك هذا الشكل من الذكاء الاصطناعي القوي قد يكون لها حقوق مماثلة لـ حقوق الحيوانات غير البشرية. على هذا النحو، تم إجراء عمل تمهيدي على مناهج دمج العوامل الأخلاقية الكاملة مع الأطر القانونية والاجتماعية القائمة. ركزت هذه الأساليب على الوضع القانوني وحقوق الذكاء الاصطناعي "القوي".[81]

ومع ذلك، يرى بيل جوي، من بين آخرين، أن الآلة التي تحمل هذه السمات قد تشكل تهديداً لحياة الإنسان أو كرامته.[82] يبقى أن نوضح ما إذا كانت أي من هذه السمات ضرورية للذكاء الاصطناعي القوي. فدور الإدراك غير واضح، ولا يوجد حاليًا اختبار متفق عليه لوجوده. إذا تم بناء آلة بجهاز يحاكي الارتباطات العصبية للوعي، فهل سيكون لديها وعي ذاتي تلقائيًا؟ من الممكن أيضًا أن تكون بعض هذه الخصائص، مثل الإحساس، الظهور بشكل طبيعي من آلة ذكية تمامًا، أو أنه يصبح من الطبيعي إسناد هذه الخصائص للآلات بمجرد أن تبدأ في التصرف في بطريقة ذكية بشكل واضح. على سبيل المثال، قد يكون الفعل الذكي كافيًا للإحساس، وليس العكس.

. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

بحوث الإدراك الاصطناعي

على الرغم من أن دور الوعي في الذكاء الاصطناعي / الذكاء الاصطناعي القوي أمر قابل للنقاش، إلا أن العديد من باحثي AGI [83] يعتبرون البحث الذي يبحث في إمكانيات تطبيق الوعي أمراً حيوياً. في محاولة أولية ناقش إيگور ألكسندر[84] بأن مبادئ إنشاء آلة واعية موجودة بالفعل ولكن الأمر سيستغرق أربعين عامًا لتدريب مثل هذه الآلة على فهم اللغة.

التفسيرات المحتملة للتقدم البطيء لأبحاث الذكاء الاصطناعي

منذ إطلاق أبحاث الذكاء الاصطناعي في عام 1956، تباطأ نمو هذا المجال بمرور الوقت وأوقف أهداف إنشاء آلات ماهرة في العمل الذكي على المستوى البشري. [85]تفسير محتمل لهذا التأخير هو أن أجهزة الحاسب تفتقر إلى النطاق الكافي للذاكرة أو قوة المعالجة.[85] بالإضافة إلى ذلك، قد يحد مستوى التعقيد المرتبط بعملية أبحاث الذكاء الاصطناعي من تقدم أبحاث الذكاء الاصطناعي.[85]

بينما يعتقد معظم باحثي الذكاء الاصطناعي أنه يمكن تحقيق ذكاء اصطناعي قوي في المستقبل، هناك بعض الأفراد مثل هيوبرت دريفوس و رودجر پنروز الذين ينكرون إمكانية تحقيق ذكاء اصطناعي قوي.[85] كان جون مكارثي واحداً من العديد من علماء الحاسب الذين يعتقدون أن الذكاء الاصطناعي على المستوى البشري سيتم إنجازه، ولكن لا يمكن التنبؤ بدقة بموعده.[86]

القيود المفاهيمية هي سبب آخر محتمل للبطء في أبحاث الذكاء الاصطناعي.[85] قد يحتاج باحثو الذكاء الاصطناعي إلى تعديل الإطار المفاهيمي لتخصصهم من أجل توفير قاعدة أقوى ومساهمة في السعي لتحقيق ذكاء اصطناعي قوي. كما كتب وليام كلوكسن في عام 2003: "يبدأ إطار العمل من ملاحظة وزنبوم بأن الذكاء يظهر فقط بالنسبة إلى سياقات اجتماعية وثقافية محددة".[85]

علاوة على ذلك، تمكن باحثو الذكاء الاصطناعي من إنشاء أجهزة حاسب يمكنها أداء وظائف معقدة على الأشخاص القيام بها، مثل الرياضيات، لكنهم على العكس من ذلك كافحوا لتطوير جهاز حاسب قادر على تنفيذ المهام التي يسهل على البشر القيام بها، مثل المشي (مفارقة موراڤك).[85] هناك مشكلة وصفها ديڤد گيليرنتر وهي أن بعض الأشخاص يفترضون أن التفكير والمنطق متكافئان.[87] ومع ذلك، فإن فكرة ما إذا كانت الأفكار ومنشئ هذه الأفكار معزولة بشكل فردي قد أثارت اهتمام الباحثين في مجال الذكاء الاصطناعي.[87]

أدت المشكلات التي تمت مواجهتها في أبحاث الذكاء الاصطناعي على مدار العقود الماضية إلى إعاقة تقدم الذكاء الاصطناعي. فقد ساعدت التوقعات الفاشلة التي وعد بها باحثو الذكاء الاصطناعي والافتقار إلى الفهم الكامل للسلوكيات البشرية في تقليص الفكرة الأساسية للذكاء الاصطناعي على المستوى البشري. [46] على الرغم من أن التقدم المحرز في أبحاث الذكاء الاصطناعي قد جلب التحسن وخيبة الأمل، فقد توصل معظم الباحثين إلى تفاؤل بشأن إمكانية تحقيق هدف الذكاء الاصطناعي في القرن الحادي والعشرين.[46]

تم اقتراح أسباب أخرى محتملة للبحث المطول في تقدم الذكاء الاصطناعي القوي. إن تعقيد المشكلات العلمية والحاجة إلى فهم كامل للدماغ البشري من خلال علم النفس وعلم وظائف الأعضاء العصبية قد حد من قدرة العديد من الباحثين على محاكاة وظيفة الدماغ البشري في أجهزة الحاسب.[88] يميل العديد من الباحثين إلى التقليل من شأن أي شك يتضمن التنبؤات المستقبلية للذكاء الاصطناعي، ولكن بدون أخذ هذه المشكلات على محمل الجد، يمكن للأشخاص التغاضي عن حلول الأسئلة الإشكالية. [46]

يقول كلوكسن أن القيد المفاهيمي الذي قد يعيق تقدم أبحاث الذكاء الاصطناعي هو أن الناس ربما يستخدمون تقنيات خاطئة لبرامج الحاسب وتنفيذ المعدات.[85] عندما بدأ باحثو الذكاء الاصطناعي لأول مرة في السعي لتحقيق الهدف للذكاء الاصطناعي، كان المنطق البشري أحد الاهتمامات الرئيسية. [89] كان الباحثون يأملون في إنشاء نماذج حسابية للمعرفة البشرية من خلال التفكير ومعرفة كيفية تصميم جهاز حاسب بمهمة معرفية محددة.[89]

تزود ممارسة التجريد، التي يميل الناس إلى إعادة تعريفها عند العمل مع سياق معين في البحث، الباحثين بالتركيز على بعض المفاهيم فقط. [89] الاستخدام الأكثر إنتاجية للتجريد في أبحاث الذكاء الاصطناعي يأتي من التخطيط وحل المشكلات. [89] على الرغم من أن الهدف هو زيادة سرعة الحساب، فقد طرح دور التجريد أسئلة حول مشاركة عوامل التجريد. [90]

يتعلق أحد الأسباب المحتملة للبطء في الذكاء الاصطناعي باعتراف العديد من باحثي الذكاء الاصطناعي بأن الاستدلال عبارة عن قسم يحتوي على خرق كبير بين أداء الكمبيوتر والأداء البشري.[88] الوظائف المحددة التي تمت برمجتها إلى قد يكون الحاسب قادرًا على حساب العديد من المتطلبات التي تسمح له بمطابقة الذكاء البشري. لا يُضمن بالضرورة أن تكون هذه التفسيرات هي الأسباب الأساسية للتأخير في تحقيق ذكاء اصطناعي قوي، ولكن تم الاتفاق عليها على نطاق واسع من قبل العديد من الباحثين.

كان هناك العديد من باحثي الذكاء الاصطناعي الذين يناقشون فكرة ما إذا كان يجب إنشاء الآلات بالعواطف فلا توجد مشاعر في النماذج القياسية للذكاء الاصطناعي ويقول بعض الباحثين إن برمجة المشاعر في آلات تتيح لهم امتلاك عقل خاص بهم. [85] تلخص المشاعر تجارب البشر لأنها تتيح لهم تذكر تلك الخبرات. [87] كتب ديڤد گيليرتنر، "لن يكون الحاسب مبدعاً ما لم يتمكن من محاكاة جميع الفروق الدقيقة في المشاعر البشرية." [87] تسبب هذا القلق بشأن العاطفة في حدوث مشكلات لـ باحثو الذكاء الاصطناعي ويرتبط بمفهوم الذكاء الاصطناعي القوي مع تقدم أبحاثه في المستقبل.[91]

الخلافات والمخاطر

قابلية التنفيذ

This section requires expansion. (February 2016) |

اعتباراً من أغسطس 2020، لا يزال الذكاء الاصطناعي العام تخمينياً[8][92]حيث لم يتم عرض مثل هذا النظام حتى الآن. تختلف الآراء حول ما إذا كان و متى سيصل الذكاء العام الاصطناعي بشكل تام. من ناحية أخرى، تكهن رائد الذكاء الاصطناعي هربرت أ. سيمون في عام 1965: "ستكون الآلات قادرة، في غضون عشرين عامًا، على القيام بأي عمل يمكن للإنسان القيام به". ومع ذلك، فشل هذا التوقع في أن يتحقق. يعتقد الشريك المؤسس لشركة مايكروسوفت پول ألين أن مثل هذا الذكاء غير مرجح في القرن الحادي والعشرين لأنه سيتطلب "اختراقات غير متوقعة وغير قابلة للتنبؤ أساسًا" و "فهمًا علميًا عميقًا للإدراك".[93] كما ورد كتابةً في الگارديان، ادعى عالم الروبوتات آلان وينفيلد أن الفجوة بين الحوسبة الحديثة والذكاء الاصطناعي على مستوى الإنسان واسعة مثل الفجوة بين رحلة الفضاء الحالية ورحلات الفضاء العملية الأسرع من الضوء.[94]

تلاشت آراء خبراء الذكاء الاصطناعي حول جدوى استخدام نمو الذكاء العام الاصطناعي، وربما شهدت انتعاشاً في العقد الأول من القرن الحادي والعشرين. أشارت أربعة استطلاعات للرأي أجريت في عامي 2012 و 2013 إلى أن متوسط التخمين بين الخبراء بشأن الوقت الذي سيكونون فيه واثقين بنسبة 50٪ من وصول الذكاء الاصطناعي العام كان 2040 إلى 2050، اعتمادًا على الاستطلاع، بمتوسط 2081. من الخبراء، أجاب 16.5٪ بـ أبداً "عند طرح نفس السؤال ولكن بثقة 90٪ بدلاً من ذلك.[95][96] يمكن العثور على مزيد من اعتبارات تقدم AGI الحالية أدناه اختبارات لتأكيد المستوى البشري AGI و اختبارات الذكاء AGI.

تهديد محتمل للوجود البشري

فرضية أن الذكاء الاصطناعي يشكل خطراً وجودياً، وأن هذا الخطر يحتاج إلى اهتمام أكبر بكثير مما يحصل عليه حالياً، وقد أيدته العديد من الشخصيات العامة؛ ربما أشهرهم إيلن مَسك و بيل گيتس و ستيڤن هوكينگ. كان أبرز باحث في الذكاء الاصطناعي قد صادَق على هذه الأطروحة هو ستيوارت ج. راسل. يعبر مؤيدو الأطروحة أحياناً عن حيرة من المتشككين: يقول گيتس إنه لا "يفهم سبب عدم اهتمام بعض الناس"،[97] وانتقد هوكينج اللامبالاة الواسعة الانتشار في افتتاحيته لعام 2014:

لذا، في مواجهة مستقبل محتمل بفوائد ومخاطر لا تُحصى، يبذل الخبراء كل ما في وسعهم بشكل تام لضمان أفضل النتائج، أليس كذلك؟ خطأ. إذا أرسلت لنا حضارة فضائيّة متفوقة رسالة تقول ، "سنصل خلال بضعة عقود"، فهل نردّ فقط، "حسناً، اتصل بنا عندما تصل إلى هنا – سنترك الأضواء مضاءة؟ ربما لا – ولكن هذا ما يحدث تقريباً مع الذكاء الاصطناعي.'[98]

يعتقد العديد من العلماء المهتمين بالمخاطر الوجودية أن أفضل طريقة للمضي قدماً هي إجراء بحث (ربما يكون ضخمًا) لحل المشكلة الصعبة " مشكلة التحكم" للإجابة على السؤال: ما أنواع الضمانات أو الخوارزميات أو البنى التي يمكن للمبرمجين تنفيذها لزيادة احتمالية استمرار الذكاء الاصطناعي الذي يتحسن بشكل متكرر في التصرف بطريقة ودية وليست مدمرة بعد وصوله إلى الذكاء الخارق؟[99][100]

الأطروحة القائلة بأن الذكاء الاصطناعي يمكن أن يشكل خطراً وجودياً لها أيضًا العديد من الانتقادات القوية. يتهم المشككون أحيانًا بأن الأطروحة دينية مشفرة، مع وجود إيمان غير منطقي بإمكانية الذكاء الخارق ليحل محل الاعتقاد غير العقلاني بإله كلي القدرة؛ في أقصى الحدود، يجادل جارون لانييه بأن المفهوم الكامل بأن الآلات الحالية ذكية بأي شكل من الأشكال هو "وهم" و "خدعة كبيرة" من قبل الأثرياء.[101]

يرى الكثير من الانتقادات الحالية أن الذكاء الاصطناعي العام غير محتمل على المدى القصير. يجادل عالم الحاسب گوردون بيل بأن الجنس البشري سيدمر نفسه بالفعل قبل أن يصل إلى التفرد التكنولوجي. وقد أعلن گوردون مور، المؤيد المبتكر لـ قانون مور، "أنا متشكك. لا أعتقد أن [التفرد التكنولوجي] من المحتمل أن يحدث، على الأقل لفترة طويلة. وأنا لا أعرف لماذا أشعر بهذه الطريقة."[102]يقول نائب رئيس بايدو أندرو نگ إن الخطر الوجودي للذكاء الاصطناعي "يشبه القلق بشأن الزيادة السكانية على سطح المريخ عندما لم تطأ أقدامنا الكوكب حتى الآن."[103]

انظر أيضاً

- Artificial brain

- AI control problem

- Automated machine learning

- BRAIN Initiative

- China Brain Project

- Eliezer Yudkowsky

- Future of Humanity Institute

- General game playing

- Human Brain Project

- Intelligence amplification (IA), the use of information technology in augmenting human intelligence instead of creating an external autonomous "AGI"

- Machine ethics

- Multi-task learning

- Nick Bostrom

- Outline of artificial intelligence

- Outline of transhumanism

- Superintelligence

- Synthetic intelligence

- Transfer learning

ملاحظات

- ^ Hodson, Hal (1 March 2019). "DeepMind and Google: the battle to control artificial intelligence". 1843. Retrieved 7 July 2020.

AGI stands for Artificial General Intelligence, a hypothetical computer program...

- ^ Kurzweil, Singularity (2005) p. 260

- ^ أ ب Kurzweil, Ray (5 August 2005), "Long Live AI", Forbes, https://www.forbes.com/home/free_forbes/2005/0815/030.htmlhttps://www.forbes.com/home/free_forbes/2005/0815/030.html: Kurzweil describes strong AI as "machine intelligence with the full range of human intelligence."

- ^ Treder, Mike (10 August 2005), Advanced Human ntelligence, https://crnano.typepad.com/crnblog/2005/08/advanced_human_.html

- ^ "The Age of Artificial Intelligence: George John at TEDxLondonBusinessSchool 2013". Archived from the original on 26 February 2014. Retrieved 22 February 2014.

- ^ Newell & Simon 1976.

- ^ Searle 1980.

- ^ أ ب europarl.europa.eu: How artificial intelligence works, "Concluding remarks: Today's AI is powerful and useful, but remains far from speculated AGI or ASI.", European Parliamentary Research Service, retrieved March 3, 2020

- ^ Grace, Katja; Salvatier, John; Dafoe, Allan; Zhang, Baobao; Evans, Owain (2018-07-31). "Viewpoint: When Will AI Exceed Human Performance? Evidence from AI Experts". Journal of Artificial Intelligence Research. 62: 729–754. doi:10.1613/jair.1.11222. ISSN 1076-9757.

- ^ "The Open University on Strong and Weak AI". Archived from the original on 25 September 2009. Retrieved 8 October 2007.

- ^ أ ب ت Baum, Seth (12 November 2017). "Baum, Seth, A Survey of Artificial General Intelligence Projects for Ethics, Risk, and Policy (November 12, 2017). Global Catastrophic Risk Institute Working Paper 17-1".

{{cite journal}}: Cite journal requires|journal=(help) - ^ AI founder John McCarthy writes: "we cannot yet characterize in general what kinds of computational procedures we want to call intelligent." McCarthy, John (2007). "Basic Questions". Stanford University. Archived from the original on 26 October 2007. Retrieved 6 December 2007. (For a discussion of some definitions of intelligence used by artificial intelligence researchers, see philosophy of artificial intelligence.)

- ^ This list of intelligent traits is based on the topics covered by major AI textbooks, including: Russell & Norvig 2003, Luger & Stubblefield 2004, Poole, Mackworth & Goebel 1998 and Nilsson 1998.

- ^ Pfeifer, R. and Bongard J. C., How the body shapes the way we think: a new view of intelligence (The MIT Press, 2007). ISBN 0-262-16239-3

- ^ White, R. W. (1959). "Motivation reconsidered: The concept of competence". Psychological Review. 66 (5): 297–333. doi:10.1037/h0040934. PMID 13844397.

- ^ Johnson 1987

- ^ deCharms, R. (1968). Personal causation. New York: Academic Press.

- ^ Muehlhauser, Luke (11 August 2013). "What is AGI?". Machine Intelligence Research Institute. Archived from the original on 25 April 2014. Retrieved 1 May 2014.

- ^ "What is Artificial General Intelligence (AGI)? | 4 Tests For Ensuring Artificial General Intelligence". Talky Blog (in الإنجليزية الأمريكية). 13 July 2019. Archived from the original on 17 July 2019. Retrieved 17 July 2019.

- ^ Shapiro, Stuart C. (1992). Artificial Intelligence Archived 1 فبراير 2016 at the Wayback Machine In Stuart C. Shapiro (Ed.), Encyclopedia of Artificial Intelligence (Second Edition, pp. 54–57). New York: John Wiley. (Section 4 is on "AI-Complete Tasks".)

- ^ Roman V. Yampolskiy. Turing Test as a Defining Feature of AI-Completeness. In Artificial Intelligence, Evolutionary Computation and Metaheuristics (AIECM) --In the footsteps of Alan Turing. Xin-She Yang (Ed.). pp. 3–17. (Chapter 1). Springer, London. 2013. http://cecs.louisville.edu/ry/TuringTestasaDefiningFeature04270003.pdf Archived 22 مايو 2013 at the Wayback Machine

- ^ Luis von Ahn, Manuel Blum, Nicholas Hopper, and John Langford. CAPTCHA: Using Hard AI Problems for Security Archived 4 مارس 2016 at the Wayback Machine. In Proceedings of Eurocrypt, Vol. 2656 (2003), pp. 294–311.

- ^ Bergmair, Richard (7 January 2006). "Natural Language Steganography and an "AI-complete" Security Primitive". CiteSeerX 10.1.1.105.129.

{{cite journal}}: Cite journal requires|journal=(help) (unpublished?) - ^ Crevier 1993, pp. 48–50

- ^ Simon 1965, p. 96 quoted in Crevier 1993, p. 109

- ^ "Scientist on the Set: An Interview with Marvin Minsky". Archived from the original on 16 July 2012. Retrieved 5 April 2008.

- ^ Marvin Minsky to Darrach (1970), quoted in Crevier (1993, p. 109).

- ^ The Lighthill report specifically criticized AI's "grandiose objectives" and led the dismantling of AI research in England. (Lighthill 1973; Howe 1994) In the U.S., DARPA became determined to fund only "mission-oriented direct research, rather than basic undirected research". See (NRC 1999) under "Shift to Applied Research Increases Investment". See also (Crevier 1993, pp. 115–117) and (Russell & Norvig 2003, pp. 21–22)

- ^ Crevier 1993, p. 211, Russell & Norvig 2003, p. 24 and see also Feigenbaum & McCorduck 1983

- ^ Crevier 1993, pp. 161–162,197–203,240; Russell & Norvig 2003, p. 25; NRC 1999, under "Shift to Applied Research Increases Investment"

- ^ Crevier 1993, pp. 209–212

- ^ As AI founder John McCarthy writes "it would be a great relief to the rest of the workers in AI if the inventors of new general formalisms would express their hopes in a more guarded form than has sometimes been the case." McCarthy, John (2000). "Reply to Lighthill". Stanford University. Archived from the original on 30 September 2008. Retrieved 29 September 2007.

- ^ "At its low point, some computer scientists and software engineers avoided the term artificial intelligence for fear of being viewed as wild-eyed dreamers."Markoff, John (14 October 2005). "Behind Artificial Intelligence, a Squadron of Bright Real People". The New York Times.

- ^ Russell & Norvig 2003, pp. 25–26

- ^ "Trends in the Emerging Tech Hype Cycle". Gartner Reports. Archived from the original on 22 May 2019. Retrieved 7 May 2019.

- ^ Moravec 1988, p. 20

- ^ Harnad, S (1990). "The Symbol Grounding Problem". Physica D. 42 (1–3): 335–346. arXiv:cs/9906002. Bibcode:1990PhyD...42..335H. doi:10.1016/0167-2789(90)90087-6.

- ^ Gubrud 1997

- ^ "Who coined the term "AGI"? » goertzel.org" (in الإنجليزية الأمريكية). Archived from the original on 28 December 2018. Retrieved 28 December 2018., via Life 3.0: 'The term "AGI" was popularized by... Shane Legg, Mark Gubrud and Ben Goertzel'

- ^ Goertzel & Wang 2006. See also Wang (2006) with an up-to-date summary and lots of links.

- ^ https://goertzel.org/AGI_Summer_School_2009.htm

- ^ http://fmi-plovdiv.org/index.jsp?id=1054&ln=1

- ^ http://fmi.uni-plovdiv.bg/index.jsp?id=1139&ln=1

- ^ Goertzel & Pennachin 2006.

- ^ أ ب ت (Kurzweil 2005, p. 260) harv error: multiple targets (2×): CITEREFKurzweil2005 (help) or see Advanced Human Intelligence Archived 30 يونيو 2011 at the Wayback Machine where he defines strong AI as "machine intelligence with the full range of human intelligence."

- ^ أ ب ت ث ج Goertzel 2007.

- ^ "Error in Armstrong and Sotala 2012". AI Impacts. 2016. Retrieved 2020-08-24.

- ^ "Intelligent machines that learn unaided" (PDF). Ticino Ricerca. 2004. Retrieved 2020-08-24.

- ^ Markoff, John (27 November 2016). "When A.I. Matures, It May Call Jürgen Schmidhuber 'Dad'". The New York Times. Archived from the original on 26 December 2017. Retrieved 26 December 2017.

- ^ James Barrat (2013). "Chapter 11: A Hard Takeoff". Our Final Invention: Artificial Intelligence and the End of the Human Era (First ed.). New York: St. Martin's Press. ISBN 9780312622374.

- ^ "About the Machine Intelligence Research Institute". Machine Intelligence Research Institute. Archived from the original on 21 January 2018. Retrieved 26 December 2017.

- ^ "About OpenAI". OpenAI (in الإنجليزية الأمريكية). Archived from the original on 22 December 2017. Retrieved 26 December 2017.

- ^ Theil, Stefan. "Trouble in Mind". Scientific American (in الإنجليزية). pp. 36–42. Bibcode:2015SciAm.313d..36T. doi:10.1038/scientificamerican1015-36. Archived from the original on 9 November 2017. Retrieved 26 December 2017.

- ^ Liu, Feng; Shi, Yong; Liu, Ying (2017). "Intelligence Quotient and Intelligence Grade of Artificial Intelligence". Annals of Data Science. 4 (2): 179–191. arXiv:1709.10242. Bibcode:2017arXiv170910242L. doi:10.1007/s40745-017-0109-0. S2CID 37900130.

- ^ "Google-KI doppelt so schlau wie Siri". Archived from the original on 3 January 2019. Retrieved 2 January 2019.

- ^ Lawler, Richard (November 13, 2019). "John Carmack takes a step back at Oculus to work on human-like AI". Engadget. Retrieved April 4, 2020.

- ^ Grossman, Gary (September 3, 2020). "We're entering the AI twilight zone between narrow and general AI". VentureBeat. Retrieved September 5, 2020.

Certainly, too, there are those who claim we are already seeing an early example of an AGI system in the recently announced GPT-3 natural language processing (NLP) neural network. ... So is GPT-3 the first example of an AGI system? This is debatable, but the consensus is that it is not AGI. ... If nothing else, GPT-3 tells us there is a middle ground between narrow and general AI.

- ^ Sandberg & Boström 2008. "The basic idea is to take a particular brain, scan its structure in detail, and construct a software model of it that is so faithful to the original that, when run on appropriate hardware, it will behave in essentially the same way as the original brain."

- ^ Sandberg & Boström 2008.

- ^ Drachman 2005.

- ^ Russell & Norvig 2003.

- ^ In "Mind Children" Moravec 1988 1015 cps is used. More recently, in 1997, <"Archived copy". Archived from the original on 15 June 2006. Retrieved 23 June 2006.

{{cite web}}: CS1 maint: archived copy as title (link)> Moravec argued for 108 MIPS which would roughly correspond to 1014 cps. Moravec talks in terms of MIPS, not "cps", which is a non-standard term Kurzweil introduced. - ^ Swaminathan, Nikhil (Jan–Feb 2011). "Glia—the other brain cells". Discover. Archived from the original on 8 February 2014. Retrieved 24 January 2014.

- ^ Izhikevich, Eugene M.; Edelman, Gerald M. (4 March 2008). "Large-scale model of mammalian thalamocortical systems" (PDF). PNAS. 105 (9): 3593–3598. Bibcode:2008PNAS..105.3593I. doi:10.1073/pnas.0712231105. PMC 2265160. PMID 18292226. Archived from the original (PDF) on 12 June 2009. Retrieved 23 June 2015.

- ^ "Project Milestones". Blue Brain. Retrieved 11 August 2008.

- ^ "Artificial brain '10 years away' 2009 BBC news". 22 July 2009. Archived from the original on 26 July 2017. Retrieved 25 July 2009.

- ^ University of Calgary news Archived 18 أغسطس 2009 at the Wayback Machine, NBC News news Archived 4 يوليو 2017 at the Wayback Machine

- ^ "Archived copy". Archived from the original on 15 June 2006. Retrieved 23 June 2006.

{{cite web}}: CS1 maint: archived copy as title (link) - ^ de Vega, Glenberg & Graesser 2008. A wide range of views in current research, all of which require grounding to some degree

- ^ "some links to bee brain studies". Archived from the original on 5 October 2011. Retrieved 30 March 2010.

- ^ In Goertzels' AGI book (Yudkowsky 2006), Yudkowsky proposes 5 levels of organisation that must be understood – code/data, sensory modality, concept & category, thought, and deliberation (consciousness) – in order to use the available hardware

- ^ Yekutieli, Y; Sagiv-Zohar, R; Aharonov, R; Engel, Y; Hochner, B; Flash, T (August 2005). "Dynamic model of the octopus arm. I. Biomechanics of the octopus reaching movement". J. Neurophysiol. 94 (2): 1443–58. doi:10.1152/jn.00684.2004. PMID 15829594.

- ^ Williams & Herrup 1988

- ^ "nervous system, human." Encyclopædia Britannica. 9 January 2007

- ^ Azevedo et al. 2009.

- ^ Searle 1980

- ^ As defined in a standard AI textbook: "The assertion that machines could possibly act intelligently (or, perhaps better, act as if they were intelligent) is called the 'weak AI' hypothesis by philosophers, and the assertion that machines that do so are actually thinking (as opposed to simulating thinking) is called the 'strong AI' hypothesis." (Russell & Norvig 2003)

- ^ For example:

- Russell & Norvig 2003,

- Oxford University Press Dictionary of Psychology Archived 3 ديسمبر 2007 at the Wayback Machine (quoted in "High Beam Encyclopedia"),

- MIT Encyclopedia of Cognitive Science Archived 19 يوليو 2008 at the Wayback Machine (quoted in "AITopics")

- Planet Math Archived 19 سبتمبر 2007 at the Wayback Machine

- Will Biological Computers Enable Artificially Intelligent Machines to Become Persons? Archived 13 مايو 2008 at the Wayback Machine Anthony Tongen

- ^ Russell & Norvig 2003, p. 947.

- ^ Note that consciousness is difficult to define. A popular definition, due to Thomas Nagel, is that it "feels like" something to be conscious. If we are not conscious, then it doesn't feel like anything. Nagel uses the example of a bat: we can sensibly ask "what does it feel like to be a bat?" However, we are unlikely to ask "what does it feel like to be a toaster?" Nagel concludes that a bat appears to be conscious (i.e. has consciousness) but a toaster does not. See (Nagel 1974)

- ^ Sotala, Kaj; Yampolskiy, Roman V (2014-12-19). "Responses to catastrophic AGI risk: a survey". Physica Scripta. 90 (1): 8. doi:10.1088/0031-8949/90/1/018001. ISSN 0031-8949.

- ^ Joy, Bill (April 2000). "Why the future doesn't need us". Wired.

- ^ Yudkowsky 2006.

- ^ Aleksander 1996.

- ^ أ ب ت ث ج ح خ د ذ Clocksin 2003.

- ^ McCarthy 2003.

- ^ أ ب ت ث Gelernter 2010.

- ^ أ ب McCarthy 2007.

- ^ أ ب ت ث Holte & Choueiry 2003.

- ^ Zucker 2003.

- ^ Kaplan, Andreas; Haenlein, Michael (2019). "Kaplan Andreas and Haelein Michael (2019) Siri, Siri, in my hand: Who's the fairest in the land? On the interpretations, illustrations, and implications of artificial intelligence". Business Horizons. 62: 15–25. doi:10.1016/j.bushor.2018.08.004.

- ^ itu.int: Beyond Mad?: The Race For Artificial General Intelligence, "AGI represents a level of power that remains firmly in the realm of speculative fiction as on date." February 2, 2018, retrieved March 3, 2020

- ^ Allen, Paul. "The Singularity Isn't Near". MIT Technology Review. Retrieved 17 September 2014.

- ^ Winfield, Alan. "Artificial intelligence will not turn into a Frankenstein's monster". The Guardian. Archived from the original on 17 September 2014. Retrieved 17 September 2014.

- ^ Raffi Khatchadourian (23 November 2015). "The Doomsday Invention: Will artificial intelligence bring us utopia or destruction?". The New Yorker. Archived from the original on 28 January 2016. Retrieved 7 February 2016.

- ^ Müller, V. C., & Bostrom, N. (2016). Future progress in artificial intelligence: A survey of expert opinion. In Fundamental issues of artificial intelligence (pp. 555–572). Springer, Cham.

- ^ Rawlinson, Kevin. "Microsoft's Bill Gates insists AI is a threat". BBC News. Retrieved 30 January 2015.

- ^ "Stephen Hawking: 'Transcendence looks at the implications of artificial intelligence – but are we taking AI seriously enough?'". The Independent (UK). Retrieved 3 December 2014.

- ^ Bostrom, Nick (2014). Superintelligence: Paths, Dangers, Strategies (First ed.). ISBN 978-0199678112.

- ^ Kaj Sotala; Roman Yampolskiy (19 December 2014). "Responses to catastrophic AGI risk: a survey". Physica Scripta. 90 (1).

- ^ "But What Would the End of Humanity Mean for Me?". The Atlantic. 9 May 2014. Retrieved 12 December 2015.

- ^ "Tech Luminaries Address Singularity". IEEE Spectrum: Technology, Engineering, and Science News (in الإنجليزية). No. SPECIAL REPORT: THE SINGULARITY. 1 June 2008. Retrieved 8 April 2020.

- ^ Shermer, Michael (1 March 2017). "Apocalypse AI". Scientific American (in الإنجليزية). p. 77. Bibcode:2017SciAm.316c..77S. doi:10.1038/scientificamerican0317-77. Retrieved 27 November 2017.

المراجع

- Halal, William E. "TechCast Article Series: The Automation of Thought" (PDF). Archived from the original (PDF) on 6 June 2013.

- Aleksander, Igor (1996), Impossible Minds, World Scientific Publishing Company, ISBN 978-1-86094-036-1, https://archive.org/details/impossiblemindsm0000alek

- Omohundro, Steve (2008), The Nature of Self-Improving Artificial Intelligence, presented and distributed at the 2007 Singularity Summit, San Francisco, CA.

- Sandberg, Anders; Boström, Nick (2008), Whole Brain Emulation: A Roadmap, Technical Report #2008‐3, Future of Humanity Institute, Oxford University, http://www.fhi.ox.ac.uk/Reports/2008-3.pdf, retrieved on 5 April 2009

- "Equal numbers of neuronal and nonneuronal cells make the human brain an isometrically scaled-up primate brain", The Journal of Comparative Neurology 513 (5): 532–41, April 2009, doi:, PMID 19226510, https://www.researchgate.net/publication/24024444, retrieved on 4 September 2013

- Berglas, Anthony (2008), Artificial Intelligence will Kill our Grandchildren, http://berglas.org/Articles/AIKillGrandchildren/AIKillGrandchildren.html

- Chalmers, David (1996), The Conscious Mind, Oxford University Press.

- Clocksin, William (Aug 2003), "Artificial intelligence and the future", Philosophical Transactions of the Royal Society A 361 (1809): 1721–1748, doi:, PMID 12952683, Bibcode: 2003RSPTA.361.1721C.

- قالب:Crevier 1993

- Darrach, Brad (20 November 1970), "Meet Shakey, the First Electronic Person", Life Magazine: 58–68.

- Drachman, D (2005), "Do we have brain to spare?", Neurology 64 (12): 2004–5, doi:, PMID 15985565.

- Feigenbaum, Edward A.; McCorduck, Pamela (1983), The Fifth Generation: Artificial Intelligence and Japan's Computer Challenge to the World, Michael Joseph, ISBN 978-0-7181-2401-4

- Gelernter, David (2010), Dream-logic, the Internet and Artificial Thought, http://www.edge.org/3rd_culture/gelernter10.1/gelernter10.1_index.html, retrieved on 25 July 2010

- Goertzel, Ben; Pennachin, Cassio, eds. (2006), Artificial General Intelligence, Springer, ISBN 978-3-540-23733-4, http://people.inf.elte.hu/csizsekp/ai/books/artificial-general-intelligence-cognitive-technologies.9783540237334.27156.pdf

- Goertzel, Ben; Wang, Pei (2006), Introduction: Aspects of Artificial General Intelligence, http://sites.google.com/site/narswang/publications/wang-goertzel.AGI_Aspects.pdf?attredirects=1

- Goertzel, Ben (Dec 2007), "Human-level artificial general intelligence and the possibility of a technological singularity: a reaction to Ray Kurzweil's The Singularity Is Near, and McDermott's critique of Kurzweil", Artificial Intelligence 171 (18, Special Review Issue): 1161–1173, doi:, https://scholar.google.com/scholar?hl=sv&lr=&cluster=15189798216526465792, retrieved on 1 April 2009.

- Gubrud, Mark (November 1997), "Nanotechnology and International Security", Fifth Foresight Conference on Molecular Nanotechnology, http://www.foresight.org/Conferences/MNT05/Papers/Gubrud/, retrieved on 7 May 2011

- Holte, RC; Choueiry, BY (2003), "Abstraction and reformulation in artificial intelligence", Philosophical Transactions of the Royal Society B 358 (1435): 1197–1204, doi:, PMID 12903653.

- Howe, J. (November 1994), Artificial Intelligence at Edinburgh University : a Perspective, http://www.dai.ed.ac.uk/AI_at_Edinburgh_perspective.html, retrieved on 30 August 2007

- Johnson, Mark (1987), The body in the mind, Chicago, ISBN 978-0-226-40317-5

- Kurzweil, Ray (2005), The Singularity is Near, Viking Press

- Lighthill, Professor Sir James (1973), "Artificial Intelligence: A General Survey", Artificial Intelligence: a paper symposium, Science Research Council

- Luger, George; Stubblefield, William (2004), Artificial Intelligence: Structures and Strategies for Complex Problem Solving (5th ed.), The Benjamin/Cummings Publishing Company, Inc., p. 720, ISBN 978-0-8053-4780-7, https://archive.org/details/artificialintell0000luge/page/720

- McCarthy, John (Oct 2007), "From here to human-level AI", Artificial Intelligence 171 (18): 1174–1182, doi:.

- قالب:McCorduck 2004

- Moravec, Hans (1976), The Role of Raw Power in Intelligence, http://www.frc.ri.cmu.edu/users/hpm/project.archive/general.articles/1975/Raw.Power.html, retrieved on 29 September 2007

- Moravec, Hans (1988), Mind Children, Harvard University Press

- Nagel (1974), "What Is it Like to Be a Bat", Philosophical Review 83 (4): 435–50, doi:, http://organizations.utep.edu/Portals/1475/nagel_bat.pdf.

- Newell, Allen; Simon, H. A. (1963), "GPS: A Program that Simulates Human Thought", in Feigenbaum, E.A.; Feldman, J., Computers and Thought, New York: McGraw-Hill

- Newell, Allen; Simon, H. A. (1976). "Computer Science as Empirical Inquiry: Symbols and Search". Communications of the ACM. 19 (3): 113–126. doi:10.1145/360018.360022.

{{cite journal}}: Invalid|ref=harv(help) - Nilsson, Nils (1998), Artificial Intelligence: A New Synthesis, Morgan Kaufmann Publishers, ISBN 978-1-55860-467-4

- قالب:Russell Norvig 2003

- NRC (1999), "Developments in Artificial Intelligence", Funding a Revolution: Government Support for Computing Research, National Academy Press

- Poole, David; Mackworth, Alan; Goebel, Randy (1998), Computational Intelligence: A Logical Approach, New York: Oxford University Press, http://www.cs.ubc.ca/spider/poole/ci.html

- Searle, John (1980), "Minds, Brains and Programs", Behavioral and Brain Sciences 3 (3): 417–457, doi:, http://cogprints.org/7150/1/10.1.1.83.5248.pdf

- Simon, H. A. (1965), The Shape of Automation for Men and Management, New York: Harper & Row

- Sutherland, J.G. (1990), "Holographic Model of Memory, Learning, and Expression", International Journal of Neural Systems 1–3: 256–267.

- "The control of neuron number", Annual Review of Neuroscience 11: 423–53, 1988, doi:, PMID 3284447.

- de Vega, Manuel; Glenberg, Arthur; Graesser, Arthur, eds. (2008), Symbols and Embodiment: Debates on meaning and cognition, Oxford University Press, ISBN 978-0-19-921727-4

- Yudkowsky, Eliezer (2006), Goertzel, Ben; Pennachin, Cassio, eds., "Artificial General Intelligence", Annual Review of Psychology (Springer) 49: 585–612, doi:, ISBN 978-3-540-23733-4, PMID 9496632, Archived from the original on 11 April 2009, https://web.archive.org/web/20090411050423/http://www.singinst.org/upload/LOGI/LOGI.pdf

- Zucker, Jean-Daniel (July 2003), "A grounded theory of abstraction in artificial intelligence", Philosophical Transactions of the Royal Society B 358 (1435): 1293–1309, doi:, PMID 12903672.

- Yudkowsky, Eliezer (2008), "Artificial Intelligence as a Positive and Negative Factor in Global Risk", Global Catastrophic Risks, Bibcode: 2008gcr..book..303Y.

وصلات خارجية

- The AGI portal maintained by Pei Wang

- The Genesis Group at MIT's CSAIL – Modern research on the computations that underlay human intelligence

- OpenCog – open source project to develop a human-level AI

- Simulating logical human thought

- What Do We Know about AI Timelines? – Literature review

- CS1 الإنجليزية الأمريكية-language sources (en-us)

- Harv and Sfn multiple-target errors

- Short description is different from Wikidata

- Articles with hatnote templates targeting a nonexistent page

- Articles with unsourced statements from June 2011

- Articles with unsourced statements from April 2011

- Articles to be expanded from February 2016

- All articles to be expanded

- Hypothetical technology

- ذكاء اصطناعي

- Computational neuroscience