زاحف الشبكة

زاحف الشبكة Web crawler، الذي يُطلق عليه أحياناً اسم العنكبوت أو بوت العنكبوت وغالباً ما يتم اختصاره إلى الزاحف، وهو بوت إنترنت يقوم بتصفح الشبكة العالمية بشكل منهجي، وعادةً ما يتم تشغيله بواسطة محركات البحث لغرض فهرسة الوب (تجسس الويب).[1]

يستخدم محرك بحث الوب وبعض مواقع الوب الأخرى برامج زحف الشبكة أو برامج التجسس لتحديث محتوى الوب أو مؤشرات محتوى الوب الخاص بالمواقع الأخرى. تقوم برامج زحف الشبكة بنسخ الصفحات للمعالجة بواسطة محرك بحث، والذي بفهرسة الصفحات التي تم تنزيلها بحيث يمكن للمستخدمين البحث بشكل أكثر كفاءة.

تستهلك برامج الزحف الموارد الموجودة على الأنظمة التي تمت زيارتها وغالباً ما تزور المواقع دون موافقة. وتدخل قضايا الجدولة، والتحميل، و "اللباقة" في التنافس عند الوصول إلى مجموعات كبيرة من الصفحات. وتوجد آليات للمواقع العامة التي لا ترغب في الزحف إليها لإعلام وكيل الزحف بذلك. على سبيل المثال، تضمين ملف robots.txt يمكن أن يطلب من البوتات فهرسة أجزاء فقط من موقع الوب، أو لا شيء على الإطلاق.

عدد صفحات الإنترنت كبير للغاية؛ حتى أكبر برامج الزحف تقصر عن إنشاء فهرس كامل. لهذا السبب، كافحت محركات البحث لإعطاء نتائج بحث ذات صلة في السنوات الأولى لشبكة الوب العالمية، قبل عام 2000. واليوم، يتم تقديم النتائج ذات الصلة على الفور تقريباً.

يمكن لبرامج الزحف التحقق من صحة الارتباط التشعبي ورمز HTML. ويمكن استخدامها أيضاً في استخلاص المواقع و البرمجة المبنية على البيانات.

التسمية

يُعرف زاحف الوب أيضاً باسم العنكبوت،[2] نملة، مفهرس تلقائي،[3] أو (في سياق برنامج FOAF) خداع الوب.[4]

نظرة عامة

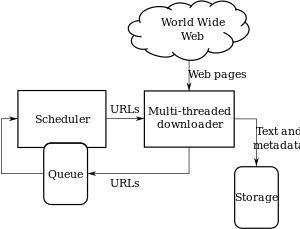

يبدأ زاحف الشبكة بقائمة عناوين URLs التي يجب، تسمى البذور. عندما يزور الزاحف عناوين URL هذه، فإنه يحدد جميع الارتباطات التشعبية في الصفحات ويضيفها إلى قائمة عناوين URL المراد زيارتها، والتي تسمى حدود الزحف. تتم زيارة عناوين URL من الحدود بشكل متكرر وفقاً لمجموعة من السياسات. إذا كان الزاحف يقوم بأرشفة مواقع الوب (أو أرشفة الوب)، فإنه ينسخ المعلومات ويحفظها كما هي. عادةً ما يتم تخزين الأرشيفات بطريقة يمكن عرضها وقراءتها والتنقل فيها كما لو كانت موجودة على الوب المباشر، ولكن يتم الاحتفاظ بها على أنها "لقطات\نسخ".[5]

يُعرف الأرشيف باسم المستودع وهو مصمم لتخزين وإدارة مجموعة صفحات الوب. حيث يخزن المستودع فقط صفحات HTML ويتم تخزين هذه الصفحات كملفات مميزة. يشبه المستودع أي نظام آخر يخزن البيانات، مثل قاعدة البيانات الحديثة. الاختلاف الوحيد هو أن المستودع لا يحتاج إلى جميع المهام التي يوفرها نظام قاعدة البيانات. يخزن المستودع أحدث إصدار من صفحة الوب التي تم استردادها بواسطة الزاحف.[6]

يشير الحجم الكبير إلى أن الزاحف يمكنه فقط تنزيل عدد محدود من صفحات الوب في غضون وقت معين، لذلك يحتاج إلى تحديد أولويات التنزيلات الخاصة به. يمكن أن يشير معدل التغيير المرتفع إلى أن الصفحات ربما تم تحديثها بالفعل أو حتى حذفها.

كما أن عدد عناوين URL المحتملة التي تم الزحف إليها والتي يتم إنشاؤها بواسطة برنامج من جانب المخدم جعل من الصعب على برامج زحف الشبكة تجنب استرداد محتوى مكرر. توجد مجموعات لا حصر لها من پارامترات HTTP GET (المستندة إلى عنوان URL)، والتي فقط مجموعة صغيرة منها ستعرض محتوى فريداً. على سبيل المثال، قد يوفر معرض الصور البسيط عبر الإنترنت ثلاثة خيارات للمستخدمين، كما هو محدد من خلال معلمات HTTP GET في عنوان URL. إذا كانت هناك أربع طرق لفرز الصور، وثلاثة خيارات لحجم الصورة المصغرة، وتنسيقي ملفين، وخيار لتعطيل المحتوى المقدم من المستخدم، فيمكن الوصول إلى نفس مجموعة المحتوى باستخدام 48 عنوان URL مختلفاً، وكلها قد تكون مرتبطة بالموقع. هذا التجميع الرياضي يخلق مشكلة لبرامج الزحف، حيث يجب عليهم الفرز من خلال مجموعات لا حصر لها من التغييرات النصية البسيطة نسبياً من أجل استرداد المحتوى الفريد.

كما لاحظ إدواردز وآخرون، "بالنظر إلى أن النطاق الترددي لإجراء عمليات الزحف ليس لانهائياً ولا حراً، فقد أصبح من الضروري الزحف إلى الشبكة ليس فقط بطريقة قابلة للتطوير، بل تتسم بالكفاءة على سبيل المثال، إذا كان يجب الحفاظ على قدر معقول من الجودة أو الجِدة."[7]يجب أن يختار الزاحف بعناية في كل خطوة الصفحات التي يجب زيارتها بعد ذلك.

سياسة الزحف

سلوك زاحف الويب هو نتيجة مجموعة من السياسات:[8]

- سياسة الاختيار التي تنص على الصفحات المراد تنزيلها،

- سياسة إعادة الزيارة التي تنص على وقت التحقق من التغييرات في الصفحات،

- سياسة التهذيب التي تنص على كيفية تجنب التحميل الزائد مواقع الوب.

- سياسة الموازاة التي تنص على كيفية تنسيق برامج زحف الشبكة الموزعة.

سياسة الاختيار

نظراً للحجم الحالي للوب، حتى محركات البحث الكبيرة لا تغطي سوى جزء من الجزء المتاح للعامة. وقد أظهرت دراسة أجريت عام 2009 أن فهرس محركات البحث واسع النطاق لا يزيد عن 40-70٪ من الوب القابل للفهرسة؛[9] فقد أظهرت دراسة سابقة قام بها ستيڤ لورنس و لي جايلز أنه لا يوجد محرك بحث مفهرس أكثر من 16٪ من الوب في عام 1999.[10] نظراً لأن الزاحف يقوم دائماً بتنزيل جزء بسيط فقط من صفحات الوب، فمن المستحسن جداً أن يحتوي الجزء الذي تم تنزيله على الصفحات الأكثر صلة وليس مجرد عينة عشوائية من الوب.

يتطلب هذا مقياساً للأهمية لتحديد أولويات صفحات الوب. ترجع أهمية الصفحة إلى جودتها الجوهرية وشعبيتها من حيث الروابط أو الزيارات وحتى عنوان URL الخاص بها (الأخير هو حالة محركات البحث العمودية مقصورة على نطاق المستوى الأعلى المفرد، أو محركات بحث مقيدة بموقع وب ثابت). يواجه تصميم سياسة اختيار جيدة صعوبة إضافية: يجب أن تعمل مع معلومات جزئية، لأن المجموعة الكاملة من صفحات الوب غير معروفة أثناء الزحف.

قام دجنگهو تشو وآخرون بإجراء الدراسة الأولى حول سياسات جدولة الزحف. كانت مجموعة البيانات الخاصة بهم عبارة عن 180 ألف صفحة يتم الزحف إليها من النطاق stanford.edu، حيث تم إجراء محاكاة الزحف باستخدام إستراتيجيات مختلفة.[11]وكانت مقاييس الترتيب التي تم اختبارها عبارة عن حسابات النطاق أولاً، عدد الروابط النصية و پيدج رانك. كان أحد الاستنتاجات هو أنه إذا أراد الزاحف تنزيل صفحات ذات ترتيب صفحات عالي في وقت مبكر أثناء عملية الزحف، فإن استراتيجية Pagerank ترتيب الصفحات الجزئية هي الأفضل، متبوعةً بالنطاق أولاً وعدد الروابط النصية. ومع ذلك، فإن هذه النتائج لمجال واحد فقط. فقد كتب تشو أيضاً أطروحة الدكتوراه الخاصة به في جامعة ستانفورد عن زحف الشبكة.[12]

أجرى ناجورك ووڤنر زحفاً فعلياً على 328 مليون صفحة، باستخدام ترتيب النطاق أولاً.[13] ووجدوا أن زحف النطاق أولاً يلتقط الصفحات ذات رتبة المرتفعة في وقت مبكر من الزحف (لكنهم لم يقارنوا هذه الإستراتيجية مع الاستراتيجيات الأخرى). التفسير الذي قدمه المؤلفون لهذه النتيجة هو أن "الصفحات الأكثر أهمية لها العديد من الروابط إليها من مضيفين متعددين، وسيتم العثور على هذه الروابط مبكراً، بغض النظر عن المضيف أو الصفحة التي نشأ الزحف عليها."

فقد قام آبتبول إستراتيجية زحف تستند إلى خوارزمية تسمى OPIC (حساب أهمية الصفحة عبر الإنترنت).[14]في OPIC، يتم إعطاء كل صفحة مبلغاً أولياً من "النقد" يتم توزيعه بالتساوي بين الصفحات التي تشير إليها. إنه مشابه لحساب رتبة الصفحة، ولكنه أسرع ويتم إجراؤه في خطوة واحدة فقط. يقوم الزاحف المستند إلى OPIC بتنزيل الصفحات أولاً في حدود الزحف بمبالغ "نقدية" أعلى. تم إجراء التجارب في رسم بياني اصطناعي مكون من 100000 صفحة مع توزيع قانون الطاقة للوصلات الداخلية. ومع ذلك، لم تكن هناك مقارنة مع استراتيجيات أو تجارب أخرى في الوب الحقيقي.

استخدم بولدي وآخرون. محاكاة على مجموعات فرعية من الوب تتكون من 40 مليون صفحة من مجال .it و 100 مليون صفحة من زحف على أساس الوب، واختبار النطاق أولاً مقابل العمق أولاً، والترتيب العشوائي والاستراتيجية الشاملة. استندت المقارنة إلى مدى دقة حساب نظام ترتيب الصفحات في عملية الزحف الجزئي في تقريب القيمة الحقيقية لنظام ترتيب الصفحات. من المثير للدهشة أن بعض الزيارات التي تتراكم في نظام ترتيب الصفحات بسرعة كبيرة (وعلى وجه الخصوص، العرض أولاً والزيارة الشاملة) والتي تقدم تقديرات تقريبية سيئة للغاية.[15][16]

استخدم بايزا-ييتس وآخرون المحاكاة على مجموعتين فرعيتين من الوب من 3 ملايين صفحة من النطاق .gr و .cl، لاختبار العديد من استراتيجيات الزحف.[17] لقد أظهروا أن كلاً من إستراتيجية OPIC والإستراتيجية التي تستخدم طول قوائم الانتظار لكل موقع أفضل من زحف النطاق أولاً، كما أنها فعالة جداً لاستخدام الزحف السابق، عندما تكون متاحة، لتوجيه الحالي.

قام دانيشپاجوه وآخرون بتصميم خوارزمية مشتركة لاكتشاف البذور الجيدة.[18]تقوم طريقتهم بالزحف إلى صفحات الوب ذات نظام ترتيب الصفحات المرتفع من مجموعات مختلفة بتكرار أقل مقارنة بالزحف الذي يبدأ من البذور العشوائية. يمكن للمرء استخراج بذرة جيدة من رسم بياني للوب تم الزحف إليه مسبقاً باستخدام هذه الطريقة الجديدة. باستخدام هذه البذور، يمكن أن يكون الزحف الجديد فعالًا جداً.

تقييد الروابط المتبعة

قد يرغب الزاحف فقط في البحث عن صفحات HTML وتجنب جميع أنواع MIME الأخرى. من أجل طلب موارد HTML فقط، قد يقوم الزاحف بطلب HTTP HEAD لتحديد نوع MIME لمورد الوب قبل طلب المورد بأكمله مع طلب GET. لتجنب إجراء العديد من طلبات HEAD، قد يفحص الزاحف عنوان URL ويطلب مورداً فقط إذا انتهى عنوان URL بأحرف معينة مثل .html أو .htm أو .asp أو .aspx أو .php أو .jsp أو .jspx أو شرطة مائلة. قد تتسبب هذه الاستراتيجية في تخطي العديد من موارد وب HTML بدون قصد.

قد تتجنب بعض برامج الزحف أيضاً طلب أي موارد تحتوي على "؟" بداخلها (يتم إنتاجها ديناميكياً) لتجنب مصائد العنكبوت التي قد تتسبب في قيام الزاحف بتنزيل عدد لا نهائي من عناوين URL من موقع وب. لا يمكن الاعتماد على هذه الإستراتيجية إذا كان الموقع يستخدم محرك إعادة كتابة لتبسيط عناوين URL الخاصة به.

تطبيع معرف الموارد الموحد

عادةً ما تنفذ برامج الزحف نوعاً من تسوية عنوان URL لتجنب الزحف إلى المورد نفسه أكثر من مرة. يشير المصطلح تطبيع عنوان URL، المعروف أيضاً باسم تحديد عنوان URL الأساسي، إلى عملية تعديل عنوان URL وتوحيده بطريقة متسقة. هناك عدة أنواع من التسوية التي يمكن إجراؤها بما في ذلك تحويل عناوين URL إلى أحرف صغيرة وإزالة "." ومقاطع ".."، وإضافة شرطات مائلة لاحقة إلى مكون المسار غير الفارغ.[19]

مسار الزحف التصاعدي

تنوي بعض برامج الزحف تنزيل / تحميل أكبر عدد ممكن من الموارد من موقع ويب معين. لذلك تم تقديم الزاحف التصاعدي للمسار والذي من شأنه أن يصعد إلى كل مسار في كل عنوان URL ينوي الزحف إليه.[20]على سبيل المثال، عند إعطاء عنوان URL أولي لـ http://llama.org/hamster/monkey/page.html، سيحاول الزحف / hamster / monkey / و / hamster / و /. وجد كوتي أن الزاحف الصاعد للمسار كان فعالًا للغاية في العثور على موارد معزولة، أو موارد لم يتم العثور على رابط وارد لها في الزحف المنتظم.

زحف مركز

يمكن أيضاً التعبير عن أهمية الصفحة بالنسبة إلى الزاحف كدالة للتشابه بين الصفحة واستعلام معين. تسمى برامج زحف الويب التي تحاول تنزيل الصفحات المتشابهة مع بعضها بـ الزاحف المركّز أو برامج الزحف الموضعية. فقد تم تقديم مفاهيم الزحف الموضعي والمركّز لأول مرة بواسطة فيليپ منتشر[21][22]وسومن تشاكرابارتي وآخرون.[23]

المشكلة الرئيسية في الزحف المركز هي أنه في سياق زاحف الشبكة، نود أن نكون قادرين على توقع تشابه نص صفحة معينة مع الاستعلام قبل تنزيل الصفحة فعلياً. المتنبئ المحتمل هو النص الأساسي للروابط؛ كان هذا هو النهج الذي اتبعته پنكرتون[24] في أول زاحف شبكة في الأيام الأولى للوب. قام ديليجنتي وآخرون.[25]باقتراح استخدام المحتوى الكامل للصفحات التي تمت زيارتها بالفعل لاستنتاج التشابه بين الاستعلام النشط والصفحات التي لم تتم زيارتها بعد. ويعتمد أداء الزحف المركز في الغالب على ثراء الروابط في الموضوع المحدد الذي يتم البحث فيه، ويعتمد الزحف المركز عادةً على محرك بحث وب عام لتوفير نقاط البداية.

برنامج الزاحف الأكاديمي

من الأمثلة على برامج الزحف المركزة برامج الزحف الأكاديمية، التي تزحف إلى المستندات الأكاديمية ذات الصلة بالوصول الحر، مثل سايتسير بوت، وهو برنامج تتبع الارتباطات لمحرك البحث سايتسيرX. محركات البحث الأكاديمية الأخرى هي گوگل سكولار و بحث مايكروسوفت الأكاديمي إلخ. ولأن معظم الأبحاث الأكاديمية يتم نشرها بتنسيقات صيغة المستندات المنقولة، فإن هذا النوع من الزاحف يهتم بشكل خاص بالزحف إلى PDF، ملفات پوستسكرپت، مايكروسوفت وورد بما في ذلك تنسيقاتها المضغوطة. لهذا السبب، يجب تخصيص برامج الزحف العامة مفتوحة المصدر، مثل هرتركس، لتصفية نوع الوسائط الأخرى، أو يتم استخدام برامج وسيطة لاستخراج هذه المستندات واستخلاصها إلى قاعدة بيانات الزحف المركزة والقابلة للخزن.[26] إن تحديد ما إذا كانت هذه المستندات أكاديمية تمثل أم لا تحدياً ويمكن أن يضيف عبئاً كبيراً إلى عملية الزحف، لذلك يتم تنفيذ ذلك كعملية زحف لاحقة باستخدام خوارزميات التعلم الآلي أو التعبير النمطي. عادة ما يتم الحصول على هذه الوثائق الأكاديمية من الصفحات الرئيسية للكليات والطلاب أو من صفحة نشر معاهد البحث. نظراً لأن المستندات الأكاديمية لا تستغرق سوى جزء صغير في صفحات الوب بأكملها، فإن اختيار البذور الجيدة أمر مهم في تعزيز كفاءات برامج زحف الوب هذه.[27] قد تقوم برامج الزحف الأكاديمية الأخرى بتنزيل ملفات نصية عادية وملفات HTML، والتي تحتوي على البيانات الوصفية للأبحاث الأكاديمية، مثل العناوين والأبحاث والملخصات. يؤدي هذا إلى زيادة العدد الإجمالي للأوراق، ولكن جزءاً كبيراً قد لا يوفر تنزيلات PDF مجانية.

الزاحف المركّز الدلالي

هناك نوع آخر من برامج الزحف المركزة وهو برنامج الزاحف المركّز على الدلالات، والذي يستخدم أنطولوجيات المجال لتمثيل الخرائط الموضعية وربط صفحات الوب بالمفاهيم الوجودية المرتبطة لأغراض الاختيار والتصنيف.[28]بالإضافة إلى ذلك، يمكن تحديث الأنطولوجية تلقائياً في عملية الزحف. فقد قدم دونگ وآخرون.[29] مثل هذا الزاحف القائم على الأنطولوجية باستخدام آلة المتجه الداعمة لتحديث محتوى المفاهيم الأنطولوجية عند الزحف إلى صفحات الوب.

سياسة إعادة الزيارة

للويب طبيعة ديناميكية للغاية، ويمكن أن يستغرق الزحف إلى جزء صغير من الوب أسابيع أو شهور. بحلول الوقت الذي ينتهي فيه متتبع ارتباطات الوب من الزحف الخاص به، كان من الممكن حدوث العديد من الأحداث، بما في ذلك عمليات الإنشاء والتحديثات والحذف.

من وجهة نظر محرك البحث، هناك تكلفة مرتبطة بعدم اكتشاف حدث، وبالتالي وجود نسخة قديمة من مورد. فدوال التكلفة الأكثر استخداماً هي الحداثة والعمر.[30]

الحداثة: وهو مقياس ثنائي يشير إلى ما إذا كانت النسخة المحلية دقيقة أم لا. يتم تعريف حداثة الصفحة p في المخزن في الوقت t على أنها:

العمر: وهو مقياس يشير إلى مدى تقادم النسخة المحلية. يتم تعريف عمر الصفحة p في المخزن، في الوقت الذي يتم فيه تعريف t على النحو التالي:

عمل كوفمان وآخرون مع تعريف هدف زاحف الشبكة الذي يعادل الحداثة، لكنهم يستخدمون صياغة مختلفة: حيث اقترحوا أن الزاحف يجب أن يقلل جزء الوقت التي تبقى فيه الصفحات قديمة. كما أشاروا إلى أن مشكلة زحف الشبكة يمكن تصميمها كنموذج لقائمة انتظار متعددة ونظام استطلاع مخدم واحد، حيث يكون متتبع ارتباطات الوب هو المخدم ومواقع الوب هي قوائم الانتظار. تعديلات الصفحة هي وصول العملاء، وأوقات التبديل هي الفاصل الزمني بين وصول الصفحة إلى موقع وب واحد. في ظل هذا النموذج، فإن متوسط وقت انتظار العميل في نظام الاقتراع يعادل متوسط عمر زاحف الشبكة.[31]

الهدف من الزاحف هو الحفاظ على متوسط حداثة الصفحات في مجموعته على أعلى مستوى ممكن، أو الحفاظ على متوسط عمر الصفحات عند أدنى مستوى ممكن. هذه الأهداف ليست متكافئة: في الحالة الأولى، يهتم الزاحف فقط بعدد الصفحات القديمة، بينما في الحالة الثانية، يهتم الزاحف بمدى عمر النسخ المحلية للصفحات.

تمت دراسة سياستين بسيطتين لإعادة الزيارة من قبل تشو وگارسيا-مولينا:[32]

- السياسة الموحدة: يتضمن هذا إعادة زيارة جميع الصفحات في المجموعة بنفس التكرار، بغض النظر عن معدلات التغيير الخاصة بها.

- السياسة النسبية: يتضمن هذا إعادة زيارة الصفحات التي تتغير بشكل متكرر أكثر. يتناسب تردد الزيارة بشكل مباشر مع تردد التغيير (المقدر).

في كلتا الحالتين، يمكن إجراء ترتيب الزحف المتكرر للصفحات إما بترتيب عشوائي أو بترتيب ثابت.

أثبت كل من تشو و گارسيا-مولينا النتيجة المفاجئة المتمثلة في أن السياسة الموحدة ، من حيث متوسط الحداثة ، تتفوق في الأداء على السياسة النسبية في كل من محاكاة الوب وزحف الوب الحقيقي. بشكل بديهي، السبب هو أنه، نظراً لأن برامج زحف الوب لديها حد لعدد الصفحات التي يمكنها الزحف إليها في إطار زمني معين، (1) فإنها ستخصص عدداً كبيراً جداً من عمليات الزحف الجديدة للصفحات المتغيرة بسرعة على حساب الصفحات الأقل تحديثًا، و (2) تستمر حداثة الصفحات المتغيرة بسرعة لفترة أقصر من تلك الخاصة بالصفحات الأقل تغيراً. بعبارة أخرى، تخصص السياسة التناسبية مزيداً من الموارد للزحف إلى الصفحات التي يتم تحديثها بشكل متكرر، ولكنها تواجه وقت حداثة أقل بشكل عام منها.

لتحسين الحداثة، يجب أن يعاقب\يؤدب\يهذب الزاحف العناصر التي تتغير كثيراً.[33] فسياسة إعادة الزيارة المثلى ليست السياسة الموحدة ولا السياسة النسبية. حيث تتضمن الطريقة المثلى للحفاظ على متوسط الحداثة مرتفعاً تجاهل الصفحات التي تتغير كثيراً، والطريقة المثلى للحفاظ على متوسط العمر منخفضاً هو استخدام ترددات الوصول التي تزيد بشكل رتيب (وشبه الخطية) مع معدل التغيير لكل صفحة. في كلتا الحالتين، يكون الخيار الأمثل أقرب إلى السياسة الموحدة منه إلى السياسة النسبية: كما لاحظ كوفمان وآخرون. من أجل تقليل وقت التقادم المتوقع، يجب الاحتفاظ بمسافات الوصول إلى أي صفحة معينة بشكل متساوٍ قدر الإمكان ".[31]لا يمكن تحقيق الصيغ الصريحة لسياسة إعادة الزيارة بشكل عام، ولكن يتم الحصول عليها عددياً، لأنها تعتمد على توزيع تغييرات الصفحة. يوضح كل من تشو و گارسيا-مولينا أن التوزيع الأسي مناسب جداً لوصف تغييرات الصفحة ،[33]بينما يوضح ايپيروتيس وآخرون كيفية استخدام الأدوات الإحصائية لاكتشاف الپارامترات التي تؤثر على هذا التوزيع.[34]لاحظ أن سياسات إعادة الزيارة التي تم النظر فيها هنا تعتبر جميع الصفحات متجانسة من حيث الجودة ("جميع الصفحات على الوب تساوي نفس القيمة")، وهو أمر لا يعتبر سيناريو واقعي، لذا يجب توفير مزيد من المعلومات حول جودة صفحة الوب المضمنة لتحقيق سياسة زحف أفضل.

سياسة التأدب

يمكن لبرامج الزحف استرداد البيانات بشكل أسرع بكثير وعمق أكبر من الباحثين البشريين، لذلك يمكن أن يكون لها تأثير معوق على أداء الموقع. إذا كان زاحف واحد ينفذ طلبات متعددة في الثانية و/أو يقوم بتنزيل ملفات كبيرة، فقد يواجه المخدم صعوبة في مواكبة الطلبات الواردة من برامج زحف متعددة.

كما لاحظ Koster ، فإن استخدام برامج زحف الويب مفيد لعدد من المهام، ولكنه يأتي بقيمة للمجتمع العام.[35] تشمل تكاليف استخدام برامج زحف الشبكة:

- موارد الشبكة، حيث تتطلب برامج الزحف نطاقاً ترددياً\عرض حزمة كبيراً وتعمل بدرجة عالية من التوازي خلال فترة زمنية طويلة؛

- الحمل الزائد للمخدم، خاصة إذا كان معدل الوصول إلى مخدم معين مرتفعاً جداً؛

- برامج الزحف سيئة الكتابة، والتي يمكن أن تعطل المخدمات أو أجهزة التوجيه، أو صفحات التنزيل التي لا يمكنها التعامل معها؛ و

- برامج الزحف الشخصية التي، إذا تم نشرها بواسطة عدد كبير جداً من المستخدمين، يمكنها تعطيل الشبكات ومخدمات الوب.

يتمثل أحد الحلول الجزئية لهذه المشكلات في پروتوكول استبعاد برامج الروبوت، المعروف أيضاً باسم پروتوكول robots.txt الذي يعد معياراً للمسؤولين للإشارة إلى أجزاء خوادم الوب الخاصة بهم التي لا يجب الوصول إليها بواسطة برامج الزحف.[36] لا يتضمن هذا المعيار اقتراحاً لفاصل الزيارات إلى نفس المخدم، على الرغم من أن هذا الفاصل الزمني هو الطريقة الأكثر فاعلية لتجنب التحميل الزائد للمخدم. يمكن لمحركات البحث التجارية مؤخراً مثل جوجل و آسك دجيڤز و MSN و محرك بحث ياهو! استخدام پارامتر "تأخير الزحف:" إضافية في ملف robots.txt للإشارة إلى عدد الثواني للتأخير بين الطلبات.

كانت الفترة الزمنية المقترحة الأولى بين تحميلات الصفحات المتتالية 60 ثانية.[37]ومع ذلك، إذا تم تنزيل الصفحات بهذا المعدل من موقع وب يحتوي على أكثر من 100000 صفحة عبر اتصال مثالي بدون زمن انتقال ونطاق ترددي لانهائي، فسيستغرق الأمر أكثر من شهرين لتنزيل موقع الوب هذا بالكامل فقط؛ أيضاً، سيتم استخدام جزء بسيط فقط من الموارد من مخدم الوب هذا. وهذا لا يبدو مقبولا

يستخدم تشو 10 ثوانٍ كفاصل زمني للوصول،[32] ويستخدم زاحف واير 15 ثانية كخيار افتراضي.[38] يتبع الزاحف ميركاتووب سياسة التأدب التكيفية: إذا استغرق تنزيل مستند من مخدم معين t ثوانٍ، ينتظر الزاحف 10 ثوانٍ قبل تنزيل الصفحة التالية.[39]وقد استخدم ديل وآخرون. ثانية واحدة.[40]

بالنسبة لأولئك الذين يستخدمون برامج زحف الشبكة لأغراض البحث، يلزم إجراء تحليل أكثر تفصيلاً للتكلفة والعائد ويجب أخذ الاعتبارات الأخلاقية في الاعتبار عند تحديد مكان الزحف ومدى سرعة الزحف.[41]

تُظهر الأدلة الغير علمية من سجلات الوصول أن فترات الوصول من برامج الزحف المعروفة تتراوح بين 20 ثانية و 3-4 دقائق. من الجدير بالملاحظة أنه حتى عندما تكون مهذباً للغاية، وتتخذ جميع الإجراءات الوقائية لتجنب التحميل الزائد على مخدمات الوب، يتم تلقي بعض الشكاوى من مسؤولي مخدم الوب. لاحظ برين و پيدج أن: "... تشغيل زاحف يتصل بأكثر من نصف مليون مخدم (...) يولد قدراً معقولاً من البريد الإلكتروني و المكالمات الهاتفية: نظراً للعدد الهائل من الأشخاص الذين يصبحون أونلاين، فهناك دائماً من لا يعرفون ما هو الزاحف، لأن هذا هو أول ما يروه."[42]

سياسة الموازاة

الزاحف الموازي عبارة عن زاحف يدير عمليات متعددة على التوازي. الهدف هو زيادة معدل التنزيل إلى الحد الأقصى مع تقليل الحمل من الموازاة وتجنب التنزيلات المتكررة لنفس الصفحة. لتجنب تنزيل نفس الصفحة أكثر من مرة، يتطلب نظام الزحف سياسة لتعيين عناوين URL الجديدة التي تم اكتشافها أثناء عملية الزحف، حيث يمكن العثور على نفس عنوان URL من خلال عمليتي زحف مختلفتين.

البنى

لا يجب أن يمتلك الزاحف إستراتيجية زحف جيدة فقط، كما هو مذكور في الأقسام السابقة، ولكن يجب أن يكون له أيضاً بنية محسّنة للغاية.

لاحظ شكاپينيوك وسويل أن:[43]

في حين أنه من السهل إلى حد ما إنشاء زاحف بطيء يقوم بتنزيل بضع صفحات في الثانية لفترة قصيرة من الوقت، فإن بناء نظام عالي الأداء يمكنه تنزيل مئات الملايين من الصفحات على مدار عدة أسابيع يمثل عدداً من التحديات في تصميم النظام، I/O وكفاءة الشبكة والمتانة وسهولة الإدارة.

تعد برامج زحف الشبكة جزءاً أساسياً من محركات البحث، ويتم الاحتفاظ بتفاصيل الخوارزميات والهندسة المعمارية كأسرار عمل. عندما يتم نشر تصميمات الزاحف، غالباً ما يكون هناك نقص مهم في التفاصيل يمنع الآخرين من إعادة إنتاج العمل. هناك أيضاً مخاوف ناشئة بشأن "محرك البحث غير المرغوب فيه"، والتي تمنع محركات البحث الرئيسية من نشر خوارزميات الترتيب\التصنيف الخاصة بها.

الأمن

بينما يحرص معظم مالكي مواقع الوب على فهرسة صفحاتهم على أوسع نطاق ممكن ليكون لها حضور قوي في محركات البحث، يمكن أن يكون لتتبع ارتباطات الوب عواقب غير مقصودة ويؤدي إلى اختراق أو خرق البيانات إذا قام محرك بحث بفهرسة الموارد التي لا ينبغي أن تكون متاحة للعامة، أو الصفحات التي تكشف عن إصدارات البرامج التي يحتمل أن تكون ضعيفة.

بصرف النظر عن التوصيات القياسية أمن تطبيقات الوب، يمكن لمالكي مواقع الوب تقليل تعرضهم للقرصنة الانتهازية من خلال السماح لمحركات البحث فقط بفهرسة الأجزاء العامة من مواقع الوب الخاصة بهم (باستخدام robots.txt) وحظرهم بشكل صريح من فهرسة أجزاء المعاملات (صفحات تسجيل الدخول والصفحات الخاصة وما إلى ذلك).

تحديد الزاحف

عادةً ما تقوم برامج زحف الوب بتعريف نفسها لمخدم وب باستخدام حقل مستخدم-وكيل لطلب HTTP. يقوم مسؤولو مواقع الوب عادةً بفحص سجل مخدم الوب الخاص بهم ويستخدمون حقل وكيل المستخدم لتحديد برامج الزحف التي زارت مخدم الوب وعدد المرات. قد يشتمل حقل وكيل المستخدم على URL حيث قد يكتشف مسؤول موقع الوب مزيداً من المعلومات حول الزاحف. يعد فحص سجل مخدم الوب مهمة شاقة، ولذلك يستخدم بعض المسؤولين أدوات لتحديد برامج زحف الوب وتتبعها والتحقق منها. من غير المحتمل أن تضع سپام بوت وبرامج زحف الوب الضارة الأخرى معلومات تحديد الهوية في حقل وكيل المستخدم، أو قد تخفي هويتها كمتصفح أو غير ذلك من برامج الزحف المعروفة.

من المهم أن تقوم برامج زحف الوب بتعريف نفسها بحيث يمكن لمسؤولي مواقع الوب الاتصال بالمالك إذا لزم الأمر. في بعض الحالات، قد تكون برامج الزحف محاصرة عن طريق الخطأ في مصيدة الزاحف أو قد تفرط في تحميل مخدم الوب بالطلبات، ويحتاج المالك إلى إيقاف الزاحف. التعريف مفيد أيضاً للمسؤولين المهتمين بمعرفة الوقت الذي يتوقعون فيه فهرسة صفحات الوب الخاصة بهم بواسطة محرك بحث معين.

زحف الوب العميق

يوجد قدر هائل من صفحات الوب في الوب العميق أو غير المرئي.[44] لا يمكن الوصول إلى هذه الصفحات عادةً إلا عن طريق إرسال استعلامات إلى قاعدة بيانات، ولا تتمكن برامج الزحف العادية من العثور على هذه الصفحات إذا لم تكن هناك روابط تشير إليها. يهدف پروتوكول خرائط الموقع و mod oai من گوگل[45] إلى السماح باكتشاف موارد الوب العميق هذه.

يؤدي الزحف العميق إلى الوب أيضاً إلى مضاعفة عدد روابط الوب التي سيتم الزحف إليها. تأخذ بعض برامج الزحف بعض عناوين URL في شكل <a href="URL">. في بعض الحالات، مثل گوگل بوت، يتم إجراء زحف الوب على كل النص الموجود داخل محتوى النص التشعبي أو العلامات أو النص.

يمكن اتباع الأساليب الإستراتيجية لاستهداف محتوى الويب العميق. باستخدام تقنية تسمى استخلاص الشاشة، يمكن تخصيص البرامج المتخصصة للاستعلام تلقائياً وبشكل متكرر عن نموذج وب معين بهدف تجميع البيانات الناتجة. يمكن استخدام مثل هذه البرامج لتوسيع نماذج وب متعددة عبر مواقع وب متعددة. يمكن أخذ البيانات المستخرجة من نتائج إرسال نموذج وب وتطبيقها كمدخلات إلى نموذج وب آخر وبالتالي إنشاء الاستمرارية عبر الوب العميق بطريقة غير ممكنة مع برامج زحف الوب التقليدية.[46]

الصفحات المبنية على أجاكس من بين تلك التي تسبب مشاكل لبرامج زحف الوب. اقترحت گوگل تنسيقاً لاستدعاءات أجاكس\AJAX يمكن لروبوتها التعرف عليه وفهرسته.[47]

تحيز زاحف الوب

أظهرت دراسة حديثة تستند إلى تحليل واسع النطاق لملفات robots.txt أن بعض برامج زحف الوب كانت مفضلة على غيرها، مع كون Googlebot\گوگل بوت هو زاحف الوب الأكثر تفضيلاً.[48]

الزواحف المرئية مقابل برامج الزحف المبرمجة

هناك عدد من منتجات "استخلاص/ زاحف الوب المرئي" المتاحة على الوب والتي ستقوم بالزحف إلى الصفحات وهيكل البيانات في أعمدة وصفوف بناءً على متطلبات المستخدمين. أحد الاختلافات الرئيسية بين الزاحف الكلاسيكي والمرئي هو مستوى قدرة البرمجة المطلوبة لإعداد الزاحف. يزيل أحدث جيل من "أدوات الاستخلاص المرئية" غالبية مهارات البرمجة اللازمة لتكون قادراً على البرمجة وبدء الزحف لكشط بيانات الوب.

تعتمد طريقة الاستخلاص/الزحف المرئي على "تعليم" المستخدم جزء من تقنية الزاحف، والتي تتبع بعد ذلك أنماطاً في مصادر البيانات شبه المنظمة. تتمثل الطريقة السائدة في تعليم الزاحف المرئي في تمييز البيانات في المتصفح وتدريب الأعمدة والصفوف. في حين أن التكنولوجيا ليست جديدة، على سبيل المثال، كانت أساس نيدل بيس التي اشترتها گوگل (كجزء من عملية استحواذ أكبر على مختبرات ITA [49])، فهناك نمو واستثمار مستمر في هذا المجال من قبل المستثمرين والمستخدمين النهائيين.[50]

قائمة برامج زحف الشبكة

فيما يلي قائمة بهياكل الزاحف المنشورة لبرامج الزحف للأغراض العامة (باستثناء برامج زحف الشبكة المركزة)، مع وصف موجز يتضمن الأسماء المعطاة للمكونات المختلفة والميزات البارزة:

برامج زحف الشبكة العامة

- كان دودة الوب العالمية عبارة عن برنامج زاحف يستخدم لإنشاء فهرس بسيط لعناوين المستندات وعناوين URL. يمكن البحث في الفهرس باستخدام الأمر گريپ يونكس.

- ياهو! سلرپ هو اسم زاحف البحث ياهو! حتى قامت ياهو! بالتعاقد مع مايكروسوفت لاستخدام بنگ بوت بدلاً من ذلك.

برامج زحف الشبكة الداخلية

- بنگ بوت هو اسم زاحف شبكة بنگ من مايكروسوفت. وقد حل محل إم إس إن بوت.

- بايدو سپايدر وهو زاحف شبكة من بايدو.

- تم وصف گوگل بوت بشيء من التفصيل، لكن المرجع يتعلق فقط بنسخة أولية من بنيته، والتي تمت كتابتها بلغة C++ و پايثون. تم دمج الزاحف مع عملية الفهرسة، لأنه تم تحليل النص لفهرسة النص الكامل وأيضاً لاستخراج عنوان URL. هناك مخدم URL يرسل قوائم بعناوين URL ليتم جلبها من خلال العديد من عمليات الزحف. أثناء التحليل، تم تمرير عناوين URL التي تم العثور عليها إلى مخدم URL الذي يتحقق مما إذا كان عنوان URL قد تم رؤيته مسبقاً. إذا لم يكن كذلك، تمت إضافة عنوان URL إلى قائمة انتظار مخدم URL.

- تم استخدام وب كراولر لإنشاء أول فهرس نص كامل متاح للجمهور لمجموعة فرعية من الوب. كان يعتمد على lib-WWW لتنزيل الصفحات، وبرنامج آخر لتحليل عناوين URL وطلبها لاستكشاف الرسم البياني للوب على نطاق واسع. كما تضمنت أيضاً زاحفاً في الوقت الفعلي يتتبع الروابط بناءً على تشابه نص الرابط مع الاستعلام المقدم.

- وب فاونتن هو زاحف معياري موزع يشبه مركاتور ولكنه مكتوب بلغة C++.

- زينون هو زاحف شبكة تستخدمه سلطات الضرائب الحكومية لاكتشاف الاحتيال.[51][52]

برامج زحف الشبكة التجارية

تتوفر برامج زحف الويب التالية بسعر:

- سورت سايت - الزاحف لتحليل مواقع الوب، متاح لنظامي التشغيل وندوز و ماك أو إس

- سويفت بوت - زاحف الوب الخاص بـ سويفت تايپ، متاح كـ البرمجيات كخدمة

برامج الزحف مفتوحة المصدر

- فرونتيرا عبارة عن إطار عمل لزحف الوب ينفذ مكوناً حدودياً للزحف ويوفر أساسيات قابلية التوسع لتطبيقات زحف الشبكة.

- جنو وجت عبارة عن سطر الأوامر - يتم تشغيله بواسطة الزاحف مكتوباً بـ سي وتم إصداره بموجب GPL. يتم استخدامه عادةً لعكس مواقع الوب و FTP.

- گرب كان برنامج زاحف بحث موزع مفتوح المصدر استخدمه بحث ويكيا لزحف الشبكة.

- هرتركس هو برنامج زحف جودة الأرشيف الخاص بـ أرشيف الإنترنت، وهو مصمم لأرشفة اللقطات الدورية لجزء كبير من الوب. كانت مكتوبة بلغة جاڤا.

- ht://Dig يتضمن زاحف الوب في محرك الفهرسة الخاص به.

- يستخدم إتش تي تراك زاحف الوب لإنشاء نسخة متطابقة من موقع وب للعرض دون اتصال بالإنترنت. تمت كتابته في [سي (لغة برمجة) | سي]] وتم إصداره بموجب GPL.

- منو گو سرتش هو برنامج زاحف ومفهرس ومحرك بحث مكتوب بلغة سي ومرخص بموجب GPL (* آلات NIX فقط)

- أپاتشي نتش هو زاحف وب قابل للتوسعة بدرجة كبيرة وقابل للتطوير مكتوب بلغة جاڤا وتم إصداره بموجب رخصة أپاتشى. يعتمد على أپاتشي هادوپ ويمكن استخدامه مع أپاتشي سولر أو إلاستك سرتش.

- أوپن سرتش سرڤر هو محرك بحث وإصدار برنامج زحف الوب بموجب GPL.

- زاحف پي إتش پي عبارة عن برنامج زحف پي إتش پي بسيط و ماي إس كيو إل تم إصداره بموجب ترخيص بي إس دي.

- سكراپي، إطار عمل وب كراولر مفتوح المصدر، مكتوب بلغة پايثون (مرخص بموجب بي إس دي).

- سيكس، محرك بحث موزع مجاني (مرخص بموجب AGPL).

- ستورم كراولر، مجموعة من الموارد لبناء برامج زحف وب منخفضة زمن الوصول وقابلة للتطوير على أپاتشي ستورم (رخصة أپاتشى).

- روبوت TkWWW، زاحف يعتمد على متصفح الوب tkWWW (مرخص بموجب GPL).

- زاپيان، محرك بحث زاحف، مكتوب بلغة سي++.

- ياسي، محرك بحث موزع حر، مبني على مبادئ شبكات نظير إلى نظير (مرخص بموجب GPL.

- Trandoshan، زاحف وب حر ومفتوح المصدر وموزع مصمم لشبكة الوب العميقة.

انظر أيضاً

- فهرسة مؤتمتة

- زاحف نوتيلا

- أرشفة الوب

- Webgraph

- Website mirroring software

- استخلاص محرك البحث

- استخلاص المواقع

المراجع

- ^ "Web Crawlers:Browsing the Web".

- ^ Spetka, Scott. "The TkWWW Robot: Beyond Browsing". NCSA. Archived from the original on 3 سبتمبر 2004. Retrieved 21 نوفمبر 2010.

- ^ Kobayashi, M. & Takeda, K. (2000). "Information retrieval on the web". ACM Computing Surveys. 32 (2): 144–173. CiteSeerX 10.1.1.126.6094. doi:10.1145/358923.358934. S2CID 3710903.

- ^ See definition of scutter on FOAF Project's wiki Archived 13 ديسمبر 2009 at the Wayback Machine

- ^ Masanès, Julien (15 فبراير 2007). Web Archiving. Springer. p. 1. ISBN 978-3-54046332-0. Retrieved 24 أبريل 2014.

- ^ Patil, Yugandhara; Patil, Sonal (2016). "Review of Web Crawlers with Specification and Working" (PDF). International Journal of Advanced Research in Computer and Communication Engineering. 5 (1): 4.

- ^ Edwards, J., McCurley, K. S., and Tomlin, J. A. (2001). "An adaptive model for optimizing performance of an incremental web crawler". Proceedings of the tenth international conference on World Wide Web - WWW '01. pp. 106–113. CiteSeerX 10.1.1.1018.1506. doi:10.1145/371920.371960. ISBN 978-1581133486. S2CID 10316730.

{{cite book}}:|journal=ignored (help)CS1 maint: multiple names: authors list (link) - ^ Castillo, Carlos (2004). Effective Web Crawling (PhD thesis). University of Chile. Retrieved 3 أغسطس 2010.

- ^ A. Gulls (2005). "The indexable web is more than 11.5 billion pages".: 902–903, ACM Press. doi:10.1145/1062745.1062789.

- ^ Steve Lawrence; C. Lee Giles (8 يوليو 1999). "Accessibility of information on the web". Nature. 400 (6740): 107–9. Bibcode:1999Natur.400..107L. doi:10.1038/21987. PMID 10428673. S2CID 4347646.

- ^ Cho, J.; Garcia-Molina, H.; Page, L. (أبريل 1998). "Efficient Crawling Through URL Ordering". Seventh International World-Wide Web Conference. Brisbane, Australia. doi:10.1142/3725. ISBN 978-981-02-3400-3. Retrieved 23 مارس 2009.

- ^ Cho, Junghoo, "Crawling the Web: Discovery and Maintenance of a Large-Scale Web Data", PhD dissertation, Department of Computer Science, Stanford University, November 2001

- ^ Marc Najork and Janet L. Wiener. Breadth-first crawling yields high-quality pages. In Proceedings of the Tenth Conference on World Wide Web, pages 114–118, Hong Kong, May 2001. Elsevier Science.

- ^ (2003) "Adaptive on-line page importance computation".: 280–290, Budapest, Hungary: ACM. doi:10.1145/775152.775192.

- ^ Paolo Boldi; Bruno Codenotti; Massimo Santini; Sebastiano Vigna (2004). "UbiCrawler: a scalable fully distributed Web crawler" (PDF). Software: Practice and Experience. 34 (8): 711–726. CiteSeerX 10.1.1.2.5538. doi:10.1002/spe.587. S2CID 325714. Archived from the original (PDF) on 20 مارس 2009. Retrieved 23 مارس 2009.

- ^ Paolo Boldi; Massimo Santini; Sebastiano Vigna (2004). "Do Your Worst to Make the Best: Paradoxical Effects in PageRank Incremental Computations" (PDF). Algorithms and Models for the Web-Graph. Lecture Notes in Computer Science. Vol. 3243. pp. 168–180. doi:10.1007/978-3-540-30216-2_14. ISBN 978-3-540-23427-2. Retrieved 23 مارس 2009.

- ^ Baeza-Yates, R., Castillo, C., Marin, M. and Rodriguez, A. (2005). Crawling a Country: Better Strategies than Breadth-First for Web Page Ordering. In Proceedings of the Industrial and Practical Experience track of the 14th conference on World Wide Web, pages 864–872, Chiba, Japan. ACM Press.

- ^ Shervin Daneshpajouh, Mojtaba Mohammadi Nasiri, Mohammad Ghodsi, A Fast Community Based Algorithm for Generating Crawler Seeds Set, In proceeding of 4th International Conference on Web Information Systems and Technologies (Webist-2008), Funchal, Portugal, May 2008.

- ^ Pant, Gautam; Srinivasan, Padmini; Menczer, Filippo (2004). "Crawling the Web" (PDF). In Levene, Mark; Poulovassilis, Alexandra (eds.). Web Dynamics: Adapting to Change in Content, Size, Topology and Use. Springer. pp. 153–178. ISBN 978-3-540-40676-1.

- ^ Cothey, Viv (2004). "Web-crawling reliability" (PDF). Journal of the American Society for Information Science and Technology. 55 (14): 1228–1238. CiteSeerX 10.1.1.117.185. doi:10.1002/asi.20078.

- ^ Menczer, F. (1997). ARACHNID: Adaptive Retrieval Agents Choosing Heuristic Neighborhoods for Information Discovery. In D. Fisher, ed., Machine Learning: Proceedings of the 14th International Conference (ICML97). Morgan Kaufmann

- ^ Menczer, F. and Belew, R.K. (1998). Adaptive Information Agents in Distributed Textual Environments. In K. Sycara and M. Wooldridge (eds.) Proc. 2nd Intl. Conf. on Autonomous Agents (Agents '98). ACM Press

- ^ Chakrabarti, Soumen; Van Den Berg, Martin; Dom, Byron (1999). "Focused crawling: A new approach to topic-specific Web resource discovery" (PDF). Computer Networks. 31 (11–16): 1623–1640. doi:10.1016/s1389-1286(99)00052-3. Archived from the original (PDF) on 17 مارس 2004.

- ^ Pinkerton, B. (1994). Finding what people want: Experiences with the WebCrawler. In Proceedings of the First World Wide Web Conference, Geneva, Switzerland.

- ^ Diligenti, M., Coetzee, F., Lawrence, S., Giles, C. L., and Gori, M. (2000). Focused crawling using context graphs. In Proceedings of 26th International Conference on Very Large Databases (VLDB), pages 527-534, Cairo, Egypt.

- ^ Wu, Jian; Teregowda, Pradeep; Khabsa, Madian; Carman, Stephen; Jordan, Douglas; San Pedro Wandelmer, Jose; Lu, Xin; Mitra, Prasenjit; Giles, C. Lee (2012). "Web crawler middleware for search engine digital libraries". Proceedings of the twelfth international workshop on Web information and data management - WIDM '12. p. 57. doi:10.1145/2389936.2389949. ISBN 9781450317207. S2CID 18513666.

- ^ Wu, Jian; Teregowda, Pradeep; Ramírez, Juan Pablo Fernández; Mitra, Prasenjit; Zheng, Shuyi; Giles, C. Lee (2012). "The evolution of a crawling strategy for an academic document search engine". Proceedings of the 3rd Annual ACM Web Science Conference on - Web Sci '12. pp. 340–343. doi:10.1145/2380718.2380762. ISBN 9781450312288. S2CID 16718130.

- ^ Dong, Hai; Hussain, Farookh Khadeer; Chang, Elizabeth (2009). "State of the Art in Semantic Focused Crawlers". Computational Science and Its Applications – ICCSA 2009. Lecture Notes in Computer Science. Vol. 5593. pp. 910–924. doi:10.1007/978-3-642-02457-3_74. hdl:20.500.11937/48288. ISBN 978-3-642-02456-6.

- ^ Dong, Hai; Hussain, Farookh Khadeer (2013). "SOF: A semi-supervised ontology-learning-based focused crawler". Concurrency and Computation: Practice and Experience. 25 (12): 1755–1770. doi:10.1002/cpe.2980. S2CID 205690364.

- ^ (2000) "Synchronizing a database to improve freshness".: 117–128, Dallas, Texas, United States: ACM. doi:10.1145/342009.335391.

- ^ أ ب E. G. Coffman Jr; Zhen Liu; Richard R. Weber (1998). "Optimal robot scheduling for Web search engines". Journal of Scheduling. 1 (1): 15–29. CiteSeerX 10.1.1.36.6087. doi:10.1002/(SICI)1099-1425(199806)1:1<15::AID-JOS3>3.0.CO;2-K.

- ^ أ ب Cho, Junghoo; Garcia-Molina, Hector (2003). "Effective page refresh policies for Web crawlers". ACM Transactions on Database Systems. 28 (4): 390–426. doi:10.1145/958942.958945. S2CID 147958.

- ^ أ ب Junghoo Cho; Hector Garcia-Molina (2003). "Estimating frequency of change". ACM Transactions on Internet Technology. 3 (3): 256–290. CiteSeerX 10.1.1.59.5877. doi:10.1145/857166.857170. S2CID 9362566.

- ^ Ipeirotis, P., Ntoulas, A., Cho, J., Gravano, L. (2005) Modeling and managing content changes in text databases. In Proceedings of the 21st IEEE International Conference on Data Engineering, pages 606-617, April 2005, Tokyo.

- ^ Koster, M. (1995). Robots in the web: threat or treat? ConneXions, 9(4).

- ^ Koster, M. (1996). A standard for robot exclusion Archived 7 نوفمبر 2007 at the Wayback Machine.

- ^ Koster, M. (1993). Guidelines for robots writers.

- ^ Baeza-Yates, R. and Castillo, C. (2002). Balancing volume, quality and freshness in Web crawling. In Soft Computing Systems – Design, Management and Applications, pages 565–572, Santiago, Chile. IOS Press Amsterdam.

- ^ Heydon, Allan; Najork, Marc (26 يونيو 1999). "Mercator: A Scalable, Extensible Web Crawler" (PDF). Archived from the original (PDF) on 19 فبراير 2006. Retrieved 22 مارس 2009.

{{cite journal}}: Cite journal requires|journal=(help) - ^ Dill, S.; Kumar, R.; Mccurley, K. S.; Rajagopalan, S.; Sivakumar, D.; Tomkins, A. (2002). "Self-similarity in the web" (PDF). ACM Transactions on Internet Technology. 2 (3): 205–223. doi:10.1145/572326.572328. S2CID 6416041.

- ^ M. Thelwall; D. Stuart (2006). "Web crawling ethics revisited: Cost, privacy and denial of service". Journal of the American Society for Information Science and Technology. 57 (13): 1771–1779. doi:10.1002/asi.20388.

- ^ Brin, Sergey; Page, Lawrence (1998). "The anatomy of a large-scale hypertextual Web search engine". Computer Networks and ISDN Systems. 30 (1–7): 107–117. doi:10.1016/s0169-7552(98)00110-x.

- ^ Shkapenyuk, V. and Suel, T. (2002). Design and implementation of a high performance distributed web crawler. In Proceedings of the 18th International Conference on Data Engineering (ICDE), pages 357-368, San Jose, California. IEEE CS Press.

- ^ Shestakov, Denis (2008). Search Interfaces on the Web: Querying and Characterizing Archived 6 يوليو 2014 at the Wayback Machine. TUCS Doctoral Dissertations 104, University of Turku

- ^ Michael L Nelson; Herbert Van de Sompel; Xiaoming Liu; Terry L Harrison; Nathan McFarland (24 مارس 2005). "mod_oai: An Apache Module for Metadata Harvesting": cs/0503069. arXiv:cs/0503069. Bibcode:2005cs........3069N.

{{cite journal}}: Cite journal requires|journal=(help) - ^ Shestakov, Denis; Bhowmick, Sourav S.; Lim, Ee-Peng (2005). "DEQUE: Querying the Deep Web" (PDF). Data & Knowledge Engineering. 52 (3): 273–311. doi:10.1016/s0169-023x(04)00107-7.

- ^ "AJAX crawling: Guide for webmasters and developers". Retrieved 17 مارس 2013.

- ^ Sun, Yang (25 أغسطس 2008). "A COMPREHENSIVE STUDY OF THE REGULATION AND BEHAVIOR OF WEB CRAWLERS. The crawlers or web spiders are software robots that handle trace files and browse hundreds of billions of pages found on the Web. Usually, this is determined by tracking the keywords that make the searches of search engine users, a factor that varies second by second: according to Moz, only 30% of searches performed on search engines like Google, Bing or Yahoo! corresponds generic words and phrases. The remaining 70% are usually random". Retrieved 11 أغسطس 2014.

{{cite journal}}: Cite journal requires|journal=(help) - ^ ITA Labs "ITA Labs Acquisition" 20 April 2011 1:28 AM

- ^ Crunchbase.com March 2014 "Crunch Base profile for import.io"

- ^ Norton, Quinn (25 يناير 2007). "Tax takers send in the spiders". Business. Wired. Archived from the original on 22 ديسمبر 2016. Retrieved 13 أكتوبر 2017.

- ^ "Xenon web crawling initiative: privacy impact assessment (PIA) summary". Ottawa: Government of Canada. 11 أبريل 2017. Archived from the original on 25 سبتمبر 2017. Retrieved 13 أكتوبر 2017.

للاستزادة

- Cho, Junghoo, "Web Crawling Project", UCLA Computer Science Department.

- A History of Search Engines, from Wiley

- WIVET is a benchmarking project by OWASP, which aims to measure if a web crawler can identify all the hyperlinks in a target website.

- Shestakov, Denis, "Current Challenges in Web Crawling" and "Intelligent Web Crawling", slides for tutorials given at ICWE'13 and WI-IAT'13.